在强化学习中 Sarsa 和 Q learning 类似。Sarsa 的决策部分和 Q learning 一模一样,因为使用的都是 Q 表的形式决策,所以会在 Q 表中挑选值较大的动作值施加在环境中来换取奖惩,但是不同的地方在于 Sarsa 的更新方式是不一样的。

Sarsa 更新行为准则

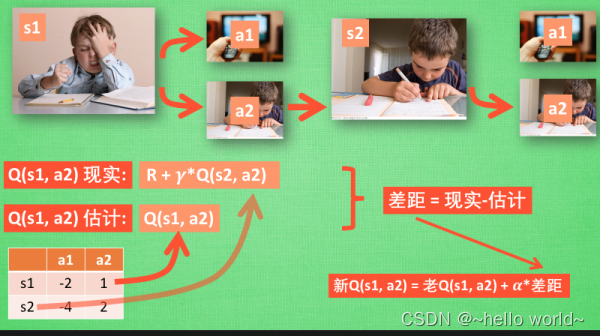

如上图,在写作业的状态 s1 时,接下来会选择一个带来最大潜在奖励的动作 a2,这样就到达了 继续写作业状态 s2。在这一步, 如果用的是 Q -learning,我们会考虑在 s2 上选取哪一个动作会带来最大的奖励,但是在真正要做决定时,却不一定会选取到那个带来最大奖励的动作,因为 Q-learning 在这一步只是估计了一下接下来的动作值。相反, Sarsa 是实践派,说到做到,即在 s2 这一步估算的动作也是接下来要做的动作。所以 Q(s1, a2) 现实的计算值, 去掉了 maxQ,取而代之的是在 s2 上实实在在选取的 a2 的 Q 值。最后像 Q learning 一样, 求出现实和估计的差距 并更新 Q 表里的 Q(s1, a2)。

.

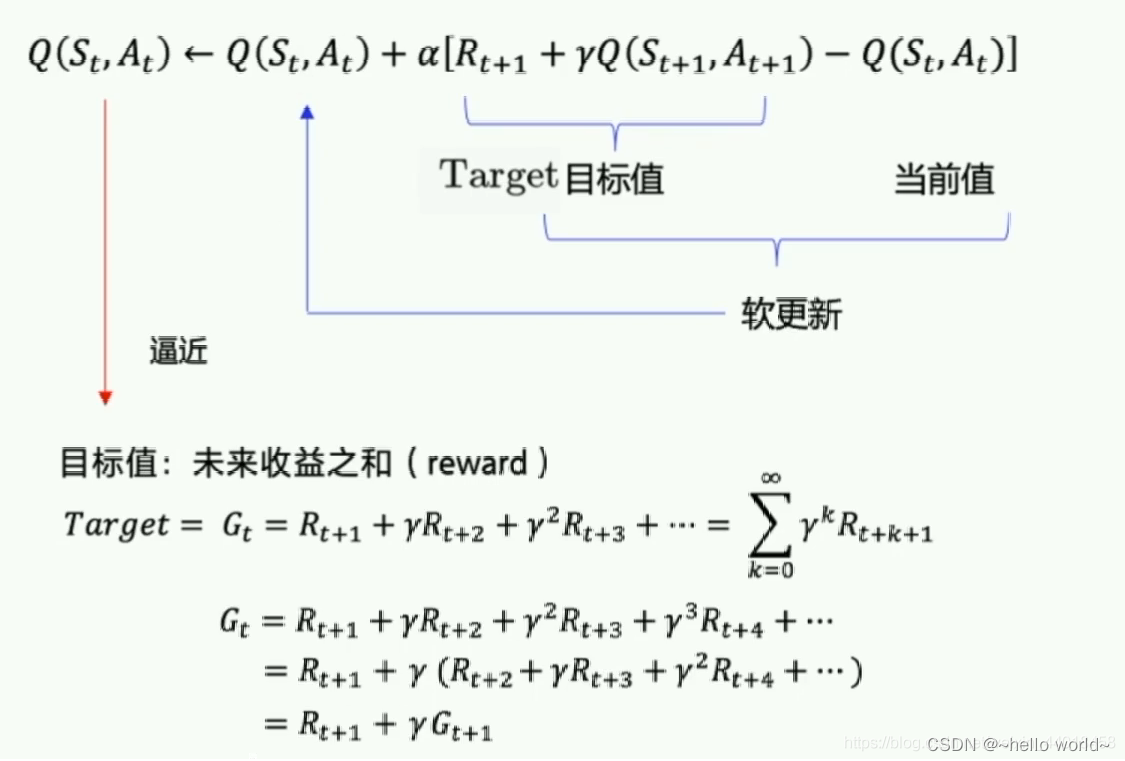

Sarsa全称是state-action-reward-state’-action’,目的是学习特定的 state 下,特定 action 的价值 Q,最终建立和优化一个 Q 表格,以 state 为行,action为列,根据与环境交互得到的 reward 来更新 Q 表格,更新公式如上图。Sarsa 在训练中为了更好的探索环境,常采用 ε-greedy 方式来训练,即有一定概率随机选择动作输出。

整个算法还是一直不断更新 Q table 里的值,然后再根据新的值来判断要在某个 state 采取怎样的 action。Sarsa 与 Q-learning 不同之处在于:

1、Sarsa 在当前 state 已经想好了 state 对应的 action,而且想好了 下一个 state_ 和下一个 action_ (Qlearning 还没有想好下一个 action_)

2、更新 Q(s,a) 的时候基于的是下一个 Q(s_, a_) (Q-learning 是基于 maxQ(s_))

这种不同之处使得 Sarsa 相对于 Q-learning 更加的胆小。 因为 Q-learning 永远都是想着 maxQ 最大化,因 maxQ 而变得贪婪,不考虑其他非 maxQ 的结果。 我们可以将 Q-learning 理解成一种贪婪、大胆、勇敢的算法,对于错误、死亡并不在乎。而 Sarsa 是一种保守的算法,他在乎每一步决策,对于错误和死亡比较敏感。

.

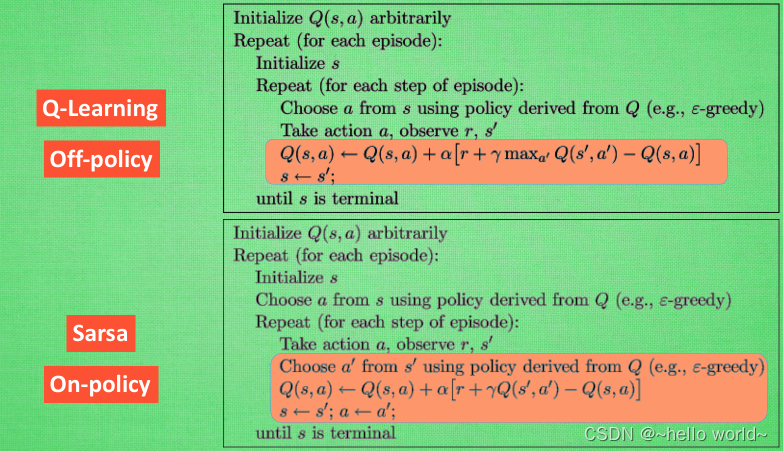

Sarsa 和 Q-learning 算法的对比

对比两者算法,不难发现,两者最大的不同之处在于 Sarsa 是说到做到型,所以也叫 on-policy (在线学习), 而 Q-learning 是说到但并不一定做到,所以它也叫作 Off-policy (离线学习) 。

Sarsa 算法实战

环境

import numpy as np

import time

import sys

if sys.version_info.major == 2:

import Tkinter as tk

else:

import tkinter as tk

UNIT = 40 # pixels

MAZE_H = 4 # grid height

MAZE_W = 4 # grid width

class Maze(tk.Tk, object):

def __init__(self):

super(Maze, self).__init__()

self.action_space = ['u', 'd', 'l', 'r']

self.n_actions = len(self.action_space)

self.title('maze')

self.geometry('{0}x{1}'.format(MAZE_W * UNIT, MAZE_H * UNIT))

self._build_maze()

def _build_maze(self):

self.canvas = tk.Canvas(self, bg='white',

height=MAZE_H * UNIT,

width=MAZE_W * UNIT)

# create grids

for c in range(0, MAZE_W * UNIT, UNIT):

x0, y0, x1, y1 = c, 0, c, MAZE_H * UNIT

self.canvas.create_line(x0, y0, x1, y1)

for r in range(0, MAZE_H * UNIT, UNIT):

x0, y0, x1, y1 = 0, r, MAZE_W * UNIT, r

self.canvas.create_line(x0, y0, x1, y1)

# create origin

origin = np.array([20, 20])

# hell

hell1_center = origin +</

Sarsa和Qlearning是强化学习中的两种算法,它们都使用Q表进行决策,但更新方式不同。Sarsa是实践派,按照实际选取的动作进行更新,而Qlearning则是基于最大奖励预期更新。Sarsa是on-policy(在线学习),Qlearning是off-policy(离线学习)。在实践中,Sarsa更保守,对错误敏感,而Qlearning更贪婪,追求最大奖励。

Sarsa和Qlearning是强化学习中的两种算法,它们都使用Q表进行决策,但更新方式不同。Sarsa是实践派,按照实际选取的动作进行更新,而Qlearning则是基于最大奖励预期更新。Sarsa是on-policy(在线学习),Qlearning是off-policy(离线学习)。在实践中,Sarsa更保守,对错误敏感,而Qlearning更贪婪,追求最大奖励。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

26

26

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?