如果有错误请指出

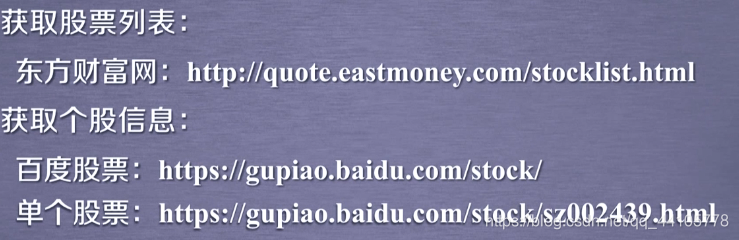

爬取的股票数据的位置的确定

步骤

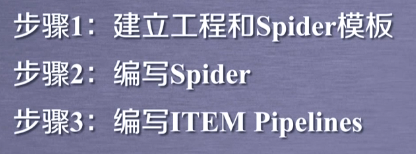

配置并发链接选项

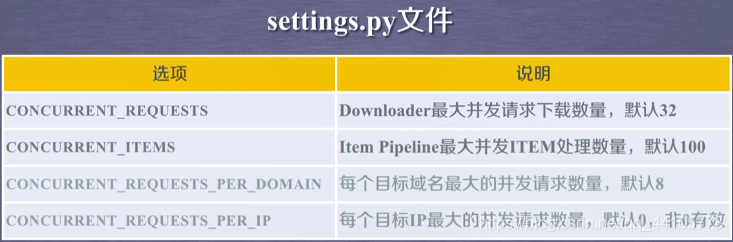

步骤一:

步骤二:编写spider文件

打开对应文件

# -*- coding: utf-8 -*-

import scrapy

import re

class StocksSpider(scrapy.Spider):

name = 'stocks'

allowed_domains = ['baidu.com']

start_urls = ['http://baidu.com/']

def parse(self, response):

#对页面中所有的a标签进行提取

for href in response.css('a::attr(href)').extract():

try:

stock = re.findall(r"[s][hz]\d{6}",href)[0]

url = 'https://gupiao.baidu.com/stock/'+stock + '.html'

yield scrapy.Request(url, callback = self.parse_stock)

except:

continue

#从百度股票的单个页面中提取信息的方法

def parse_stock(self,response):

infoDict = {}

stockInfo = response.css('.stock-bets')

name = stockInfo.css('.bets-name').extract()[0]

keyList = stockInfo.css('dt').extract()

valueList = stockInfo.css('dd').extract()

for i in range(len(keyList)):

key = re.findall(r'>.*<',keyList[i])[0][1:-5]

try:

val = re.findall(r'\d+\.?.*',valueList[i])[0][1:-5]

except:

val = '--'

infoDict[key] = val

infoDict.update(

{'股票名称': re.findall('\s.*\(',name)[0].split()[0] +re.findall('\>.*\<',name)[0][1:-1]})

yield infoDict

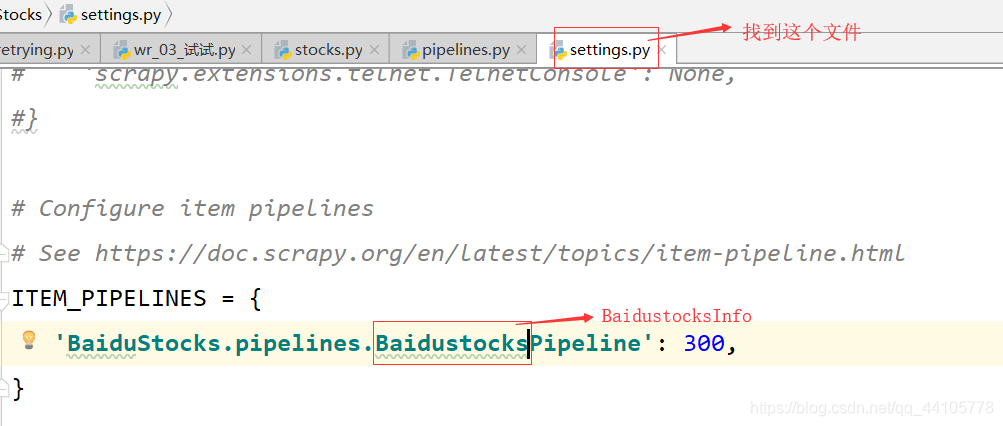

步骤三:编写Piplines

# -*- coding: utf-8 -*-

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://doc.scrapy.org/en/latest/topics/item-pipeline.html

class BaidustocksPipeline(object):

def process_item(self, item, spider):

return item

class BaidustocksInfoPipeline(object):

# 当一个爬虫被调用时对应的pipelines对应的方法

def open_spider(self,spider):

self.f = open('BaiduStockInfo.txt','w')

# 一个爬虫关闭或结束时对应的pipelines对应的方法

def close_spider(self,spider):

self.f.close()

# 对每个item项进行处理时对应的方法

def process_item(self,item,spider):

try:

line = str(dict(item))+'\n'

self.f.close(line)

except:

pass

return item

最后在cmd中,使用一下命令执行函数

scrapy crawl stocks

本文介绍如何使用Scrapy框架抓取网络上的股票数据,包括配置并发链接选项、编写Spider文件和Pipelines的过程。通过实例演示了如何解析网页中的股票信息,并将数据保存到本地文件。

本文介绍如何使用Scrapy框架抓取网络上的股票数据,包括配置并发链接选项、编写Spider文件和Pipelines的过程。通过实例演示了如何解析网页中的股票信息,并将数据保存到本地文件。

4491

4491

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?