今天内容包括建立一个二分类逻辑回归神经网络,并将损失函数和准确度进行可视化

全部代码

import tensorflow as tf

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

data = pd.read_csv('credit_a.csv', header=None) # 因为没有表头所以加入header=None

# print(data)

x = data.iloc[:, :-1]

y = data.iloc[:, [-1]].replace(-1, 0)

model = tf.keras.Sequential()

model.add(tf.keras.layers.Dense(4, input_shape=(15,), activation='relu'))

model.add(tf.keras.layers.Dense(4, activation='relu')) # 第二层开始不写输入参数shape,因为系统会根据上一层自动推断

model.add(tf.keras.layers.Dense(1, activation='sigmoid'))

# model.summary()

model.compile(optimizer='adam',

loss='binary_crossentropy',

metrics=['acc']

)

history = model.fit(x, y, epochs=100)

# print(history.history.keys())

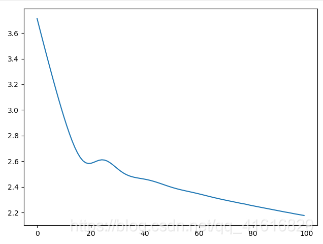

plt.plot(history.epoch, history.history.get('loss'))

plt.show()

plt.plot(history.epoch, history.history.get('acc'))

plt.show()

分布讲解

data = pd.read_csv('credit_a.csv', header=None) # 因为没有表头所以加入header=None

print(data)

model = tf.keras.Sequential()

model.add(tf.keras.layers.Dense(4, input_shape=(15,), activation='relu'))

model.add(tf.keras.layers.Dense(4, activation='relu')) # 第二层开始不写输入参数shape,因为系统会根据上一层自动推断

model.add(tf.keras.layers.Dense(1, activation='sigmoid'))

model.summary() #显示神经网络

这次建立一个两层隐藏层的神经网络,每一次4个神经元,因为是逻辑回归,所以最后一层的激活函数用的是sigmoid

model.compile(optimizer='adam',

loss='binary_crossentropy',

metrics=['acc']

)

history = model.fit(x, y, epochs=100)

开始训练了

因为是二分类逻辑回归,所以损失函数选择loss=‘binary_crossentropy’

metrics=[‘acc’]加入这个函数,可以显示准确度

最后的训练结果,hahah这么低,毕竟只有10个数据

print(history.history.keys())

训练过程history.history是一个字典变量,用keys()得到它的keys,可以看到有loss和acc

plt.plot(history.epoch, history.history.get('loss'))

plt.show()

将损失函数可视化

plt.plot(history.epoch, history.history.get('acc'))

plt.show()

将准确度可视化,hahha不要在意结果

50

50

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?