文章目录

机器学习基础算法–决策树与决策森林实践(三)

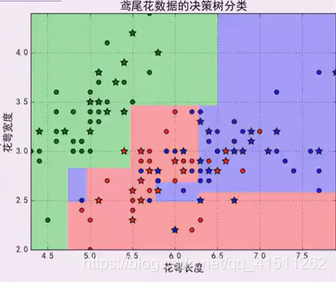

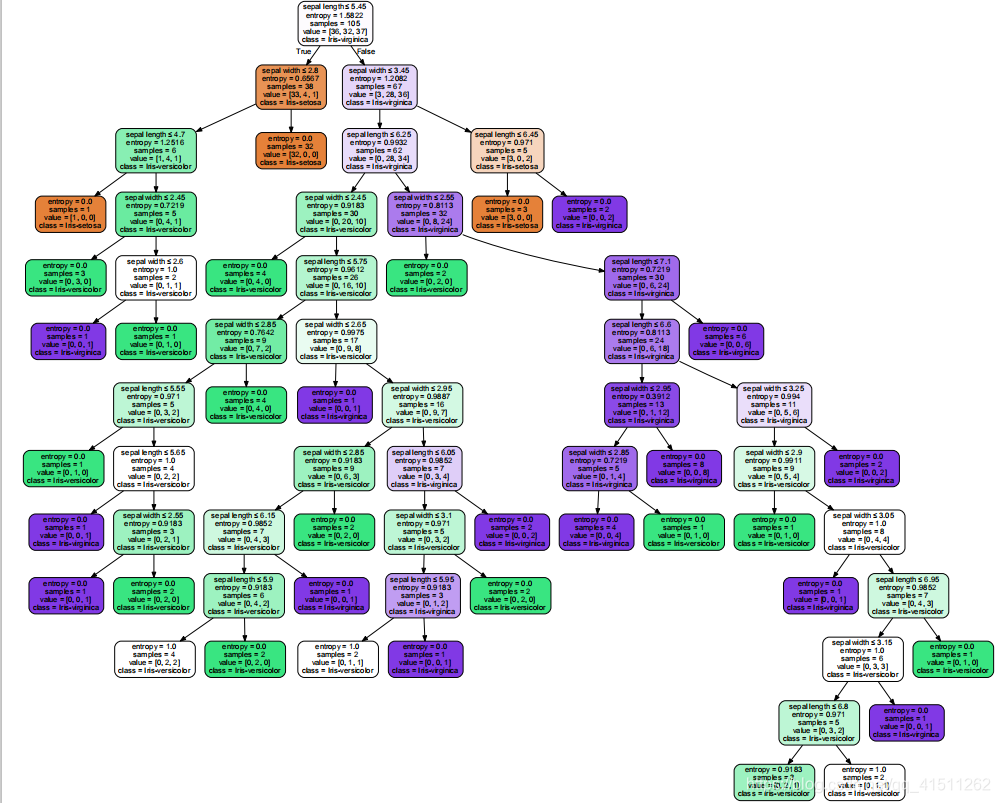

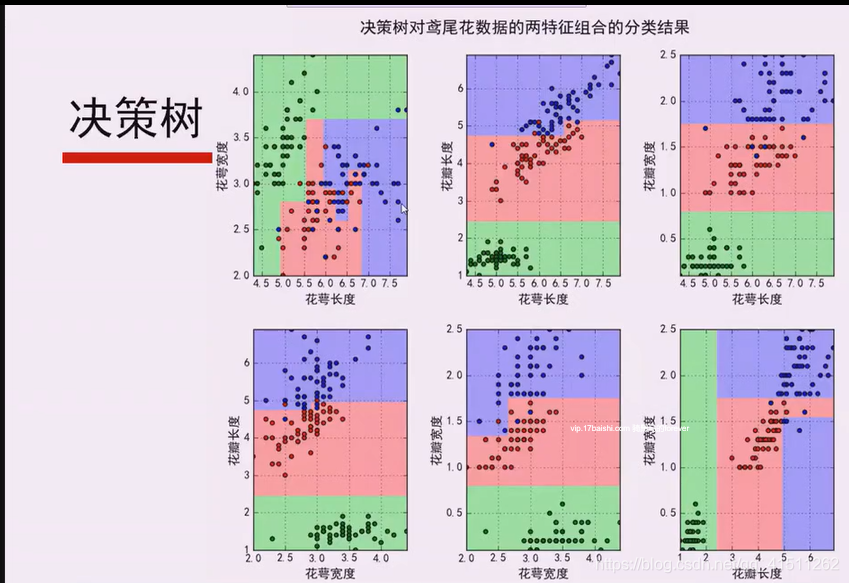

一、鸢尾花数据决策树

分成三类:分别标为紫色,黄色和绿色。它们的信息熵为0.

二、决策树的过拟合

(一)定义

决策树对训练属于有很好的分类能力,但对 未知的测试数据未必有好的分类能力,泛化能力弱,即可能发生过拟合现象。

剪枝

随机森林

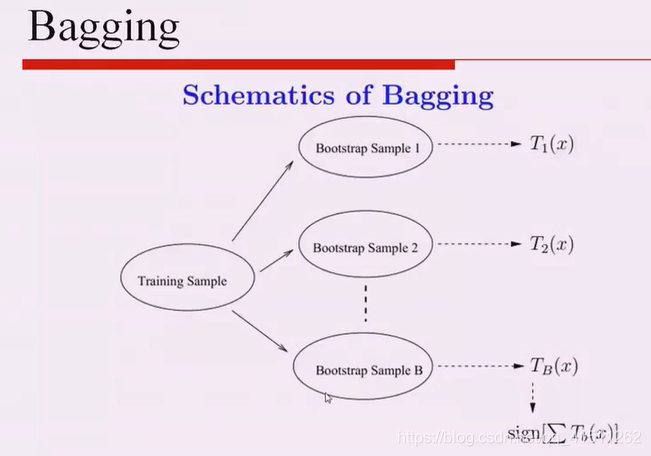

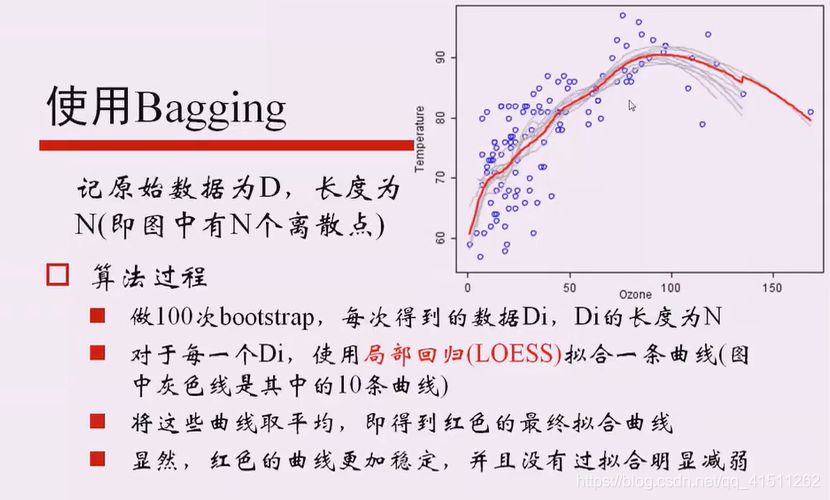

(二)采用Bagging的策略提升分类准确率

a、bootstrap aggregation

b、从样本集中重采样(有重复的)选出n个样本

c、在所有属性上,对这n个样本建立分类器(ID3、 C4.5、CART、Logistic回归等)

重复以上两步m次,

d、即获得了m个分类器

e、将数据放在这m个分类器上,最后根据这m 个分类器的投票结果,决定 数据属于

哪一类

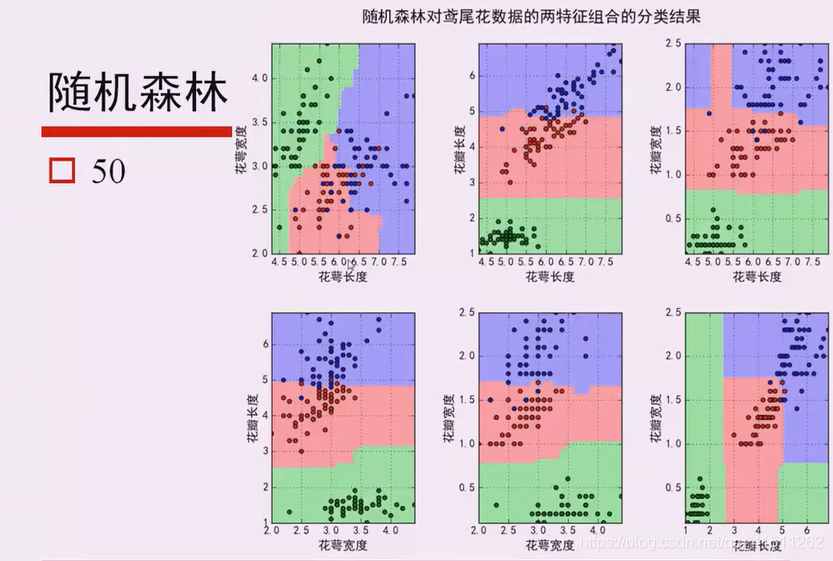

(三)随机森林

■ 随机森林在bagging基础上做了修改。

从样本集中用Bootstrap采样选出n个样本;

从所有属性中随机选择k个属性,选择最佳分割属性作为节点建立CART决策树;

■重复以上两步m次,即建立了m棵CART决策树

这m个CART形成随机森林,通过投票表决结果,决定数据属于哪一类

(四)随机森林/Bagging和决策树的关系

■当然可以使用决策树作为基本分类器

■但也可以使用SVM、Logistic回归等其他分类器,习惯上,这些分类器组成的“总分类器”,仍然叫做随机森林。

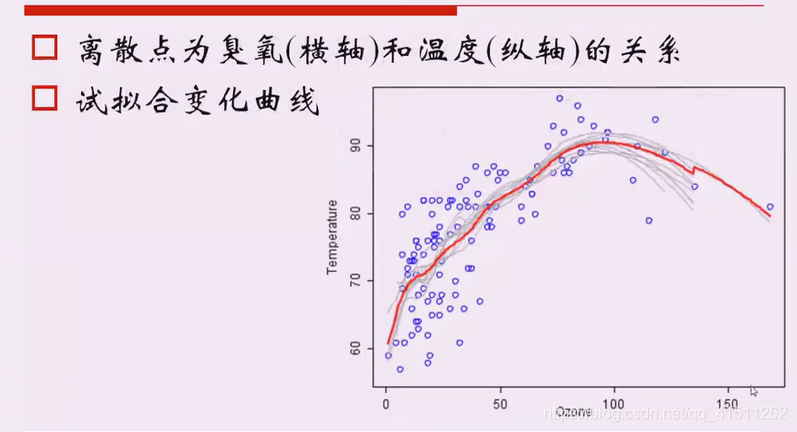

■举例

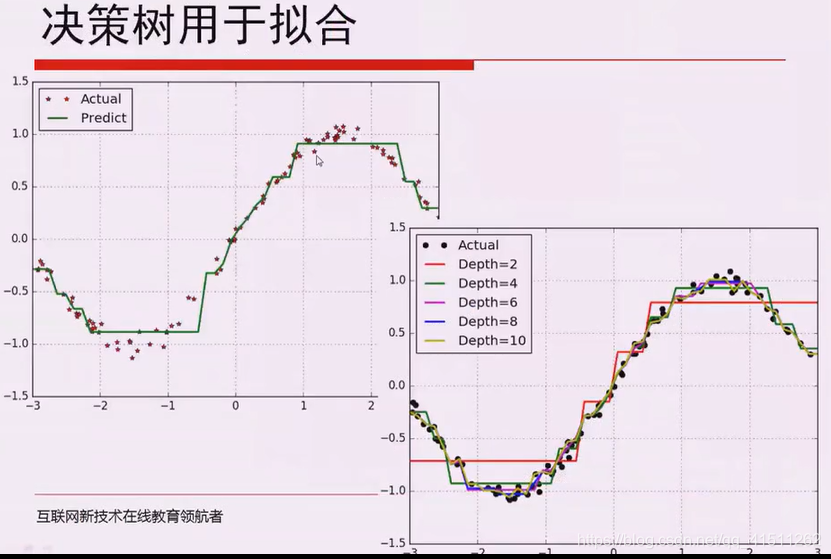

回归问题应用举例

(五)样本不均衡的常用处理方法

口假定样本数目A类比B类多,且严重不平衡:

A类欠采样Undersampling

口随机欠采样

口A类分成若干子类,分别与B类进入ML模型

口基于聚类的A类分割

B类过采样Oversampling

口避免欠采样造成的信息丢失

B类数据合成Synthetic Data Generation

口随机插值得到新样本

口 SMOTE(Synthetic Minority Over-sampling Technique)

代价敏感学习Cost Sensitive Learning

口降低A类权值,提高B类权值

(六)使用随机森林计算特征重要度

口随机森林是常用的衡量特征重要性的方法。

计算正例经过的结点,使用经过结点的数目、经过结点的gini系数和等指标。或者,

随机替换一列数据,重新建立决策树,计算新模型的正确率变化,从而考虑这一列

特征的重要性。

口selection frequency

口gini importance

口permutation importance

(七)总结

口 决策树/随机森林的代码清晰、逻辑简单,在胜任分类问题的同时,往往也可以作为对数据分布

探索的首要尝试算法。

口随机森林的集成思想也可用在其他分类器的设计中。

口如果通过随机森林做样本的异常值检测?

■统计样本间位于相同决策树的叶结点的个数,形成样本相似度矩阵。

口如果正负样本数量差别很大,如何处理?

口思考:在得到新决策树后,对样本的权值进行合理的调整一 分类正确的则降低权值,分类错误的

则增大权值一-是否可行?

三、决策树的用途实例

本文探讨了决策树算法在鸢尾花数据集上的应用,分析了决策树的过拟合问题及解决策略,包括剪枝、Bagging和随机森林方法。介绍了随机森林通过集成多个决策树提升分类准确率,并讨论了样本不均衡处理、特征重要度计算及决策树的实用案例。

本文探讨了决策树算法在鸢尾花数据集上的应用,分析了决策树的过拟合问题及解决策略,包括剪枝、Bagging和随机森林方法。介绍了随机森林通过集成多个决策树提升分类准确率,并讨论了样本不均衡处理、特征重要度计算及决策树的实用案例。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?