1、数据集介绍

采用了清华NLP组提供的THUCNews新闻文本分类数据集的子集。其中训练集一共有 180000 条,验证集一共有 10000 条,测试集一共有 10000 条。其类别为 finance、realty、stocks、education、science、society、politics、sports、game、entertainment 十个类别。

2、BERT模型

BERT是Bidirectional Encoder Representations from Transformers的缩写,是一种为自然语言处理 (NLP) 领域设计的开源机器学习框架。该框架起源于 2018 年,由 Google AI Language 的研究人员精心打造。

预训练模型下载地址:https://huggingface.co/google-bert

如果使用英文数据集则使用bert-base-uncased,如果是中文数据集则使用bert-base-chinese。

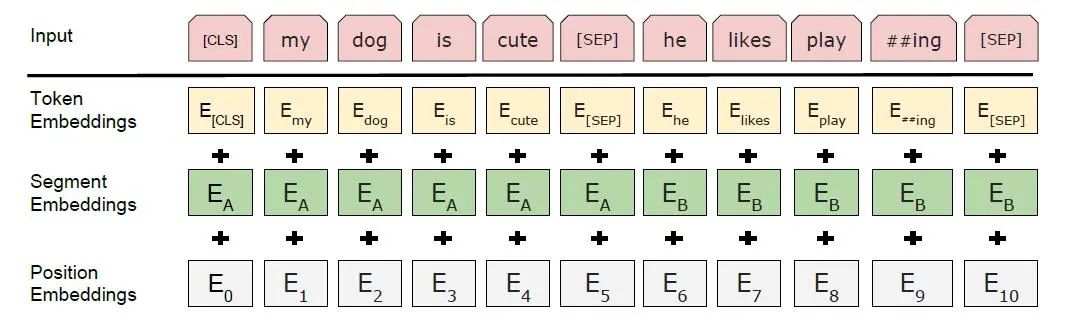

BERT Embedding模块如下:

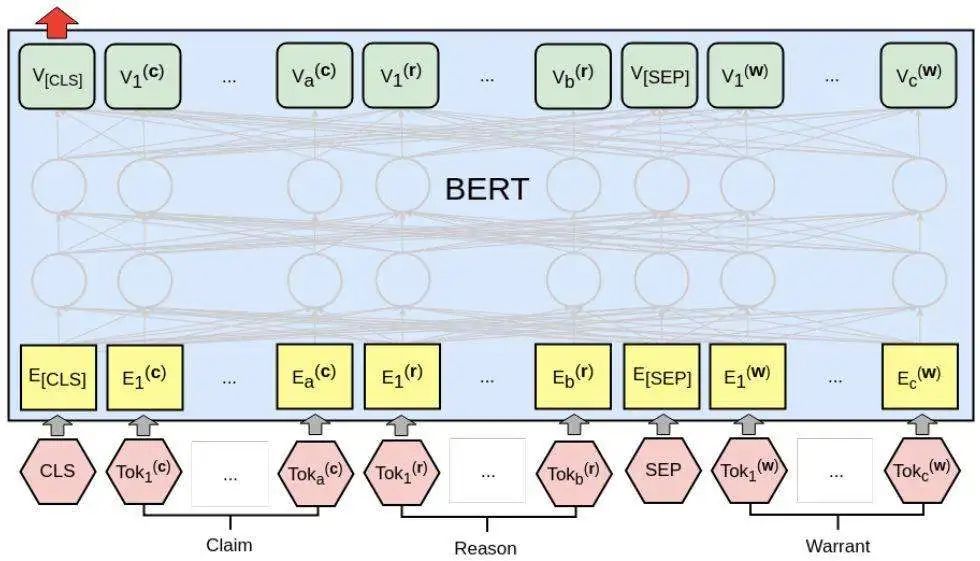

BERT文本分类模型如下:

3、代码实现

文末免费获取数据集和源码压缩包。

训练曲线及测试精度:

进入下面公众号聊天窗口回复“BERT文本分类”即可获取完整源码。

最后:

小编会不定期发布相关设计内容包括但不限于如下内容:信号处理、通信仿真、算法设计、matlab appdesigner,gui设计、simulink仿真......希望能帮到你!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?