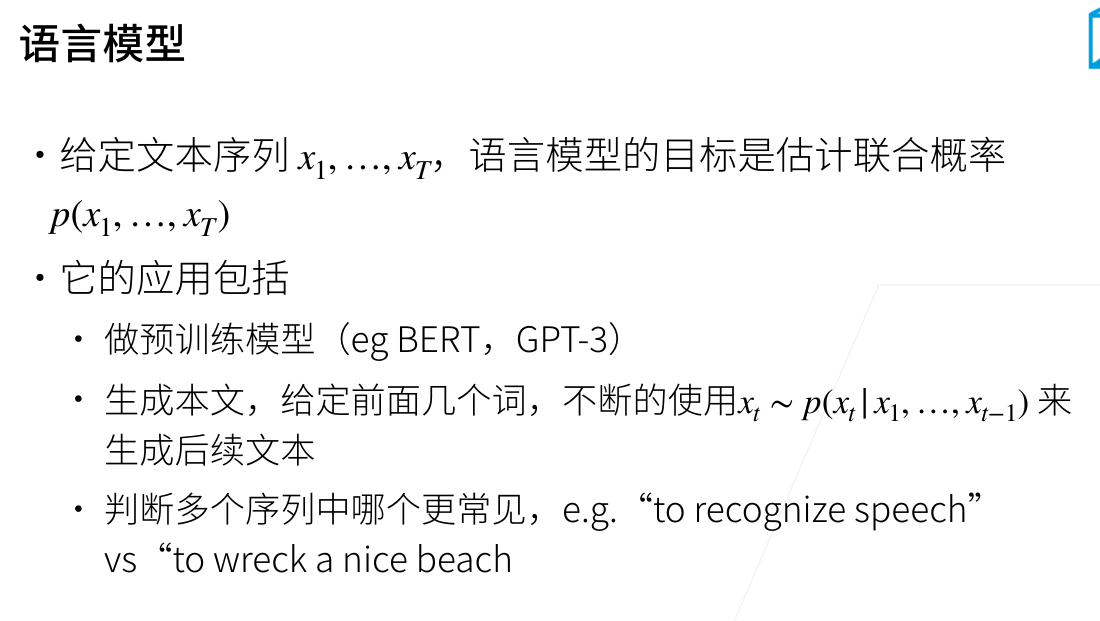

语言模型(Language Model)是自然语言处理(NLP)中的一个核心概念,用于计算一个序列(通常是句子或文本段落)出现的概率。语言模型的核心思想是通过对大量文本数据的训练,学习到语言的统计规律,进而能够预测下一个词或序列的概率。

语言模型(Language Model)是自然语言处理(NLP)中的一个核心概念,用于计算一个序列(通常是句子或文本段落)出现的概率。语言模型的核心思想是通过对大量文本数据的训练,学习到语言的统计规律,进而能够预测下一个词或序列的概率。

语言模型有多种形式,包括统计语言模型和神经网络语言模型等。以下是关于语言模型的一些详细解释:

统计语言模型

统计语言模型基于概率论和统计学原理,通过计算给定序列的概率来评估其合理性。常见的统计语言模型包括n元模型(n-gram model)和隐马尔可夫模型(Hidden Markov Model, HMM)。

- n元模型(n-gram model):n元模型是一种基于统计的语言模型,它通过计算文本中连续出现的n个词的序列的概率来评估文本的合理性。例如,二元模型(bigram)计算两个连续词的概率,三元模型(trigram)计算三个连续词的概率。n元模型的一个主要挑战是数据稀疏性,即随着n的增加,某些n元组的出现频率可能为0,导致无法计算其概率。

- 隐马尔可夫模型(HMM):HMM是一种基于概率的模型,用于描述一个含有隐含未知参数的马尔可夫过程。在NLP中,HMM通常用于词性标注和命名实体识别等任务。

神经网络语言模型

随着深度学习的发展,神经网络语言模型逐渐成为主流。神经网络语言模型使用神经网络结构(如循环神经网络RNN、长短时记忆网络LSTM、Transformer等)来捕捉文本中的长距离依

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3925

3925

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?