继上次我们在机器中配置好了CentOS7,这次我们来配置实验环境

这次我们要来安装Hadoop伪集群

Hadoop 介绍

Hadoop是一个由Apache基金会所开发的分布式系统基础架构。用户可以在不了解分布式底层细节的情况下,开发分布式程序。充分利用集群的威力进行高速运算和存储。Hadoop实现了一个分布式文件系统(Hadoop Distributed File System),简称HDFS。HDFS有高容错性的特点,并且设计用来部署在低廉的(low-cost)硬件上;而且它提供高吞吐量(high throughput)来访问应用程序的数据,适合那些有着超大数据集(large data set)的应用程序。HDFS放宽了(relax)POSIX的要求,可以以流的形式访问(streaming access)文件系统中的数据。Hadoop的框架最核心的设计就是:HDFS和MapReduce。HDFS为海量的数据提供了存储,而MapReduce则为海量的数据提供了计算

Hadoop 安装配置

前置实验环境:CentOS 7

Hadoop下载链接:(可以从Apache官网下载,不过我嫌太慢了,直接到清华镜像站里下载)

Hadoop 3.1.3: /apache/hadoop/common/hadoop-3.1.3 - 清华镜像站

参考:

https://zhuanlan.zhihu.com/p/45166521

https://zhuanlan.zhihu.com/p/73461795

前置环境配置

修改ip地址

在虚拟机的命令行中输入下面的命令,即使用vim编辑器修改网卡的配置文件

$ vim /etc/sysconfig/network-scripts/ifcfg-ens33

配置如下:

TYPE=Ethernet

PROXY_METHOD=none

BROWSER_ONLY=no

BOOTPROTO=static

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=ens33

UUID=55f92893-e87e-44fd-b89b-d6d813407263

DEVICE=ens33

ONBOOT=yes

IPADDR=192.168.52.130

NETMASK=255.255.255.0

DNS1=114.114.114.114

DNS2=8.8.8.8

重启网卡使配置生效

$ sudo service network restart

修改主机名

CentOS 7可以使用hostnamectl命令,直接修改主机名

hostnamectl set-hostname magic

修改ip地址和主机名的映射关系

用vim编辑器修改/etc/hosts文件

$ vim /etc/hosts

添加一行新的映射,然后保存退出

192.168.52.130 magic

关闭防火墙

CentOS 7的防火墙服务为firewalld,不再使用IPtables了

systemctl stop firewalld #关闭防火墙服务网

systemctl disable firewalld #设置防火墙服务开机不启动

安装JDK

Hadoop 3.x要求JDK的版本必须是java 8,下载地址:jdk-8u161-linux-x64.tar.gz

$ sudo mv jdk-8u251-linux-x64.tar.gz /usr/local/

$ sudo tar -zxvf jdk-8u251-linux-x64.tar.gz

$ # set environment

$ vim /etc/profile

在profile里添加以下环境变量

export JAVA_HOME=/usr/local/jdk1.8.0_251

export PATH=$PATH:$JAVA_HOME/bin

然后重新加载环境变量

$ source /etc/profile

下载安装Hadoop

$ wget https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-3.1.3/

$ mkdir /hadoop

$ tar -zxvf hadoop-3.1.3.tar.gz -C /hadoop/

$ cd /hadoop/hadoop-3.1.3/

修改配置文件

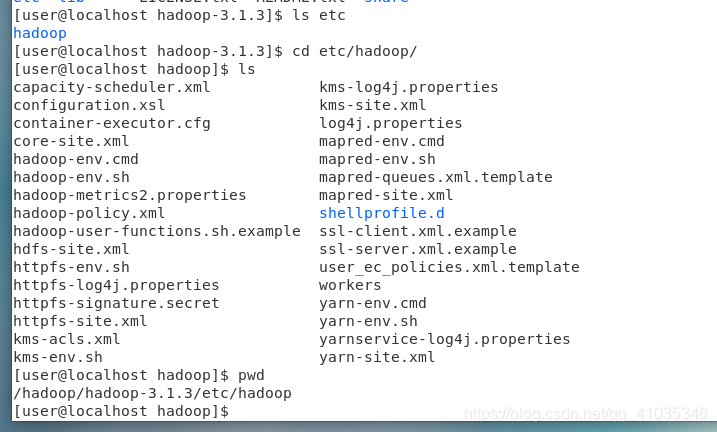

在hadoop安装目录下有一个etc目录,里面存放着hadoop的配置文件(注意不要和linux的/etc搞混)

在我们这个实例中,etc位于/hadoop/hadoop-3.1.3/etc/hadoop,如下

[user@localhost hadoop]$ pwd

/hadoop/hadoop-3.1.3/etc/hadoop

[user@localhost hadoop]$ ll

total 172

-rw-r--r--. 1 user user 8260 Sep 12 2019 capacity-scheduler.xml

-rw-r--r--. 1 user user 1335 Sep 12 2019 configuration.xsl

-rw-r--r--. 1 user user 1940 Sep 12 2019

本文详细介绍了如何在CentOS7上安装配置Hadoop 3.1.3的伪集群。内容包括前置环境配置如修改ip、主机名、关闭防火墙、安装JDK,下载安装Hadoop,以及一系列的配置文件修改,如core-site.xml、hdfs-site.xml、mapred-site.xml和yarn-site.xml。最后,文章还提到了如何启动HDFS和YARN,并测试Hadoop环境,包括访问HDFS和YARN的管理页面。

本文详细介绍了如何在CentOS7上安装配置Hadoop 3.1.3的伪集群。内容包括前置环境配置如修改ip、主机名、关闭防火墙、安装JDK,下载安装Hadoop,以及一系列的配置文件修改,如core-site.xml、hdfs-site.xml、mapred-site.xml和yarn-site.xml。最后,文章还提到了如何启动HDFS和YARN,并测试Hadoop环境,包括访问HDFS和YARN的管理页面。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1139

1139

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?