线性回归算法简介

定义

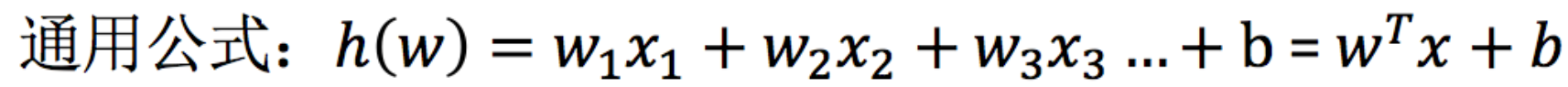

线性回归(Linear regression)是利用回归方程(函数)对一个或多个自变量(特征值)和因变量(目标值)之间关系进行建模的一种分析方式。

线性回归的特征与目标的关系分析

线性回归当中主要有两种模型,一种是线性关系,另一种是非线性关系。

线性回归API初步调用

from sklearn.linear_model import LinearRegression

x = [[80, 86],

[82, 80],

[85, 78],

[90, 90],

[86, 82],

[82, 90],

[78, 80],

[92, 94]]

y = [84.2, 80.6, 80.1, 90, 83.2, 87.6, 79.4, 93.4]

# 实例化API

estimator = LinearRegression()

# 使用fit方法进行训练

estimator.fit(x,y)

estimator.predict([[100, 80]])

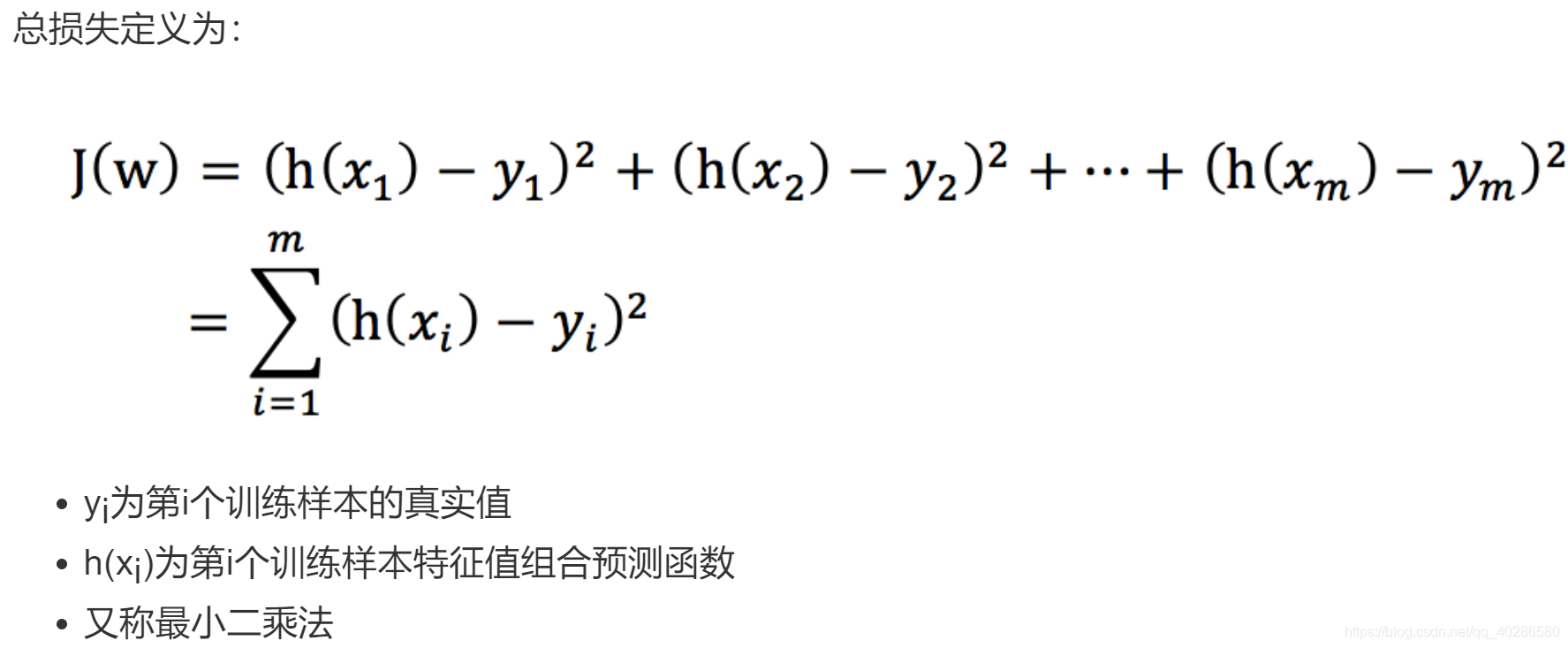

线性回归的损失和优化

损失函数

优化函数

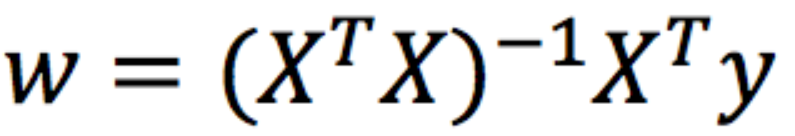

正规方程

去求模型当中的W,使得损失最小:

缺点:当特征过多过复杂时,求解速度太慢并且得不到结果

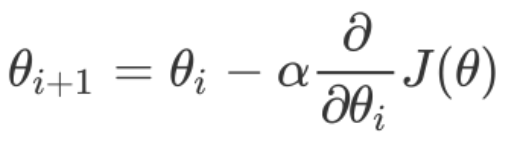

梯度下降

什么是梯度下降?

梯度下降法的基本思想可以类比为一个下山的过程。

假设这样一个场景:

一个人被困在山上,需要从山上下来(i.e. 找到山的最低点,也就是山谷)。但此时山上的浓雾很大,导致可视度很低。

因此,下山的路径就无法确定,他必须利用自己周围的信息去找到下山的路径。这个时候,他就可以利用梯度下降算法来帮助自己下山。

具体来说就是,以他当前的所处的位置为基准,寻找这个位置最陡峭的地方,然后朝着山的高度下降的地方走,(同理,如果我们的目标是上山,也就是爬到山顶,那么此时应该是朝着最陡峭的方向往上走)。然后每走一段距离,都反复采用同一个方法,最后就能成功的抵达山谷。

梯度下降公式:

α在梯度下降算法中被称作为学习率或者步长,意味着我们可以通过α来控制每一步走的距离,以保证不要步子跨的太大扯着蛋,哈哈,其实就是不要走太快,错过了最低点。同时也要保证不要走的太慢,导致太阳下山了,还没有走到山下。所以α的选择在梯度下降法中往往是很重要的!

梯度前加一个负号,就意味着朝着梯度相反的方向前进!梯度的方向实际就是函数在此点上升最快的方向!而我们需要朝着下降最快的方向走,自然就是负的梯度的方向,所以此处需要加上负号。

本文深入解析线性回归算法,涵盖线性回归的定义、模型类型、API调用示例、损失函数优化方法及梯度下降原理。适合初学者快速掌握线性回归的核心概念。

本文深入解析线性回归算法,涵盖线性回归的定义、模型类型、API调用示例、损失函数优化方法及梯度下降原理。适合初学者快速掌握线性回归的核心概念。

925

925

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?