Windows7下安装单机Hadoop3.1.2

版本信息

- win7

- jdk1.8

- hadoop3.1.2

安装过程

- 安装JDK1.8

- 安装hadoop3.1.2

(1)从官网下载(http://hadoop.apache.org/),下载Hadoop,并解压到你的本地目录,我下载的是hadoop-3.1.2版本,解压在G:\Hadoop\hadoop-3.1.2。

下载winutils相关,hadoop在windows上运行需要winutils支持和hadoop.dll等文件。(附上资源链接:链接:https://pan.baidu.com/s/1_DRSSiwtatSnEHkQ73wReA

提取码:rfn8 )

下载对应版本的就可以,例如我用的是3.1.2,可以直接下载3.0.0的就好。然后将全部bin目录文件替换至hadoop目录下的bin目录。

下载链接是:https://github.com/steveloughran/winutils/tree/master/hadoop-3.0.0/bin

(2)配置Hadoop的环境变量

路径:计算机 –>属性 –>高级系统设置 –>高级选项卡 –>环境变量 –> 单击新建

新建HADOOP_HOME变量 地址为G:\Hadoop\hadoop-3.1.2,示意图如下:

上图换成你自己的hadoop目录即可。

上图换成你自己的hadoop目录即可。

新建HADOOP_CONF_DIR变量 地址为 %HADOOP_PREFIX%\etc\hadoop,如下图:

新建YARN_CONF_DIR 变量 地址为%HADOOP_CONF_DIR%,如下图:

新建YARN_CONF_DIR 变量 地址为%HADOOP_CONF_DIR%,如下图:

最后path添加%HADOOP_HOME%/bin

最后path添加%HADOOP_HOME%/bin

(3)配置Hadoop文件

a. 编辑“G:\Hadoop\hadoop-3.1.2\etc\hadoop”下的core-site.xml文件,将下列文本粘贴进去,并保存。

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>D:/hadoop-3.1.2/tmp</value>

</property>

<property>

<name>dfs.name.dir</name>

<value>/D:/hadoop-3.1.2/name</value>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>b.编辑“G:\Hadoop\hadoop-3.1.2\etc\hadoop”目录下的mapred-site.xml(如果不存在将mapred-site.xml.template重命名为mapred-site.xml)文件,粘贴一下内容并保存。

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapred.job.tracker</name>

<value>hdfs://localhost:9001</value>

</property>

</configuration>

c.编辑“G:\Hadoop\hadoop-3.1.2\etc\hadoop”目录下的hdfs-site.xml文件,粘贴以下内容并保存。

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/d:/hadoop-3.1.2/data/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/d:/hadoop-3.1.2/data/datanode</value>

</property>

</configuration>d.编辑“G:\Hadoop\hadoop-3.1.2\etc\hadoop”目录下的yarn-site.xml文件,粘贴以下内容并保存。

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>e.编辑“G:\Hadoop\hadoop-3.1.2\etc\hadoop”目录下的hadoop-env.cmd文件,将JAVA_HOME设置为你的JDK地址。

set JAVA_HOME=<填入你自己的JDK地址>

(4)启动HDFS

格式化namenode(第一次启动前执行,只执行一次)

hdfs namenode -format

运行cmd窗口,切换到hadoop的sbin目录,执行start-all.cmd,它将会启动以下4个进程窗口。

用 jps命令验证,出现四个进程信息。

浏览器访问

http://localhost:9870/

http://localhost:8088/

- 过程出现的问题

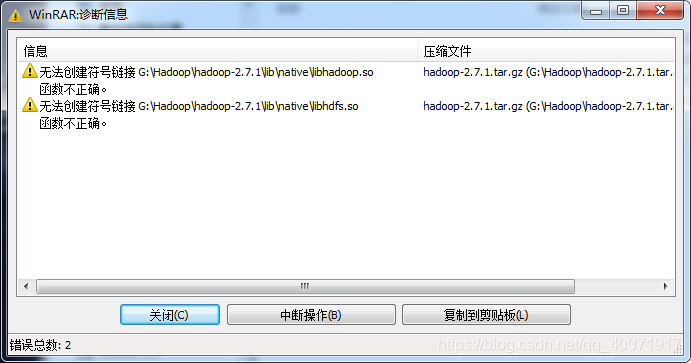

Hadoop解压问题

解决方法:用户管理员权限(必须管理权权限,否则无效)启动cmd。

解决方法:用户管理员权限(必须管理权权限,否则无效)启动cmd。

start winrar x -y hadoop-3.1.2.tar.gz G:\Hadoop

或者进入待解压文件目录下

start winrar x -y hadoop-3.1.2.tar.gz

JPS命令报错

一开始以为是默认的创建java进程文件没有写权限,修改了以后还是不能使用jps。再后来才知道是JDK没有安装好。

配置好环境变量

配置好环境变量

在cmd里面输入javac能看到信息后,就解决了。

参考文献

[1]https://blog.youkuaiyun.com/shuoyu816/article/details/90574003

[2]https://blog.youkuaiyun.com/Accpwo/article/details/84915921

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?