<think>好的,我现在需要帮助用户在MATLAB中绘制sigmoid、tanh、ReLU和LeakyReLU激活函数的图像。首先,我得回忆一下这些激活函数的数学表达式,然后考虑如何在MATLAB中实现它们。

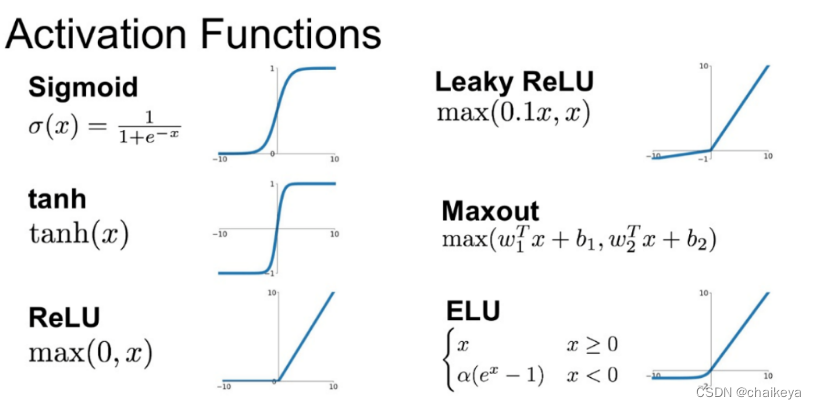

首先,用户提到了四个激活函数:sigmoid、tanh、ReLU和LeakyReLU。我需要逐一确认每个函数的定义。比如,sigmoid函数通常是$f(x) = \frac{1}{1 + e^{-x}}$,tanh是双曲正切函数,表达式为$f(x) = \frac{e^x - e^{-x}}{e^x + e^{-x}}$,或者也可以用双曲函数库里的函数。ReLU比较简单,就是$f(x) = \max(0, x)$,而LeakyReLU则是当x小于0时,乘以一个小的斜率,比如0.01,所以表达式是$f(x) = \begin{cases} x & \text{if } x \geq 0 \\ 0.01x & \text{otherwise} \end{cases}$。

接下来,考虑如何在MATLAB中实现这些函数。对于sigmoid,可能需要用元素级运算,比如用exp函数计算指数。同样,tanh在MATLAB中可能有内置函数,但为了准确起见,可能需要手动实现或者调用正确的函数。ReLU和LeakyReLU可以用条件判断,或者更高效的方式,比如逐元素比较。

然后,关于绘图部分。用户希望将这四个函数绘制出来。在MATLAB中,通常需要生成一个x值的向量,然后计算对应的y值,再使用plot函数绘制。可能需要设置不同的颜色和线条样式来区分各个激活函数。同时,添加网格、标签、标题和图例也是必要的步骤,以便图像更清晰。

需要注意的几点:首先,生成x的范围,比如从-5到5,步长0.1,这样可以覆盖函数的典型变化区域。其次,处理每个函数时,确保数组运算正确,避免维度错误。例如,sigmoid函数中的指数运算应该是对每个元素进行操作,而不是矩阵运算。可能需要使用点运算符(如.*和.^)来确保按元素计算。

对于LeakyReLU,可能需要使用逻辑索引来处理x中大于等于0和小于0的部分。例如,在MATLAB中,可以这样实现:y = x .* (x >= 0) + 0.01 * x .* (x < 0)。或者使用max函数结合不同的条件。

另外,用户提到在Python中使用detach()来切断计算图,但在MATLAB中不需要处理张量计算图的问题,因为MATLAB主要用于数值计算而不是深度学习框架中的自动微分。因此,这部分可以忽略,直接处理普通的数值数组即可。

接下来,需要整合这些步骤到一个MATLAB脚本中。可能需要分几个子图,或者在同一图中用不同颜色绘制,但考虑到四个函数放在同一图中可能比较拥挤,所以分四个子图更合适,每个子图显示一个函数。

然后,检查代码的正确性。例如,sigmoid函数是否计算正确,tanh是否有内置函数或者是否需要手动实现。在MATLAB中,tanh函数是内置的,可以直接使用。ReLU可以用max函数,LeakyReLU可能需要逻辑索引。

最后,确保图像的展示效果良好,包括坐标轴标签、标题、图例、网格线等。可能需要使用hold on来在同一图中绘制多个函数,但如果是分四个子图的话,每个子图独立显示一个函数更清晰。

现在,我需要将上述思考转化为具体的MATLAB代码步骤,并确保每个激活函数的正确性,以及绘图的正确设置。同时,需要按照用户的要求,使用中文回答,并生成相关问题。最后,根据用户提供的引用,检查是否有需要引用的地方,比如激活函数的定义或绘图方法是否来自参考内容。但用户提供的引用主要是关于Python的实现,而这里的问题是关于MATLAB的,因此可能引用部分不适用,但需要确认是否有相关内容需要标注。</think>### 分步实现方法

1. **定义输入范围**

生成从$-5$到$5$的连续输入值,步长$0.1$,用于绘制平滑曲线:

```matlab

x = -5:0.1:5;

```

2. **定义激活函数**

- **Sigmoid**:

$$f(x) = \frac{1}{1 + e^{-x}}$$

```matlab

sigmoid = 1 ./ (1 + exp(-x));

```

- **Tanh**:

$$f(x) = \tanh(x)$$(直接使用MATLAB内置函数)

```matlab

tanh_y = tanh(x);

```

- **ReLU**:

$$f(x) = \max(0, x)$$

```matlab

relu = max(0, x);

```

- **LeakyReLU**:

$$f(x) = \begin{cases}

x & x \geq 0 \\

0.01x & x < 0

\end{cases}$$

```matlab

leakyrelu = x .* (x >= 0) + 0.01 * x .* (x < 0);

```

3. **绘制图像**

使用`subplot`将四个函数绘制在同一窗口的不同子图中:

```matlab

figure;

% Sigmoid

subplot(2,2,1);

plot(x, sigmoid, 'b', 'LineWidth', 2);

title('Sigmoid');

grid on;

% Tanh

subplot(2,2,2);

plot(x, tanh_y, 'r', 'LineWidth', 2);

title('Tanh');

grid on;

% ReLU

subplot(2,2,3);

plot(x, relu, 'g', 'LineWidth', 2);

title('ReLU');

grid on;

% LeakyReLU

subplot(2,2,4);

plot(x, leakyrelu, 'm', 'LineWidth', 2);

title('LeakyReLU');

grid on;

```

### 完整代码

```matlab

x = -5:0.1:5;

% Sigmoid

sigmoid = 1 ./ (1 + exp(-x));

% Tanh

tanh_y = tanh(x);

% ReLU

relu = max(0, x);

% LeakyReLU

leakyrelu = x .* (x >= 0) + 0.01 * x .* (x < 0);

% 绘图

figure;

subplot(2,2,1);

plot(x, sigmoid, 'b', 'LineWidth', 2);

title('Sigmoid');

grid on;

subplot(2,2,2);

plot(x, tanh_y, 'r', 'LineWidth', 2);

title('Tanh');

grid on;

subplot(2,2,3);

plot(x, relu, 'g', 'LineWidth', 2);

title('ReLU');

grid on;

subplot(2,2,4);

plot(x, leakyrelu, 'm', 'LineWidth', 2);

title('LeakyReLU');

grid on;

```

### 效果说明

- **Sigmoid** 输出范围$(0,1)$,适用于概率映射[^1]。

- **Tanh** 输出范围$(-1,1)$,中心对称性有助于收敛[^2]。

- **ReLU** 在$x>0$时线性增长,避免梯度消失。

- **LeakyReLU** 改进ReLU的“神经元死亡”问题,允许负值区域有微小梯度。

---

激活函数在神经网络中起到关键作用,负责引入非线性。本文详细介绍了sigmoid、tanh和ReLU三种常见激活函数的性质、优缺点以及它们在梯度消失问题上的表现。sigmoid和tanh由于饱和性导致训练速度慢,而ReLU因其线性特性在训练中能更快收敛,但存在神经元死亡问题。选择激活函数时,通常在输出层使用sigmoid(二分类问题),隐藏层偏好ReLU,以平衡训练效率和模型复杂性。

激活函数在神经网络中起到关键作用,负责引入非线性。本文详细介绍了sigmoid、tanh和ReLU三种常见激活函数的性质、优缺点以及它们在梯度消失问题上的表现。sigmoid和tanh由于饱和性导致训练速度慢,而ReLU因其线性特性在训练中能更快收敛,但存在神经元死亡问题。选择激活函数时,通常在输出层使用sigmoid(二分类问题),隐藏层偏好ReLU,以平衡训练效率和模型复杂性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?