code:

https://github.com/MichaelFan01/STDC-Seg

目录

一. 动机

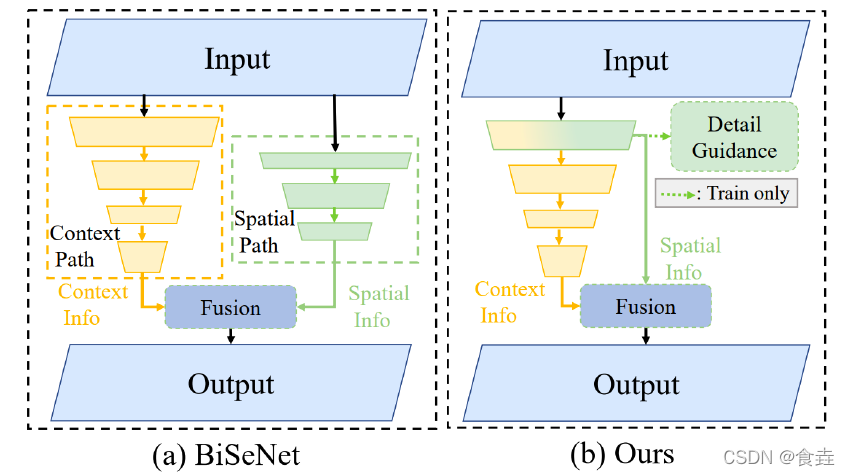

双流实时分割网络BiSeNet添加额外的路径来编码空间信息是耗时的,并且由于任务特定设计(task-specific design)的不足,从预训练任务(例如图像分类)中借用的主干网络可能对图像分割效率低下。

(b) Ours 细节指导(Detail Guidance)模块在低级特征中编码空间信息,无需额外的耗时路径。

二. 贡献

1、设计了一个短时密集连接(Short-Term Dense Concatenate,STDC)模块来提取具有可扩展感受野和多尺度信息的深层特征。

2、提出了一个细节聚合(Detail Aggregation)模块来学习解码器,从而在低级层中更精确地保留空间细节。(Train only)

3、在Cityscapes测试集上,STDC1-Seg50取得71.9% mIoU,250.4 FPS;STDC2-Seg75取得76.8% mIoU,97.0 FPS。

三、相关工作

1、高效的网络设计: 降低模型参数(SqueezeNet),减少推理阶段 FLOPs(MobileNetV1),出色的性能(ResNet),降低计算成本同时保持可比的准确性(MobileNet V2、ShuffleNet )。

专门为图像分类任务设计的,它们对语义分割应用程序的扩展应该仔细调整。

2、通用语义分割:传统分割算法(阈值选择、超像素)、深度学习算法(FCN、Deeplabv3、SegNet、PSPNet)。

由于高分辨率特征和复杂的网络连接,大多数方法需要大量的计算成本。

3、实时语义分割:轻量级主干(DFANet,DFNet等)、多分支架构(ICNet,BiSeNetV1,BiSeNetV2)。

四、方法

使用预训练的STDC作为编码器的骨干网络,采用 BiSeNet的上下文路径来编码上下文信息。

1、编码网络

1.1 短时密集连接(Short-Term Dense Concatenate,STDC)模块

在图像分类任务中,在更高层中使用更多通道是一种常见的做法。 但是在语义分割任务中,我们专注于可扩展的感受野和多尺度信息。低层需要足够的通道来编码感受野小的更细粒度的信息,而感受野大的高层更注重高层信息的归纳,与低层设置相同的通道可能会导致信息冗余 。

STDC网络由除输入层和预测层外的6个阶段组成。通常,第 1-5 阶段分别以步长2对输入进行空间分辨率下采样,第 6 阶段通过一个 ConvX、一个全局平均池化层和两个全连接层输出预测。

阶段1和2通常被视为外观特征提取的低级层。为了追求效率,我们在第一阶段和第二阶段只使用一个卷积块,根据我们的经验证明已经足

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1023

1023

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?