目录

最小 - 最大法(min-max normalization)

Q:为什么要进行数据预处理?

A:原因:

- 数据在搜集时由于各种原因可能存在缺失、错误、不一致等问题;

- 用于描述对象的数据有可能不能很好地反映潜在的模式;

- 描述对象的属性的数量可能有很多,有些属性是无用的或者冗余的

数据预处理的任务

一、数据规范化

数据规范化又称标准化(standardization),通过将属性的取值范围进行统一,避免不同的属性在数据分析的过程中具有不平等的地位。

常用方法:

-

最小 - 最大法(min-max normalization)

-

零均值规范化(Z-score)

具体计算步骤可以看数据标准化的方法

二、数据离散化

无监督离散化方法

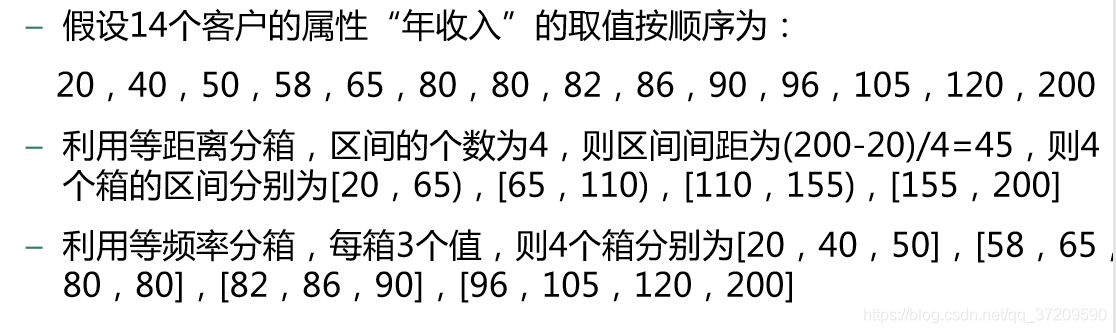

离散化分箱方法:等距离分箱法、等频率分箱法

举例:

※有监督离散化方法

基于熵的离散化方法(自顶向下的分裂方法)

ChiMerge方法(自底向上的合并方法)

三、数据清洗

数据清洗:处理数据的缺失、噪音数据的处理以及数据不一致的识别和处理

处理数据的缺失

如果数据集含有分类属性,一种简单的填补缺失值的方法为,将属于同一类的对象的该属性值的均值赋予此缺失值;对于离散属性或定性属性,用众数代替均值。

更复杂的方法,可以将其转换为分类问题或数值预测问题

噪音数据的处理

- 识别出噪音将其去除 -- 比如孤立点的识别

- 利用其它非噪音数据降低噪音的影响,起到平滑(smoothing)的作用 -- 分箱(binning)方法可以用于平滑噪音。例如,将年收入的缺失值填补之后,将其取值利用分箱法平滑噪音。

四、特征提取和特征选择

特征提取

是指描述对象的属性不一定反映潜在的规律或模式,对属性进行重新组合,获得一组反映事物本质的少量的新的属性的过程。

主成分分析(PCA):通过对原有变量(属性、特征)进行线性变换,提取反映事物本质的新变量,同时去除冗余、降低噪音,达到降维的目的。 -- 协方差

特征选择

是指从属性集合中选择那些重要的、与分析任务相关的子集的过程。

选择属性子集的方法

选择属性子集的方法一般采用启发式方法,只检验部分可能性比较大 的子集,这样可以快速完成属性的选择。

常用方法:

- 逐步增加法(stepwise forward selection)

- 逐 步递减法(stepwise backward elimination)

- 随机选取

衡量子集的相关性

通常选用两种方法:

- 一类称为filter方法,利用距离、信息熵以及相关度检验等方法直接衡量属性子集与类别的关联

- 另一类称为wrapper方法,利用分类模型来衡量属性子集的效果,通常效率很低

1368

1368

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?