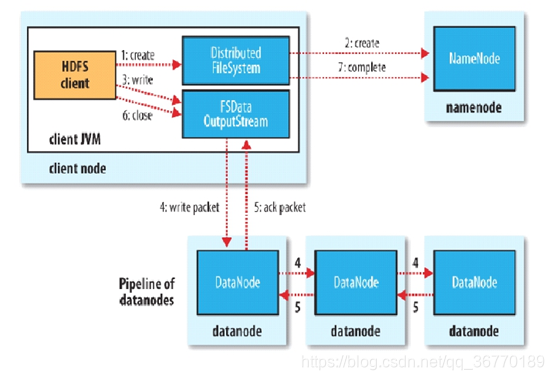

HDFS写流程

详细步骤:

1.HDFS client会向NameNode发出写文件的请求,通过过RPC与NameNode建立连接。

2.namenode检查是否已经存在该文件、检查权限。若通过检查,namenode返回可以写入的DataNode信息

(注:WAL,write ahead log,先写进Log,再写内存。因为EditLog记录的是最新的HDFS客户端执行所有的写操作,如果后续真实的写操作失败了,由于在此之前,操作就先被写入EditLog中了(EditLog中会存在这些记录),后续的client也会读到相应的数据块,因为DataNode在收到块后会返回确认信息,若没写成功,发送端没收到确认信息,会一直重试,直到成功)

3.客户端通过FSDataOutputStream模块请求datanode上传数据,datanode1收到请求会继续调用datanode2,然后datanode2调用datanode3,将pipeline通信管道建立完成。

4.client获取可以写入datanode位置信息,客户端开始向最近的datanode上传第一个block(先从磁盘读取数据放到一个本地内存缓存 ),以Packet为单位。第一个datanode收到block后,会依次传递给下一个DataNode。(DataNode之间的block通过pipeline管道传递)

5.每个DataNode写完一个块后,会向namenode返回确认信息。

6.当客户端结束写入数据,则调用stream的close函数,关闭输出流。

7.ack queue返回成功信息,客户端发送complete信号给NameNode。

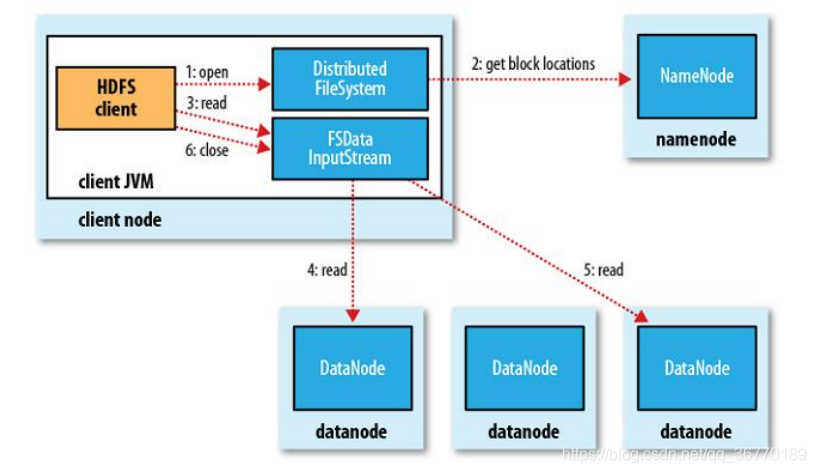

HDFS读流程

详细步骤:

1.client调用FileSystem的open()方法向namenode请求下载文件,

2.NameNode通过查询元数据信息,获得这个文件的数据块位置信息,返回输入流对象。

3.FileSystem返回FSDataInputStream给client,client调用read()方法读取数据,选择最近的一台Datanode服务器,请求建立输入流 。

4.DFSInputStream连接保存此文件第一个数据块的最近的数据节点,DataNode开始传输数据给客户端(从磁盘里面读取数据输入流,以Packet为单位来做校验)

5.客户端以Packet为单位接收,先在本地缓存,然后写入目标文件。当第一个数据块读取完毕时,DFSInputStream将关闭和此数据节点的连接,然后连接此文件下一个数据块的最近的数据节点,读取数据。

6.client读取数据完毕后,通过调用FSDataInputStream的close()方法,关闭输入流

本文详细介绍了HDFS的读写流程。写流程包括客户端向NameNode请求、NameNode检查、建立pipeline管道、上传数据、DataNode返回确认信息等步骤;读流程包括客户端请求下载、NameNode返回数据块位置、客户端读取数据等步骤。

本文详细介绍了HDFS的读写流程。写流程包括客户端向NameNode请求、NameNode检查、建立pipeline管道、上传数据、DataNode返回确认信息等步骤;读流程包括客户端请求下载、NameNode返回数据块位置、客户端读取数据等步骤。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?