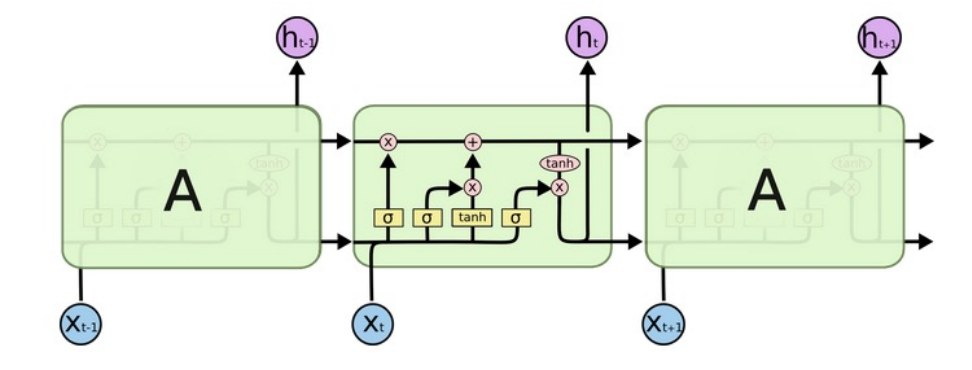

一、LSTM模型的结构

1.LSTM也称为长短时记忆结构。

2.和经典RNN相比,能够有效捕捉长序列之间的语义关联,缓解梯度消失或爆炸现象。

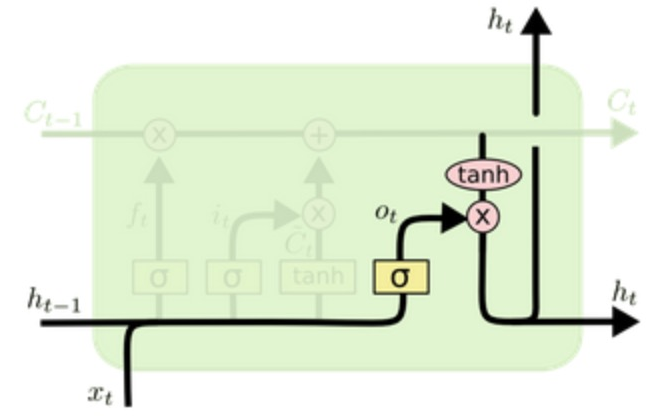

3.LSTM结构复杂,内部有3个门+1个细胞状态:遗忘门、输入门、细胞状态和输出门。

4.由输入层、隐藏层、输出层组成。

5.每个时间步有三个输入:数据端输入,上一个时间步细胞状态,上一个时间步的

。

6.每个时间步有三个输出:数据端输出、本时间步细胞状态 ,本时间步

。

二、LSTM模型的几个门的工作原理

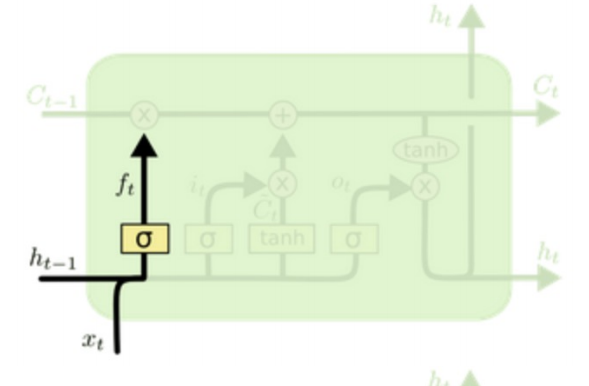

1.遗忘门及其相关运算

- 上一个时间步隐藏层输出和数据端输入拼接在一起,与权重参数

进行矩阵运算,再把数据经过sigmoid变换到[0,1]区间,形成输入门。

- 遗忘门作用在上一个时间步细胞状态之上,表示对上一个时间步信息遗忘多少。

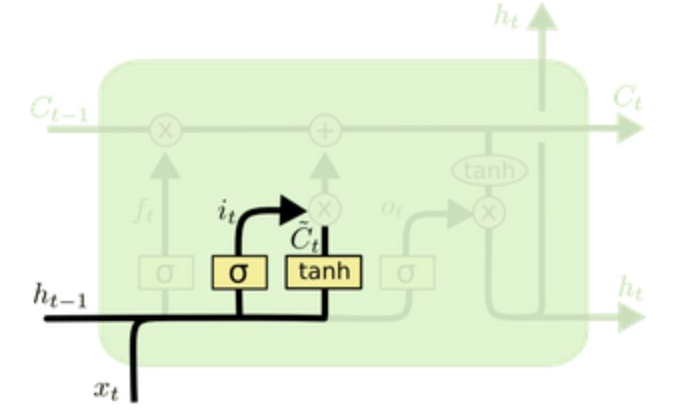

2.输入门及相关运算

- 输入门作用内部细胞状态,表示对内部细胞状态要使用多少。

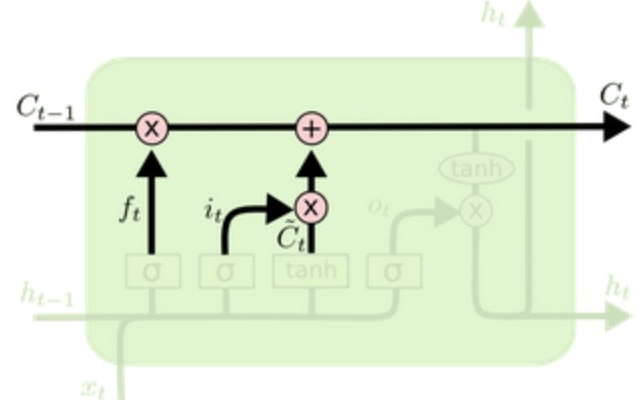

3.细胞状态更新相关运算

- 遗忘门作用在上一个时间步细胞状态之上+输入门作用内部细胞状态之上,更新细胞状态。

4.输出门及相关运算

- 输出门作用内部细胞状态之上,表示对内部细胞状态要使用多少。

三、LSTM(Long Short-Term Memory)是如何实现记忆信息的?

- LSTM引入门控机制和细胞状态,也就是内部记忆单元。

- 在一个训练好的网络中,当输入的序列中没有重要的信息时,LSTM的遗忘门的数值接近于1,输入门的数据接近于0,此时过去的记忆被保存,从而实现了长期的记忆功能。

- 当输入的序列中出现了重要的信息时,LSTM应该把其存入记忆时,此时输出门的数值接近于1。

- 引入各种门机制(遗忘门、输入门、输出门和细胞状态)可以控制当前时间步、以前时间步的信息谁重要谁不重要,从而实现LSTM(长短时记忆网络)。

四、LSTM(长短时记忆网络)中的“门控”单元有哪几种类型?

LSTM中的“门控”单元包括输入门、输出门和遗忘门,他们允许模型选择性的更新或忽略内部记忆。

- 遗忘门:决定了哪些信息应该从细胞状态中遗忘掉。

- 输入门:控制着有多少信息可以流入细胞状态。

- 输出门:决定了细胞状态的哪部分将输出到隐藏状态。

这三种门控单元共同作用,使得LSTM网络能够在处理序列数据时选择性地更新、遗忘和输出信息,从而更 好地控制信息的流动和记忆状态。这使得LSTM相对于传统的RNN在处理长时序依赖问题时更为有效。

2148

2148

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?