卡内基梅隆Noam Brown大神发的 Regret-Based Pruning in Extensive-Form Games,结合CFR和CFR+框架的剪枝技术,实验表明,游戏速度提高了一个数量级,相对速度的提高也随着游戏规模的增加而增加。

注:博客中有本人理解的内容,若有错误,感谢指正

introduction

论文首先引出了partial pruning,部分剪枝仅仅跳过更新对手动作概率不大于零的结点,可能错过实际上可以剪枝的路径,所以部分剪枝上仍有大量进步空间。比如说在某一动作结点上有许多动作,经过几轮迭代后的cfv值很低,即使动作概率仍大于零也进行剪枝。

在这个文章中,作者提出CFR上的Regret-Based Pruning ,区别部分剪枝只考虑对手的概率,RBP中如果任意一个玩家采取的行动导致这条路径的概率为零,则应避免在游戏树中遍历这条路径。这种剪枝需要是暂时的,因为概率会随迭代改变。跳过迭代的次数依赖于在之前迭代中这条序列上动作的好坏。

(Author note : RBP是基于概率的剪枝算法,α-β剪枝是基于价值的剪枝算法)

Background

这里几个新符号,其他在CFR中常见的就不赘述了

D(I,a) 为参与人P (I)在采取行动a后可达的信息集合,也就是descendant;

U(I) 为从I的历史中获得的最大收益,L(I) 是最小值

∆(I) = U(I) - L(I) 为从I的历史中可以得到的收益的范围

Applying Best Response to Zero-Reach Sequences

前文提到如果两个参与人的平均遗憾趋于零,那么他们的平均策略趋于纳什均衡。CFR-BR是CFR的一种变体,其中一个玩家使用CFR算法,另外的玩家在每次迭代中针对对手策略选择最佳对策,最佳反应的计算简单,只需要对博弈树进行一次遍历,每次遍历中遗憾值最大为零。

本文的方法只在特定状态下使用最佳反应(其他是CFR),可以在不增加对手遗憾的情况下减少玩家的遗憾。

Regret-Based Pruning (RBP)

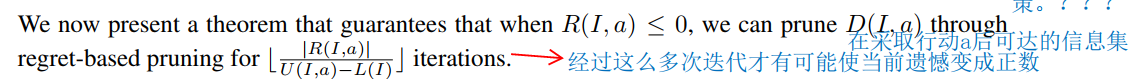

重点来了,针对迭代中负遗憾值的动作,提出了一个CFR变体,在以零概率(因为在上一次迭代遗憾值为负)到达的信息集处使用最佳反应,该信息集及其后代结点不需要在每次迭代都遍历一遍,遍历的频率与这个动作的负遗憾值有多大有关。参与人1在迭代t + 1时在任何信息集中采取的策略对参与人2没有影响。比如说di在信息集I处,a的遗憾值Rt(I,a)=−1000Rt(I,a) = -1000Rt(I,a)=−1000,并且至少有一个I处的其他动作是正的,现假设△(I)=1△(I) = 1△(I)=1,在t+1次迭代时,动作a的遗憾值最大是-999,所以动作a仍不会被执行。所以我们应该跳过t+1到t+1000次迭代的动作a。在此之间,我们可以存储玩家2在t+1到t+1000每一次迭代的策略,然后在t+1000时计算针对这些策略的最佳反应,并声明玩家1在t+1到t=1000中使用的是最佳反应。

然后,我们可以计算玩家2这些迭代中的平均策略,再针对这个平均策略计算一个BR,再根据这个BR计算遗憾值给到下一次迭代。

定理一:不在剪枝点及其子孙结点的信息集,其遗憾值更新与在D(I,a)D(I,a)

卡内基梅隆大学Noam Brown的论文介绍了一种结合CFR和CFR+的后悔基剪枝(RBP)方法,通过在负遗憾动作上临时剪枝,显著加快了游戏速度。RBP在大型游戏中效果显著,未来研究方向包括扩展到其他平衡寻找算法。

卡内基梅隆大学Noam Brown的论文介绍了一种结合CFR和CFR+的后悔基剪枝(RBP)方法,通过在负遗憾动作上临时剪枝,显著加快了游戏速度。RBP在大型游戏中效果显著,未来研究方向包括扩展到其他平衡寻找算法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

816

816

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?