目录

博主看了一些Optimizer总结的文章,感觉有些博客全部是公式,不好理解。

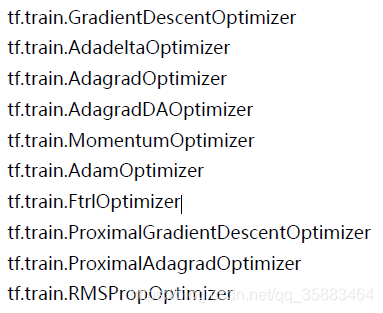

Optimizer:

由随机梯度下降(SGD)发展的optimizer: GradientDescentOptimizer、MomentumOptimizer(Nesterov accelerated gradient)、AdagradOptimizer、AdagradDAOptimizer、AdamOptimizer、RMSPropOptimizer

GradientDescentOptimizer

就是使用了随机梯度下降(SGD)

tf.train.GradientDescentOptimizer()使用随机梯度下降算法,使参数沿着 梯度的反方向,即总损失减小的方向移动,实现更新参数,比较简单。

Momen

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4400

4400

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?