Enhancing the Transferability of Adversarial Attacks through Variance Tuning

CVPR2021

大类属于使用新的数据增广技术提高对抗样本的攻击迁移性,属于黑盒攻击。

Abstract:白盒攻击效果已经很好了,但是黑盒(迁移)攻击效果仍不能达到满意的效果。本文引入一种新的方法——Variance Tuning,来提高基于梯度迭代攻击方法类的攻击效果,并提高其攻击迁移性。具体地,在使用梯度更新参数的时候,并不是使用当前梯度来进行动量累积,而是使用之前迭代步的梯度信息来对当前梯度进行调整修正,以使得参数更新稳定,并尽可能拜托局部最优。

似乎归根结底,还是要提高模型的泛化性?

1. Introduction

为了提高对抗样本的攻击迁移性,常用的手段有:

- 生成对抗样本时使用更加先进的梯度计算方法,例如Momentum、Nesterov’s accelerated gradient;

- attacking multiple models(集成攻击)

- 采用数据增广技术对输入数据进行变换

这一点划分和Improving the Transferability of Adversarial Samples with Adversarial Transformations中2.1节内容是一致的。

不过本文采用的是使用更加先进的梯度方法提高攻击迁移性,而这篇文章采用的是数据增广技术。

与之前直接使用梯度方向或使用基于“动量矩”累积进行梯度修正方法不同,本文不仅使用当前梯度信息,而且还使用了之前的梯度方差来修正当前梯度。本方法的关键是使得梯度方差降低,进而使得参数更新更加稳定,并尽可能局部最优点。

2. Related Work

2.1 Adversarial Attacks

2.1.1 Gradient-based attacks

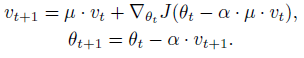

使用先进梯度计算方法提高对抗样本攻击迁移性类。

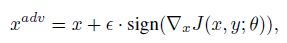

- FGSM

- I-FGSM

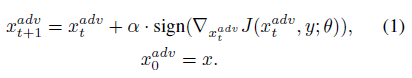

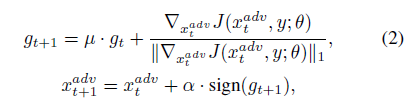

- MI-FGSM(Momentum Iterative FGSM)

将动量矩结合I-FGSM,可提高对抗样本的攻击迁移性。

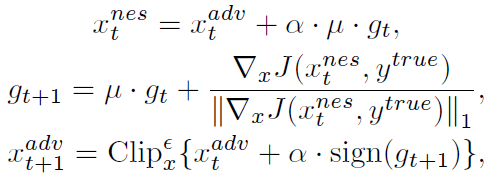

- NI-FGSM(Nesterov Iterative FGSM),采用Nesterov‘s accelerated gradient来进一步提高攻击迁移性。将上式中的 x t a d v x_t^{adv} xtadv替换为 x t a d v + α ⋅ μ ⋅ g t x_t^{adv}+\alpha \cdot \mu \cdot g_t xtadv+α⋅μ⋅gt,即进一步对梯度信息进行修正。

NI-FGSM与MI-FGSM相比,不仅在更新梯度的时候范式有了变换,而且在更新参数 θ \theta θ的时候也有改进。

原始的Nesterov Accelerated Gradient(NAG)范式为:

即将其中的训练参数 θ \theta θ进一步改进。

在Improving Transferability of Adversarial Examples with Input Diversity(DIM)中,对提出的DIM有以下划分:

2.1.2 Input Transformations

使用数据变换(Input Transformations)/数据增广类方法提高对抗样本攻击迁移性类。

数据/模型增强效果等同于集成模型??Inputs Transformations类方法都是通过增加数据的多样性来提高模型/对抗样本的泛化能力。

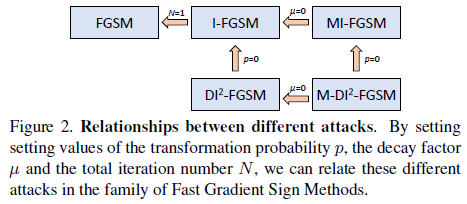

- Diverse Input Method(DIM),通过对输入数据进行随机调整大小和padding进行数据增广,提高数据多样性,提高对抗样本攻击迁移性;Improving Transferability of Adversarial Examples with Input Diversity(DIM)

- Translation-Invariant Method(TIM).不是对单张图片计算梯度,而是对单张图片进行一系列变换后在计算梯度,对有防御的模型攻击效果较好。

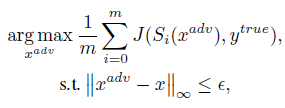

- Scale-Invariant Method(SIM).在NI-FGSM文章中一并提出,利用图像缩放不变性,通过同时计算单张图片多次缩放的梯度来近似最终梯度。

其中: S i ( x ) = x / 2 i S_i(x) = x/2^i Si(x)=x/2i

基于input transformation的方法和基于梯度的方法并不是正交的,二者可以一起结合使用。

本文提出的variance tuning方法旨在提高基于梯度攻击方法(MI-FGSM、NI-FGSM)的攻击迁移性。

2.1.1和2.1.2涉及内容的先后问题:

分两行:

F G S M → I − F G S M ( B I M ) → M I − F G S M → N I − F G S M D I M → T I M → S I M FGSM \rightarrow I-FGSM(BIM) \rightarrow MI-FGSM \rightarrow NI-FGSM \\ \\ DIM\rightarrow TIM \rightarrow SIM FGSM→I−FGSM(BIM)→MI−FGSM→NI−FGSMD

该研究关注于提升对抗攻击的迁移性,尤其是针对黑盒攻击。通过引入一种名为Variance Tuning的新方法,该方法在梯度更新过程中考虑了历史梯度的方差,以稳定参数更新并避免局部最优。相比于传统的FGSM、I-FGSM、MI-FGSM和NI-FGSM等方法,Variance Tuning在提高攻击效果和迁移性方面表现出优势。实验表明,这种方法可以与数据增广技术如DIM、TIM和SIM等结合,进一步提升攻击性能,尤其是在攻击集成模型和防御模型时。

该研究关注于提升对抗攻击的迁移性,尤其是针对黑盒攻击。通过引入一种名为Variance Tuning的新方法,该方法在梯度更新过程中考虑了历史梯度的方差,以稳定参数更新并避免局部最优。相比于传统的FGSM、I-FGSM、MI-FGSM和NI-FGSM等方法,Variance Tuning在提高攻击效果和迁移性方面表现出优势。实验表明,这种方法可以与数据增广技术如DIM、TIM和SIM等结合,进一步提升攻击性能,尤其是在攻击集成模型和防御模型时。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2207

2207

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?