NS

机构

Tsinghua,Intel

【Pruning系列:二】Learning Efficient Convolutional Networks through Network Slimming|YOLOv3实践 |Pytorch 总结

motivation

训练中的剪枝

基于BN(Batch Normalization)层的广泛使用,在BN层加入channel-wise scaling factor 并对之加L1 regularizer使之稀疏,然后裁剪scaling factor值小的部分对应权重

-

用 BN 层的 y 来表示卷积核的重要程度,y 小对应卷积核重要性低

γ 非常小时,送入下一层的值就非常小,可以直接剪掉

-

虽然可以通过删减 γ 值接近零的channel,但是一般情况下, γ 值靠近0的channel还是属于少数

于是作者采用 L1 or smooth-L1 惩罚 γ ,来让 γ 值倾向于0

method

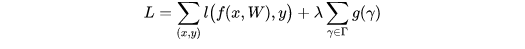

目标函数:

-

第一项是模型预测所产生的损失<

本文介绍了通过在网络中引入BN层的channel-wise scaling factor并应用L1正则化,来实现卷积网络的高效学习。通过使γ参数趋于0,可以有效地剪枝不重要的通道。在目标函数中,结合模型损失与γ的稀疏约束,逐步调整网络结构。实验结果显示,经过网络瘦身,γ值大部分接近0,表明大量通道被有效精简。

本文介绍了通过在网络中引入BN层的channel-wise scaling factor并应用L1正则化,来实现卷积网络的高效学习。通过使γ参数趋于0,可以有效地剪枝不重要的通道。在目标函数中,结合模型损失与γ的稀疏约束,逐步调整网络结构。实验结果显示,经过网络瘦身,γ值大部分接近0,表明大量通道被有效精简。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

648

648

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?