本文引用与百度百科。

简介

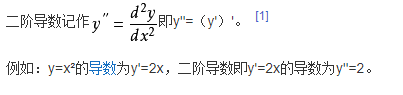

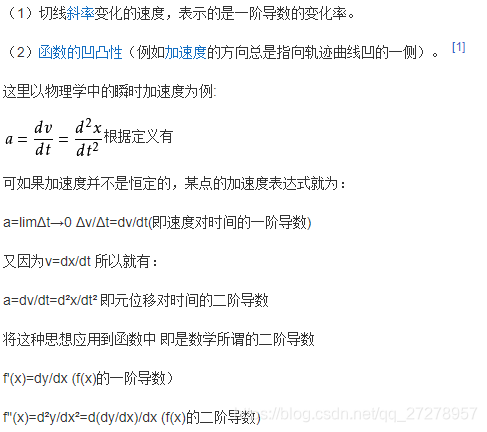

二阶导数,是原函数导数的导数,将原函数进行二次求导。一般的,函数y=f(x)的导数yˊ=fˊ(x)仍然是x的函数,则y′′=f′′(x)的导数叫做函数y=f(x)的二阶导数。在图形上,它主要表现函数的凹凸性。

代数记法

几何意义

对于反函数

性质

(1)如果一个函数f(x)在某个区间I上有f''(x)(即二阶导数)>0恒成立,那么对于区间I上的任意x,y,总有:

f(x)+f(y)≥2f[(x+y)/2],如果总有f''(x)<0成立,那么上式的不等号反向。

几何的直观解释:如果一个函数f(x)在某个区间I上有f''(x)(即二阶导数)>0恒成立,那么在区间I上f(x)的图象上的任意两点连出的一条线段,这两点之间的函数图象都在该线段的下方,反之在该线段的上方。

(2)判断函数极大值以及极小值。

结合一阶、二阶导数可以求函数的极值。当一阶导数等于0,而二阶导数大于0时,为极小值点。当一阶导数等于0,而二阶导数小于0时,为极大值点;当一阶导数和二阶导数都等于0时,为驻点。

(3)函数凹凸性。

设f(x)在[a,b]上连续,在(a,b)内具有一阶和二阶导数,那么,

(1)若在(a,b)内f''(x)>0,则f(x)在[a,b]上的图形是凹的;

(2)若在(a,b)内f''(x)>0,则f(x)在[a,b]上的图形是凸的。

本文深入探讨了二阶导数的概念及其在数学分析中的应用,包括函数的凹凸性判断、极值点的求解及图形特征分析。通过实例解析,帮助读者理解二阶导数在解决实际问题中的作用。

本文深入探讨了二阶导数的概念及其在数学分析中的应用,包括函数的凹凸性判断、极值点的求解及图形特征分析。通过实例解析,帮助读者理解二阶导数在解决实际问题中的作用。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?