一、逻辑回归 sigmiod 与 softmax

1、logistics逻辑回归

详细推导过程见机器学习 逻辑回归https://blog.youkuaiyun.com/qq_16555103/article/details/89135490 ----------- 机器学习 逻辑回归

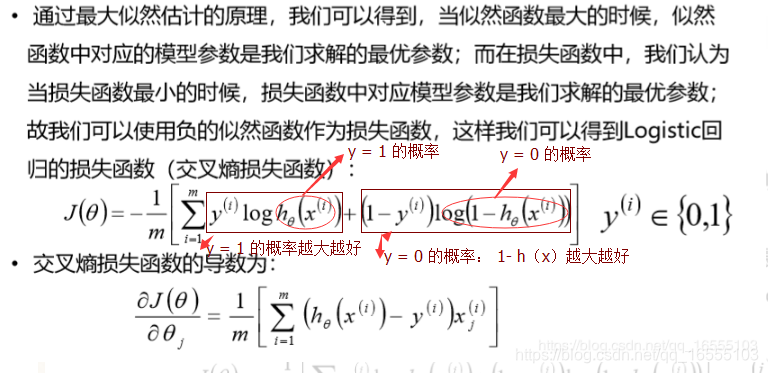

(1)逻辑回归的损失函数与一阶导数

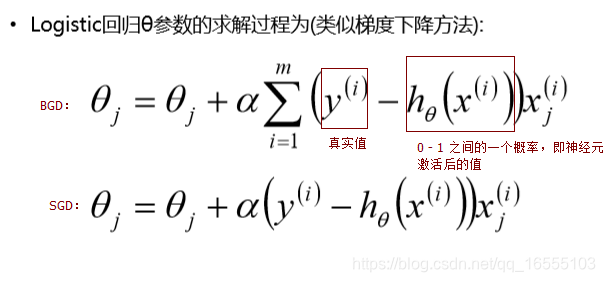

(2)逻辑回归参数的求解方式(梯度下降)

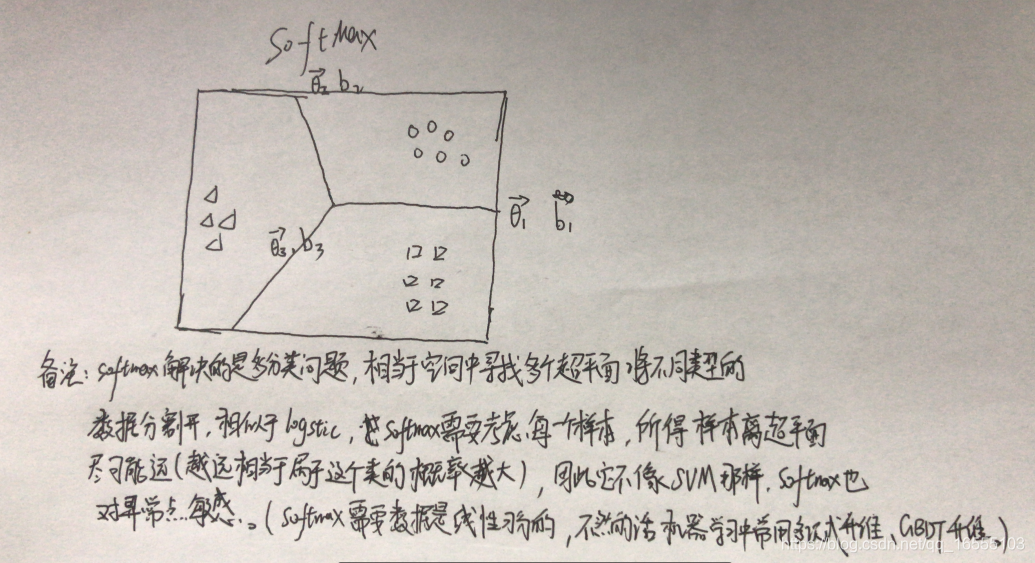

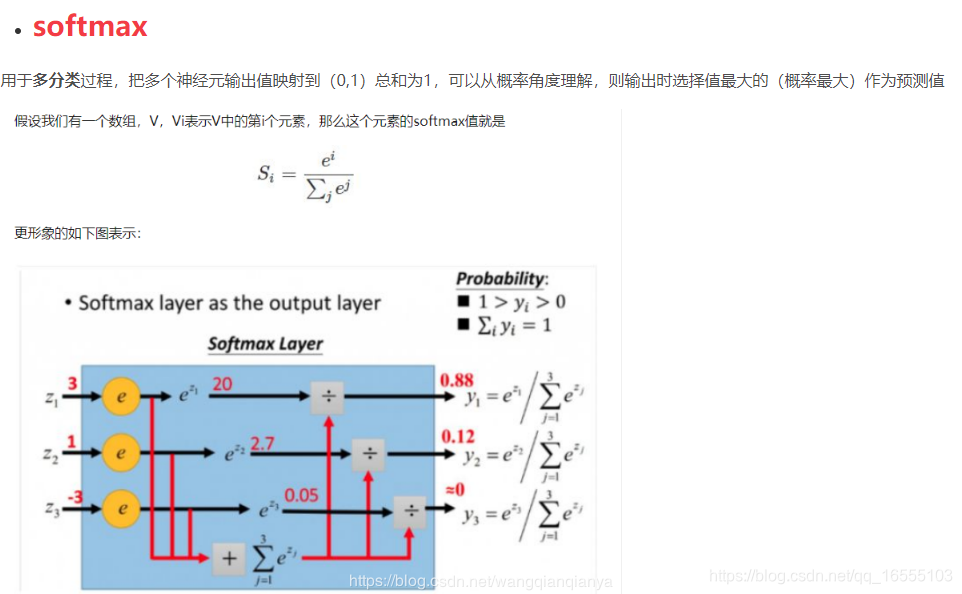

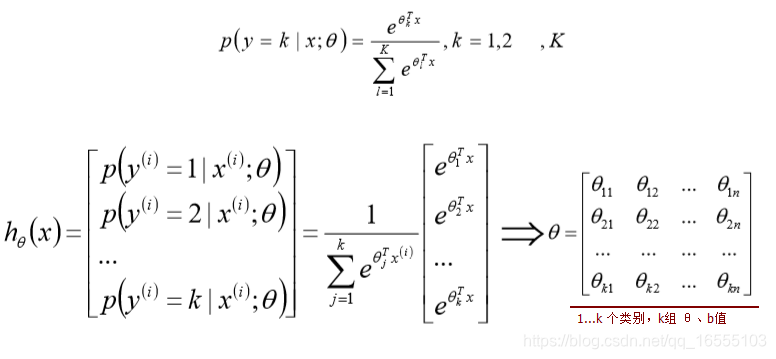

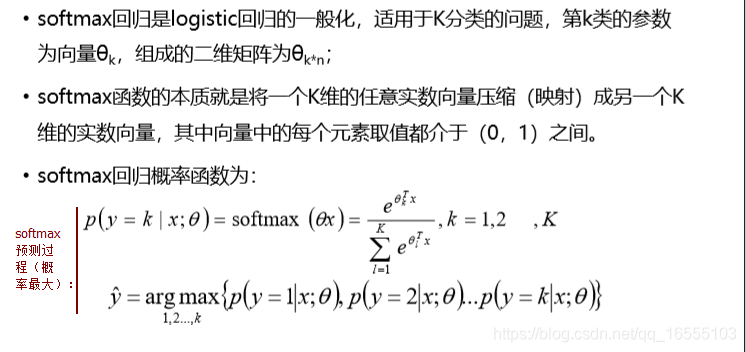

2、softmax回顾

(1)softmax 预测方式

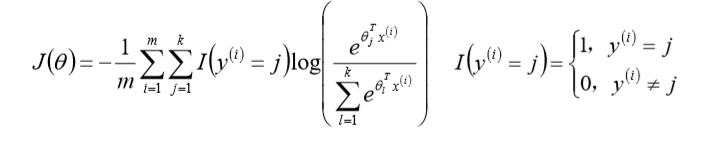

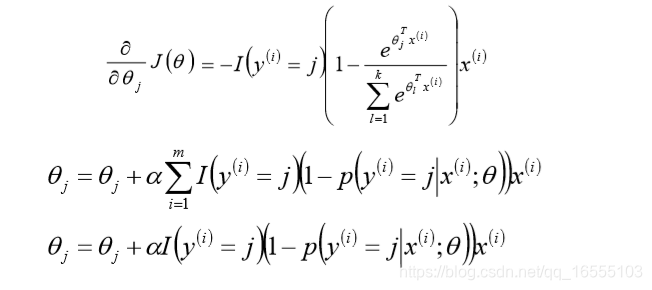

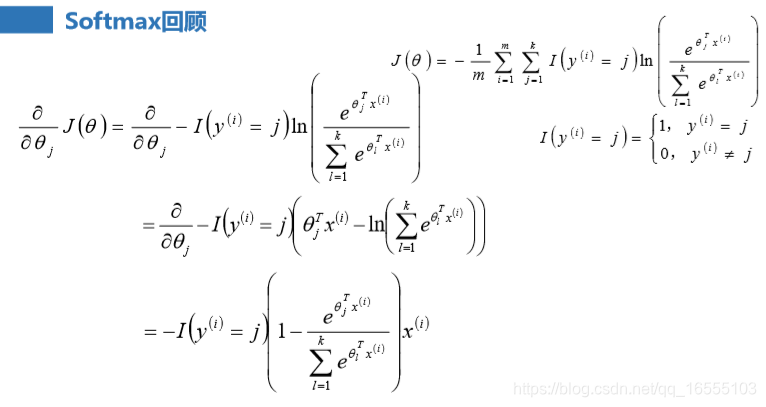

(2)softmax损失函数 与 一阶导数

- 损失函数一阶导数推导过程如下:

3、逻辑回归 与 softmax 在神经网络中的作用

(1)逻辑回归在神经网络的作用

1、机器学习中逻辑回归使用 sigmiod 函数激活的,而神经网络 无数的神经元是由 逻辑回归组成的,不同的是 神经元中的逻辑回

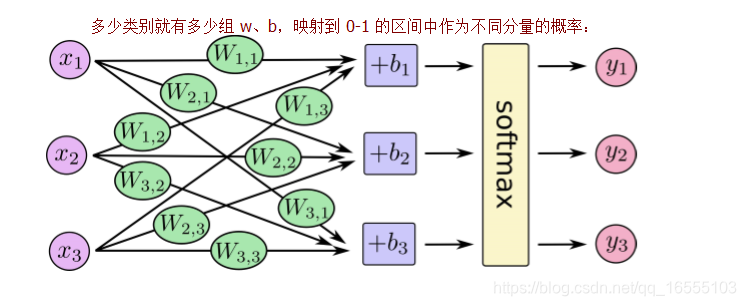

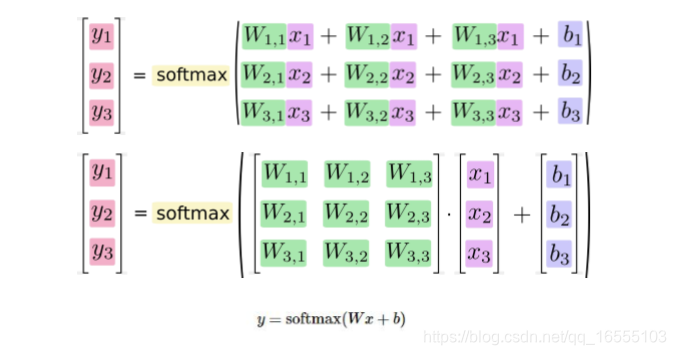

归 激活函数不仅仅有 sigmiod函数,还有其他的激活函数,例:tanh、relu ....(2)softmax在神经网络中的作用

1、如果说神经网络中由无数个逻辑回归构成,那么 softmax 就是神经网络输出层最后获取结果输出分量的方式。

二、激活函数

https://blog.youkuaiyun.com/qq_16555103/article/details/89680509 --------------- TensorFlow常见API

1、激活函数的根本目的:加入非线性因素,使得神经网络可以解决非线性问题。• 激活函数运行时激活神经网络中某一部分神经元,将激活信息向后传入下一层的神经网络。 神经网络值所以能解决非线性问题,本

质上就是激活函数加入非线性因素,弥补了线性模 型的表达力,把“激活的神经元的特征”通过函数保留并映射到下一层。

• 因为神经网络的数学基础是处处可微的,所以选取的激活函数要把保证数据输入与输出也 是可微的。

• 常见的激活函数:

• sigmoid

• tanh

• relu

• dropout三、损失函数

(1)常见损失函数

https://blog.youkuaiyun.com/qq_16555103/article/details/89680509 --------------- TensorFlow常见API

• 常见损失函数

• sigmoid_cross_entropy_with_logits

• softmax_cross_entropy_with_logits

• weighted_cross_entropy_with_logits

• absolute_difference

• cosine_distance

• hinge_loss

• huber_loss

• log_loss

• ctc_loss

• nce_loss(2)常见的分类/转换函数(即转换为概率等值)

https://blog.youkuaiyun.com/qq_16555103/article/details/89680509 --------------- TensorFlow常见API

• 常见的分类/转换函数(即转换为概率等值):

• softmax

• log_softmax

• sigmoid四、优化方法

https://blog.youkuaiyun.com/qq_16555103/article/details/89680509 --------------- TensorFlow常见API

• 如何加速神经网络的训练呢?

• 目前加速训练的优化方法基本都基于梯度下降的。只是细节上有差异。

• 优化方法:

• 梯度下降法(BGD、SGD)

• Adadelta

• Adagrad(Adagrad、AdagradDAO)

• Momentum(Momentum\Nesterov Momentum)

• Adam

• Ftrl

• RMSprop五、TensorFlow常见API

https://blog.youkuaiyun.com/qq_16555103/article/details/89680509 --------------- TensorFlow常见API

8万+

8万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?