💗博主介绍:✌全网粉丝20W+,优快云全栈领域优质创作者,博客之星、掘金/华为云/阿里云等平台优质作者,计算机毕设实战导师。目前专注于大学生项目实战开发,讲解,毕业答疑辅导,欢迎高校老师/同行前辈交流合作✌

💗主要服务内容:免费功能设计、选题定题、开题报告、任务书、程序开发、论文编写和辅导、论文降重、程序讲解、答辩辅导等,欢迎咨询~

👇🏻 精彩专栏 推荐订阅👇🏻

计算机毕业设计精品项目案例(持续更新)

🌟文末获取源码+数据库+文档🌟

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以和学长沟通,希望帮助更多的人

一.前言

在影视产业朝着数字化方向不断发展的进程当中,传统的评价体系暴露出了一系列结构性的缺陷,比如数据处理能力欠缺、用户反馈的实时性欠佳以及评价维度较为单一等情况,此项研究构建了一个借助Django、Vue以及MySQL搭建而成的智能影视评价系统,借助系统的数据采集与分析,为用户、系统以及管理员给予了高效的评价管理解决办法,这对于提升影视评价的规范性与实用性有着不可忽视的关键作用。

此系统选用Django当作后端框架,Vue当作前端框架,MySQL当作数据库,达成用户评价提交、评价数据采集、评价内容分析以及管理员评价管理这些核心功能,用户可方便快捷地提交针对影视作品的评价,系统会自动采集并且存储评价数据,管理员可对评价内容开展审核以及统计分析,以此保证数据的准确和可用。

这个系统依靠智能算法达成多维度情感分析以及语义挖掘,可对用户评价展开解析,精确提炼影视作品的优点和缺点,借助前后端的有效协作以及数据库的优化,达成评价数据的实时更新和处理,使得评价数据的可用性以及管理效率得到很大程度提升,系统还为用户给予了便捷的评价提交途径,为管理员提供了高效的管理工具,让影视评价系统的整体运行效率和用户体验都有了提升。

二.技术环境

开发语言:Python

python框架:django

软件版本:python3.7/python3.8

数据库:mysql 5.7或更高版本

数据库工具:Navicat11

爬虫框架:Scrapy

开发软件:PyCharm/vs code

前端框架:vue.js

三.功能设计

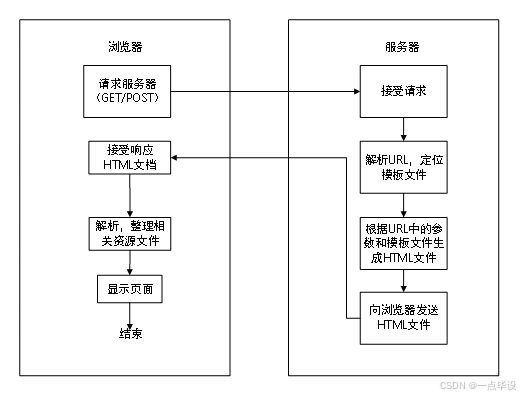

此系统是基于B/S架构构建的,运用Django框架给予开发,在浏览器端,用户借助GET或者POST方式向服务器发出请求,当接收到服务器返回的HTML文档后,会对相关资源文件进行解析以及整理,最终呈现出页面,于服务器端而言,在接收到浏览器请求后,会先对URL进行解析定位到对应的模板文件,接着依据URL里的参数以及模板文件来生成HTML文件,最后把生成的HTML文件发送至浏览器。这样的架构达成了前后端的交互,Django框架在服务器端承担着业务逻辑处理以及页面生成的工作,浏览器端负责页面的展示,有开发便利、维护便捷等优点。

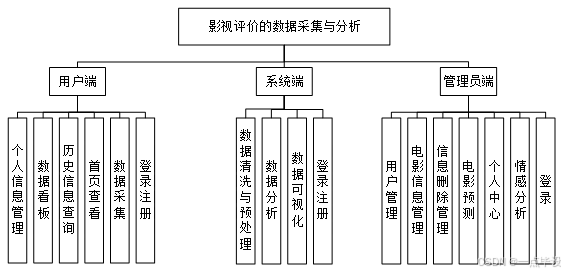

本课题设计并完成了一个针对影视评价的数据采集与分析平台,该平台主要针对用户、系统以及管理员这三个角色,用户可借助数据看板功能直观地了解影视评价的整体状况,便于迅速获取关键信息,系统的核心功能有数据采集、清洗、预处理、分析以及可视化,以此保证数据的准确性与可读性,为后续决策给予可靠的数据支撑。管理员负责电影信息管理、电影预测以及情感分析,借助智能算法对影视作品开展预测以及情感趋势分析,为影视制作与营销提供数据支持,系统运用模块化设计,各个功能模块相互配合协作,达成了影视评价的全流程智能化管理,数据采集模块从多个源头获取原始数据,在经过清洗和预处理后,分析模块对数据展开挖掘,可视化模块把分析结果以图表形式呈现出来。管理员模块依靠机器学习算法对影视作品进行预测,同时运用自然语言处理技术开展情感分析,为影视行业提供决策依据,整个系统架构合理且功能完善,可切实契合影视评价领域的实际需求。

四.数据设计

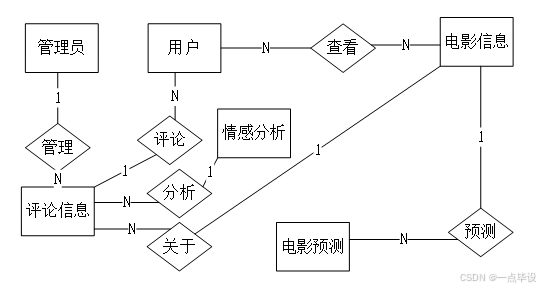

数据库设计属于构建高效、可靠且可扩展数据库系统的关键部分,该过程要严格依照科学步骤和原则来开展,首先在需求分析阶段,要清晰明确业务需求,确定好数据的范围、类型以及使用方式,形成需求文档或者数据字典,接下来在概念设计阶段,借助实体 - 关系模型也就是 ER 模型去描述系统里的实体、属性及其关系,并且利用 ER 图来进行可视化呈现。逻辑设计阶段会把概念模型转变为具体的数据库模式,定义好表结构、字段、主键、外键等内容,同时选择适宜的数据库类型,物理设计阶段会对存储结构加以优化,凭借分区、索引等办法来提升性能,还会生成 DDL 语句以及存储策略,在实现与测试阶段,要创建数据库并导入数据,编写查询语句以及存储过程,以此验证数据库的性能、一致性与完整性。最后在维护与优化阶段,需要持续监控数据库性能,依据业务变化去调整结构,保证系统可长期稳定运行,在整个设计过程中,要遵循规范化、完整性、性能优化、可扩展性、安全性以及易用性等原则,合理运用 ER 图工具、数据库管理工具以及版本控制系统,防止过度设计,重视数据备份与恢复,并且充分做好设计决策的文档记录,以此保证数据库系统的高效性以及可维护性。

五.部分效果展示

5.1数据看板实现

数据看板模块运用Django搭建后端接口,融合Vue.js以及Element UI达成前端可视化效果,借助Axios达成前后端数据交互,在技术实现方面,后端利用@api_view定义/api/databoard/路由,为movie_score、comment_count等字段添加数据库索引,结合select_related来优化查询性能。前端基于Vue组件化进行开发,运用ECharts渲染柱状图、折线图等可视化模块,借助v-model实现多条件筛选参数的双向绑定,依靠URL哈希值持久化存储筛选状态,界面呈现如图所示。

5.2数据采集实现

数据采集模块借助Scrapy框架来构建核心爬虫逻辑,再联合Selenium去处理动态页面,借助PyMySQL达成数据持久化,同时利用Redis实施分布式任务管理与去重,在技术实施方面,借助scrapy.Request发起网络请求,运用XPath以及正则表达式来解析豆瓣接口返回的JSON数据和页面HTML内容,从中提取电影标题、评分、评论数等信息。针对反爬机制,采用随机请求头池和IP代理池,并且依靠time.sleep()来控制请求间隔,间隔时长为5到10秒,在详情页解析时,对于需要登录的页面调用Selenium模拟浏览器行为,以此保证动态渲染内容可被采集,数据清洗阶段利用pandas处理重复值、空值以及异常值,最终凭借Django ORM批量写入MySQL数据库,界面如图所示。

5.3数据分析实现

本课题所设计的数据分析页面为管理员给予了多维度的数据查询功能,于该页面里,管理员可依据实际的需求来选择数据类型、时间范围等筛选条件,也可借助输入特定字段来展开精确查询,查询的结果会在页面展示区以三种形式给予呈现,分别是数据统计结果、趋势图表以及详细数据列表,具体如图所示。

页面上方可直观地呈现出电影信息的总数为250条,评论总数是150条,在页面左侧,年份借助饼图的形式呈现出各个年份电影的分布状况,这可管理员迅速知晓不同年份电影所占的比例,对于片长以及电影名称,也可进行相关数据的查看,右侧的类型、评论人数、语言等信息,是以不同的图表形式来展示的,举例来说,类型是借助类似于饼图的方式呈现出各类电影类型的分布情况。统计结果会以数值的形式直观地呈现这些关键指标,而趋势图则可凭借折线图或者柱状图来反映数据的变化规律,详细列表则在中间区域提供电影的标题、年份、总评分、评论人数、类型、制片国家、语言、片长等完整的字段信息。

为能展开分析,本课题特意设置了数据详情查看功能,管理员可借助点击具体的数据项,查看该条目的详细信息以及与之相关联的内容,这样一种多层次的数据展示形式,一方面契合了全局概览的需要,另一方面也提供了细节分析的入口,对管理员全面掌握数据特征很有帮助,可为后续的决策提供可靠的依据。在数据分析功能模块里,用户可借助向系统发送请求来启动数据分析流程,该功能借助 /analyze_data 接口映射到 analyze 方法,用来接收并处理用户提交的数据分析请求,系统在接收到请求之后,马上执行数据分析操作,以此保证数据处理的高效和准确。

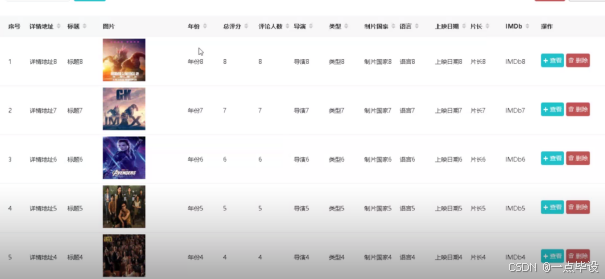

5.4电影信息管理实现

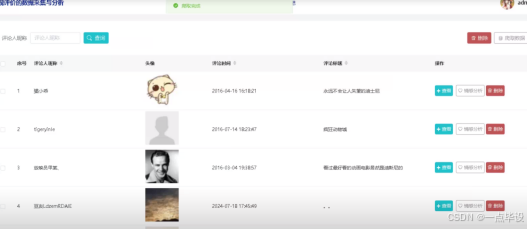

在电影信息管理模块当中,管理员可借助多种不同方式来对电影数据展开检索以及筛选,系统有基于关键词的搜索功能,可支持输入电影名称、导演、主演等字段来实施精确查询,系统还设置了电影分类筛选机制,管理员可以依据动作、喜剧、科幻等类型标签来进行快速筛选,检索得到的结果会以可视化的形式呈现出来,其中覆盖电影海报、名称、导演、主演以及上映时间等关键信息。依靠点击特定的电影条目,系统就会展示出该电影的详细内容以及剧情简介,另外系统为管理员提供了完善的数据维护功能,可支持对现有的电影信息进行编辑、删除操作,并且可以实现新电影数据的添加与录入,这些功能的达成有效地保障了电影数据库的准确性与完整性,为后续的电影信息管理与维护给予了可靠的技术支持。系统界面设计遵循用户体验原则,采用清晰的布局以及直观的操作方式,使得管理效率得到了提升,电影信息管理模块的核心功能是为用户提供电影信息的查询服务,该模块依靠 /discussmovie_info 路径映射至 info 方法,用以处理用户的请求。系统控制器在接收到用户请求之后,会调用管理员服务层来进行电影信息的查询操作,管理员服务层依靠电影实体层与数据库展开交互,从电影数据库表当中获取具体的电影数据,获取到数据之后,管理员服务层会对数据进行必要的处理,随后将结果返回给系统控制器,系统控制器把处理后的电影信息返回至用户端,用户端接收并展示相关信息。这一流程保证了用户可高效且准确地获取所需的电影信息,同时也体现出系统各层级之间协同工作以及数据流转的清晰逻辑。

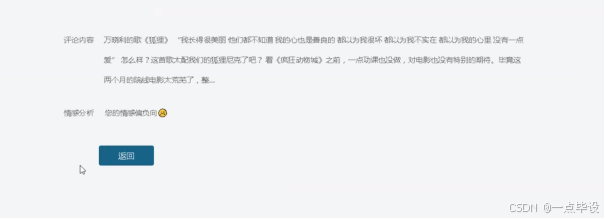

5.5影视评价情感分析实现

影视评价情感分析功能依靠百度情感分析API,针对用户影评开展多维度的情感解析工作,可给出情感倾向、评论热度以及关键词提取等核心洞察内容,为影视制作方、发行方以及院线提供依据数据的决策支持。

系统借助getMovieReviews()函数从数据库里获取用户影评数据,可依照影片ID、时间范围、评分区间等条件来进行筛选,所获取的字段涉及评论ID、用户ID、用户名、影片名称、评论内容、评分、点赞数、回复数以及发布时间,借助百度情感分析API对影评内容展开处理,得到情感极性、置信度得分、分类标签。处理完毕的情感分析结果会被传送到movieSentimentAnalysis.html模板那儿进行可视化展示。

六.部分功能代码

import scrapy

import pymysql

import pymssql

from ..items import xiangmuItem

import time

import re

import random

import platform

import json

import os

from urllib.parse import urlparse

import requests

import emoji

class xiangmuSpider(scrapy.Spider):

name = 'xiangmuSpider'

spiderUrl = 'https://url网址'

start_urls = spiderUrl.split(";")

protocol = ''

hostname = ''

def __init__(self, *args, **kwargs):

super().__init__(*args, **kwargs)

# 列表解析

def parse(self, response):

_url = urlparse(self.spiderUrl)

self.protocol = _url.scheme

self.hostname = _url.netloc

plat = platform.system().lower()

if plat == 'windows_bak':

pass

elif plat == 'linux' or plat == 'windows':

connect = self.db_connect()

cursor = connect.cursor()

if self.table_exists(cursor, 'xiangmu') == 1:

cursor.close()

connect.close()

self.temp_data()

return

list = response.css('ul.subject-list li.subject-item')

for item in list:

fields = xiangmuItem()

fields["laiyuan"] = self.remove_html(item.css('div.pic a.nbg::attr(href)').extract_first())

if fields["laiyuan"].startswith('//'):

fields["laiyuan"] = self.protocol + ':' + fields["laiyuan"]

elif fields["laiyuan"].startswith('/'):

fields["laiyuan"] = self.protocol + '://' + self.hostname + fields["laiyuan"]

fields["fengmian"] = self.remove_html(item.css('div.pic a.nbg img::attr(src)').extract_first())

fields["xiaoshuoming"] = self.remove_html(item.css('div.info h2 a::attr(title)').extract_first())

detailUrlRule = item.css('div.pic a.nbg::attr(href)').extract_first()

if self.protocol in detailUrlRule:

pass

elif detailUrlRule.startswith('//'):

detailUrlRule = self.protocol + ':' + detailUrlRule

else:

detailUrlRule = self.protocol + '://' + self.hostname + detailUrlRule

fields["laiyuan"] = detailUrlRule

yield scrapy.Request(url=detailUrlRule, meta={'fields': fields}, callback=self.detail_parse)

# 详情解析

def detail_parse(self, response):

fields = response.meta['fields']

try:

if '(.*?)' in '''div#info span a::text''':

fields["zuozhe"] = re.findall(r'''div#info span a::text''', response.text, re.S)[0].strip()

else:

if 'zuozhe' != 'xiangqing' and 'zuozhe' != 'detail' and 'zuozhe' != 'pinglun' and 'zuozhe' != 'zuofa':

fields["zuozhe"] = self.remove_html(response.css('''div#info span a::text''').extract_first())

else:

fields["zuozhe"] = emoji.demojize(response.css('''div#info span a::text''').extract_first())

except:

pass

# 去除多余html标签

def remove_html(self, html):

if html == None:

return ''

pattern = re.compile(r'<[^>]+>', re.S)

return pattern.sub('', html).strip()

# 数据库连接

def db_connect(self):

type = self.settings.get('TYPE', 'mysql')

host = self.settings.get('HOST', 'localhost')

port = int(self.settings.get('PORT', 3306))

user = self.settings.get('USER', 'root')

password = self.settings.get('PASSWORD', '123456')

try:

database = self.databaseName

except:

database = self.settings.get('DATABASE', '')

if type == 'mysql':

connect = pymysql.connect(host=host, port=port, db=database, user=user, passwd=password, charset='utf8')

else:

connect = pymssql.connect(host=host, user=user, password=password, database=database)

return connect

# 断表是否存在

def table_exists(self, cursor, table_name):

cursor.execute("show tables;")

tables = [cursor.fetchall()]

table_list = re.findall('(\'.*?\')',str(tables))

table_list = [re.sub("'",'',each) for each in table_list]

if table_name in table_list:

return 1

else:

return 0

@main_bp.route("/python05c7298x/danchexinxi/save", methods=['POST'])

def python05c7298x_danchexinxi_save():

'''

'''

if request.method == 'POST':

msg = {"code": normal_code, "msg": "success", "data": {}}

req_dict = session.get("req_dict")

if danchexinxi.count(danchexinxi, danchexinxi, {"danchebianhao":req_dict["danchebianhao"]})>0:

msg['code'] = crud_error_code

msg['msg'] = "单车编号已存在"

return jsonify(msg)

for key in req_dict:

if req_dict[key] == '':

req_dict[key] = None

error= danchexinxi.createbyreq(danchexinxi, danchexinxi, req_dict)

if error!=None:

msg['code'] = crud_error_code

msg['msg'] = error

return jsonify(msg)

为什么选择我们

大学毕业那年,曾经有幸协助指导老师做过毕业设计课题分类、论文初选(查看论文的格式)、代码刻录等打杂的事情,也帮助过同界N多同学完成过毕业设计工作,毕业后在一家互联网大厂工作8年,先后从事Java前后端开发、系统架构设计等方面的工作,有丰富的编程能力和水平,也在工作之余指导过别人完成过一些毕业设计的工作。2016年至今,团队已指导上万名学生顺利通过毕业答辩,目前是csdn特邀作者、优快云全栈领域优质创作者,博客之星、掘金/华为云/B站/知乎等平台优质作者,计算机毕设实战导师,专注于大学生项目实战开发,讲解,毕业答疑辅导,欢迎咨询~✌

最后

💕💕

最新计算机毕业设计选题篇-选题推荐

小程序毕业设计精品项目案例-200套

Java毕业设计精品项目案例-200套

Python毕业设计精品项目案例-200套

大数据毕业设计精品项目案例-200套

💟💟如果大家有任何疑虑,欢迎在下方位置详细交流。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?