以下基本出自:http://dblab.xmu.edu.cn/blog/931-2/#more-931

一、下载spark-2.4.0

下载链接:https://archive.apache.org/dist/spark/spark-2.4.0/spark-2.4.0-bin-without-hadoop.tgz

二、上传解压

(我用的是SecureCRT)

1、进入要上传文件的目录:

cd /opt/modules/softwares

2、上传文件:

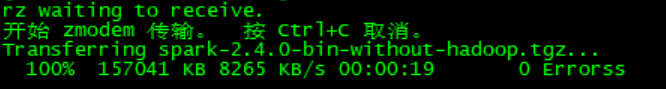

rz

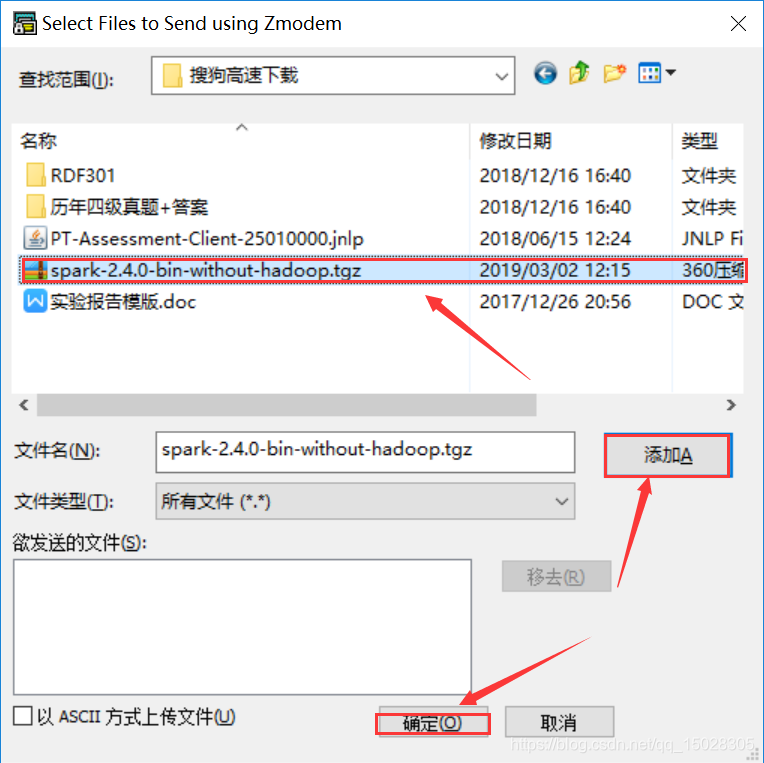

出现下图界面,选中spark压缩包,点击添加,然后点击确定

若是没反应,再输入rz

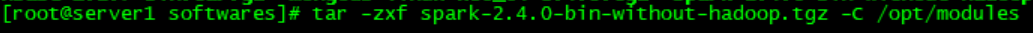

3、解压文件

将压缩包解压到(你要解压的文件夹目录)

[tar -zxf 目标压缩包 -C 目标文件夹]

tar -zxf spark-2.4.0-bin-without-hadoop.tgz -C /opt/modules

4、重命名spark(原来的名字太长了)

mv spark-2.4.0-bin-without-hadoop spark-2.4.0

三、配置

1、拷贝配置文件

进入spar-2.4.0中

cd spark-2.4.0

拷贝配置文件

cp ./conf/spark-env.sh.template ./conf/spark-env.sh

2、编辑配置文件(我喜欢用Notepad++修改配置文件)

vim ./conf/spark-env.sh

在最后添加

export SPARK_DIST_CLASSPATH=$(/opt/modules/hadoop-2.7.3/bin/hadoop classpath)

括号里边为什么这么写???不知道。。。。

四、测试

1、进入spark-shell环境

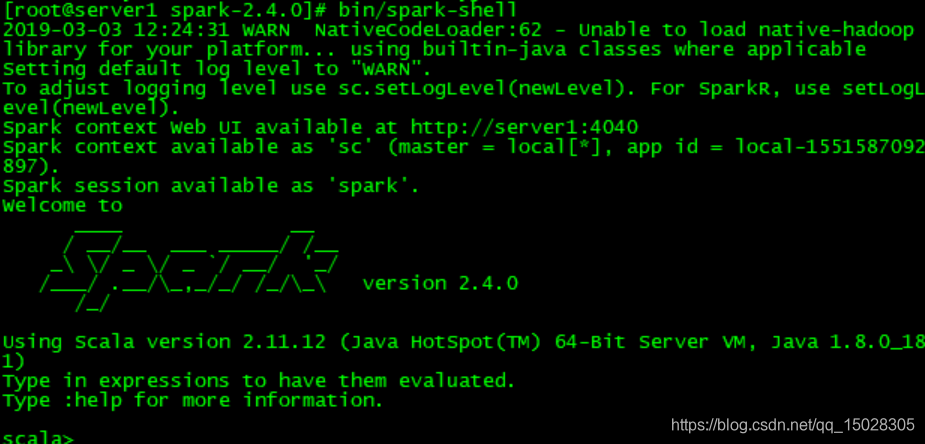

bin/spark-shell

该命令省略了参数,这时,系统默认是“bin/spark-shell –master local[*]”,也就是说,是采用本地模式运行,并且使用本地所有的CPU核心。

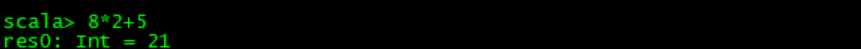

启动spark-shell后,就会进入“scala>”命令提示符状态,如下图所示:

2、测试

现在输入8*2+5回车,就会出来答案,res0:Int = 21

3、退出shell环境

:quit 或者 ‘Ctrl’+‘D’

关于sbt的暂时不写了…………因为我安装不成功。

五、下载sbt-1.2.8

下载地址:sbt-launch.jar

六、安装sbt

1、创建sbt文件夹

mkdir /opt/modules/sbt

2、将jar包上传到sbt文件夹中

cd /opt/modules/sbt

rz

4711

4711

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?