目录

摘要

This week, I studied Word Embedding and Word2vec models, learned about their origins, principles, and shortcomings, and went through the mathematical derivation of the Word2vec formula. Additionally, I read a review paper on automatic rumor detection on microblogs, which gave me insight into current rumor detection methods, datasets used, and existing limitations.

本周,我学习了Word Embedding和Word2vec模型,了解了它们的由来、原理以及不足,学习了Word2vec的数学公式推导过程;另外,我阅读了一篇关于微博上的自动谣言检测综述类论文,了解了目前大多数谣言检测方法、使用的数据集以及存在的不足之处。

文献阅读

1、题目

Automatic Rumor Detection on Microblogs: A Survey

Comments: Submitted to IEEE TKDE

Subjects: Social and Information Networks (cs.SI)

2、摘要

现代社交媒体平台上越来越多的多媒体内容在许多应用中都很有价值。虽然社交媒体的开放性和便利性特征也促进了许多在线谣言,如果没有验证,这些谣言将立即传达给数千名用户,并造成严重的损害。许多努力已经采取了自动打败在线谣言的方法,通过使用机器学习技术在开放网络上提供的丰富内容进行挖掘。大多数谣言检测方法可以归类为三种范例:基于手工制作特征的分类方法、基于传播的方法和基于神经网络的方法。 在本次调查中,作者介绍了一种正式的谣言定义,与文献中使用的其他定义进行了比较。总结了迄今为止自动谣言检测的研究,并详细介绍了谣言检测的三种范例。

3、介绍

下面展示Facebook、Twitter和微博三个主要平台的反谣言设计:

Facebook通过用户和外部事实核查员的帮助标记虚假新闻故事。用户向平台报告可能的谣言,平台将其发送给诸如AP、FactCheck.org和Snopes.com等核查组织进行验证。经过验证的虚假故事将被公开标记为第三方事实核查员争议的内容,无论在何时何地出现在社交网络上。如果用户坚持分享已验证的虚假故事,则会收到另一个警告。

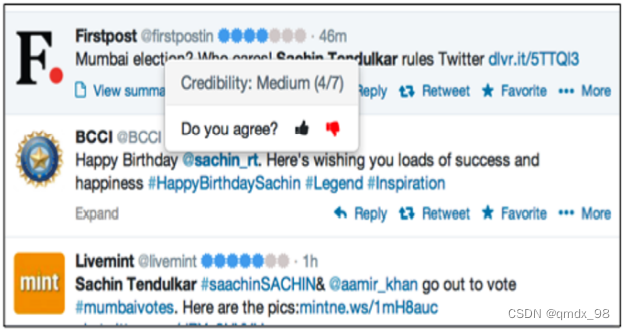

Twitter采用半自动策略,结合自动评估和众包注释,标记可能的虚假推文。每个推文都会被分配一个自动生成的算法可信度评分。如果用户不同意评分,他们可以提供反馈意见。

在微博上,鼓励用户报告可能的虚假推文。这些推文会经过精英用户组成的委员会进行审查和判断。经过验证的虚假推文将被标记。

以上方法都依赖于社交媒体用户或人类专家来检测谣言。此外,这些方法大多集中在社交媒体传播过程中打击谣言,而不是在早期阶段发现新兴谣言。虽然手动标注大规模社交媒体数据的谣言已变得可行,但手动标注仍面临以下挑战:

1)劳动密集型和时间成本: 即使有良好的动机,用户也可能因繁重的劳动和原始手动交互的成本而感到沮丧,以便标记谣言。繁重的劳动和时间成本是手动标记大规模在线数据的障碍。

2)标签质量: 与普通的人类交互注释,比如在图片分享网站上给图片打标签,识别新鲜谣言涉及更多的领域知识和详细的检查。一个新闻专家审核一条新闻报道都很困难,更不用说非专业用户了。低质量的标签将直接危及谣言的识别,并未能满足准确的谣言检测资格要求。

社会媒体上的自动谣言检测 的出现,在线数据的非结构性、不完全性和噪声性使得处理和理解这些数据非常具有挑战性:

- 语义理解: 大多数谣言是故意编造的,以误导公众。虚假信息被混合并伪装在谣言故事中。对机器来说,完全理解这种语义是非常困难的。

- 巨大的变化: 谣言可以涵盖各种主题,采取各种语言风格。对区分某种类型的谣言有效的特征可能对其他类型的谣言效果很差。在有限的标记数据上训练的算法可能会在未见过的新谣言上失败。

- 多模态数据: 社交媒体上的谣言除了纯文本之外,还经常采取图片或视频的形式。虽然不同模式的信息可以为谣言检测提供线索,但如何从每个模式中提取突出的特征并有效地将它们融合在一起是一个挑战。

- 异质性的传播结构: 谣言在社交网络上传播的过程中,用户可以进行讨论和评论。用户的行为有助于为谣言构建一个潜在的社会环境。表征传播网络上的这些行为对于识别网上的谣言至关重要。

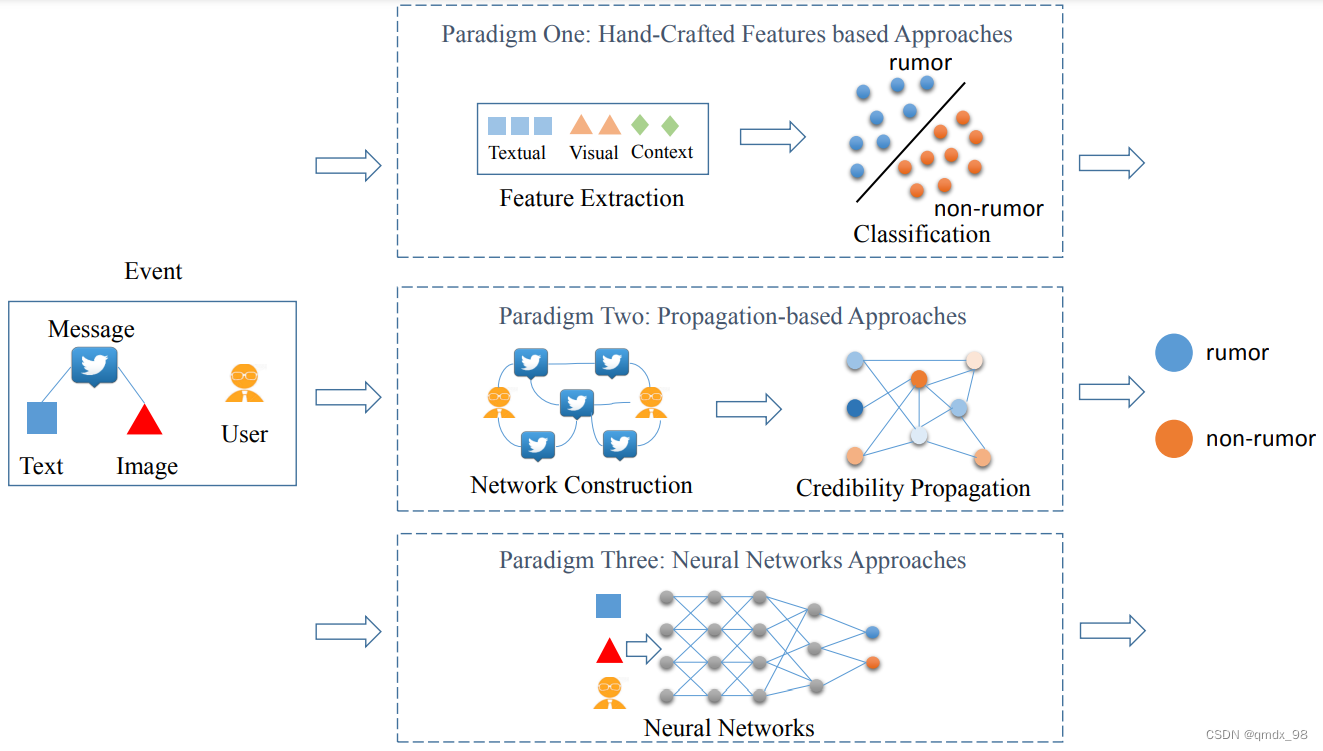

大多数方法将自动谣言检测制定为一个两类分类任务,可分为三类:基于手工制作的特征方法、基于传播的方法和神经网络方法:

1)第一类:基于手工制作的特征的方法: 传统方法应用手工制作的特征来描述谣言在高维空间的分布,分离超平面将由分类器来学习。这些研究从谣言的文本和视觉内容中提取特征。为了避免内容语义的变化,还提出了一些社会背景特征来捕捉谣言的特征,因此特征工程成为分类前的致命步骤。然而,由于一些谣言缺乏一些关键特征,这些方法往往导致不稳定和不可靠的结果。

2)第二类:基于传播的方法: 为了利用社会网络的异质性结构,基于图的优化方法将信息和用户连接成一个整体网络,并将它们的可信度作为一个整体进行评估。当网络是收敛的时候,可以得到一个未分类的文本的类别。但是,很明显可以看到,这些工作忽略了谣言所代表的文本信息。

3)第三类:神经网络方法: 最近,有人提出用深度神经网络自动学习和融合多模态特征来进行谣言检测。通过将文本数据建模为时间序列,递归神经网络或卷积神经网络都可以学习潜在的文本表征并提高分类的准确性。与利用传统分类器的工作相比,这些工作可以显著提高性能。

4、定义

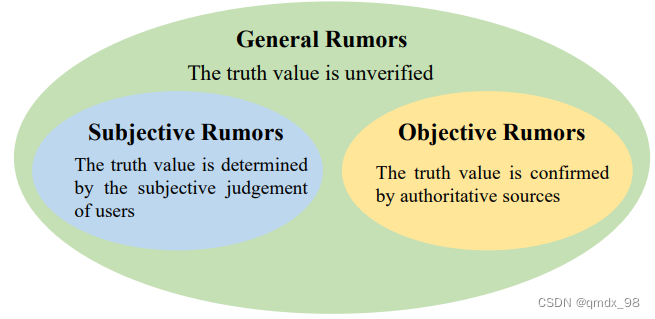

客观谣言: 严格来说等同于经过验证的虚假信息。一旦一个声明被权威人士证实有虚假或捏造的内容,它就被贴上了谣言的标签。这种谣言也被称为 "虚假谣言"或 “假新闻”。

一般谣言: 被认为是一种信息,其真实性没有得到验证。未经核实的谣言指的是没有经过权威或可信来源的正式确认的信息,例如权威的新闻机构或现场的证人。

主观谣言: 来自于用户的主观判断。

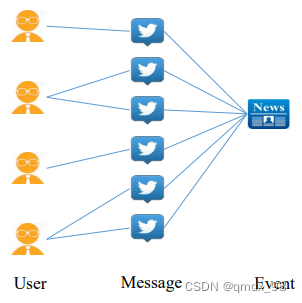

本文中采用了谣言的客观定义,一个新闻故事 e e e被定义为一组由 n n n条相关信息组成的 M = { m 1 , m 2 , . . . , m n } M=\{m_1, m_2, ..., m_n\} M={m1,m2,...,mn}。对于每条消息 m i m_i mi来说,它是由代表其包含的文本、图片、视频和其他内容的属性元组组成的。每条消息 m i m_i mi也与发布该消息的用户 u i u_i ui相关联。用户 u i u_i ui用一组属性表示,包括姓名、年龄、注册时间和头像图片等。谣言检测任务定义如下:

谣言检测定义: 给定一个新闻故事e及其消息集M和用户集U,谣言检测任务的目的是确定这个故事是真的还是假的,即学习一个预测函数

F

(

e

)

→

{

0

,

1

}

F(e)→\{0,1\}

F(e)→{0,1},满足:

F

(

e

)

=

{

1

,

if e is conf irmed as f alse

0

,

otherwise

F (e) = \begin{cases} 1, & \text {if e is conf irmed as f alse} \\ 0, & \text{otherwise} \end{cases}

F(e)={1,0,if e is conf irmed as f alseotherwise

5、基于手工制作的特征的方法

谣言检测的基本定义是一个二元分类问题。关于这项任务的大多数文献都遵循机器学习领域常用的监督分类的学习范式:

- 提取代表两类样本的特征;

- 用提供的样本训练一个适当的分类器;

- 在未见过的数据上进行测试和评估。

这些程序的第一个关键步骤是如何提取突出的特征。此外,内容不是独立的,来自不同的模式。

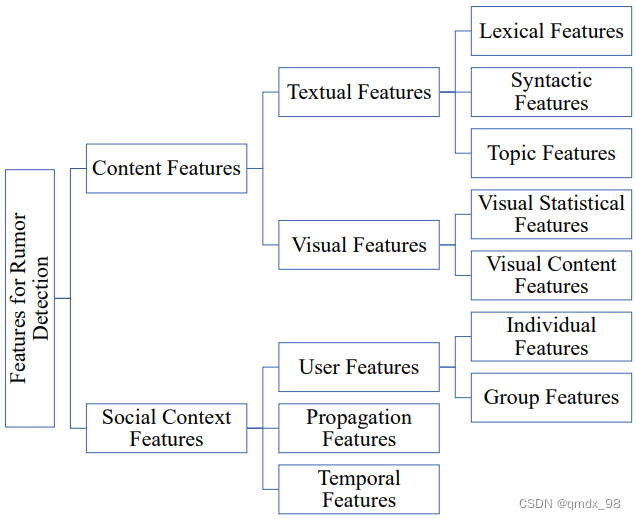

在社交媒体的范围内,一个新闻故事e包含丰富的多模式资源作为其内容,并在其传播过程中与某些社会背景相关,如图所示:

特征来自故事的两个主要方面:它的内容和它的社会环境,如图:

内容特征包含以下方面:

文本特征:

-

词法特征是在谣言的字词层面上提取的特征,可以是字词的统计,词法谣言模式或情感词典。

-

句法特征表示句子层面的谣言。基本的句法特征是谣言信息的简单统计,如关键词的数量,句子的情感分数或极性和部分语音标记。

-

主题特征是在消息集的层面上提取的,其目的是理解消息和它们在语料库中的基本关系。

视觉特征:

-

视觉统计特征是谣言中附带的图像的统计。与文本内容的统计特征类似,图像的一些基本统计被证明在区分谣言和非谣言方面具有明显的特征。

-

视觉内容特征的提取是为了从视觉角度描述图像的分布,如视觉清晰度、多样性和一致性。

社会环境特征包含以下方面:

与传统媒体相比,社交媒体的关键特征之一是对各种互动的开放性。

-

用户特征: 来源于用户社交网络。谣言是由少数用户创造并被许多用户传播的。分析其特征可以为谣言检测提供重要线索。用户特征可以描述单个用户或由多个相关用户组成的用户组的特征。

-

传播特征: 来自于谣言传播的融合网络。

-

时间特征: 标志着谣言传播的重要时间点或生命周期模式。

6、基于传播的方法

社交媒体上的信息和事件之间存在一些潜在的相关性。相似的信息在事件中往往具有相同的准确性。通过挖掘实体间的关系,提出了基于传播的方法,并从整体上评价事件和事件的可信度。基于传播的谣言检测通常有两个主要步骤:

- 构建可信性(credibility)网络: 谣言检测中的实体,如消息、用户、主题或事件,被定义为网络工作中的节点。每个节点都有一个初始可信度值来表示其对真实性的信心。这些实体之间的联系是根据它们在社交媒体上的语义关系或交互关系来定义和计算的。

- 可信度传播: 在一定的节点一致性和网络平滑度假设下,可信赖度值沿着加权链路在所构建的网络上传播,直到收敛,最终得到每个实体的可信度评价.

基于传播的谣言检测方法的三种典型实现,即用户消息事件网络、层次内容网络和冲突观点网络

6.1 User-Message-Event Network 用户消息事件网络

构建一个由用户、消息和事件在两种直觉下构成的网络:

- 可信用户一般不会对谣言事件提供可信度。

- 可信消息之间的链接比谣言消息的链接有更大的权重,因为谣言事件中的消息不会做出连贯的声明

6.1.1 Network structure 网络构建

网络结构如下:

- 每个用户都链接到一个消息,如果显示该消息

- 如果每个消息属于某个事件,则将其链接到该事件

- 消息之间相互链接,表示消息之间的关系

- 事件与其他事件相关联,表示事件间的关系

6.1.2 Credibility propagation可信度传播

每个消息的初始可信度值来自基于特征的分类器的结果。然后使用类似网页排名的迭代在这个网络上传播。在每次迭代中,可信度值更新如下:

- 对于每一条消息,它的可信度值受到三个方面的影响:它链接到的用户和事件以及其他链接消息。这些方面的贡献经过加权,以确保在更新其可信度时具有可比性。

- 对于每个事件,它的可信度值受到两个方面的影响:它链接到的消息和其他链接事件。因此,其可信度值也随之更新。

- 对于每个用户,它链接到的所有消息的平均信用度都是计算出来进行更新的。

6.2 Hierarchical Content Network 分层网络内容

提出了由事件内容的不同语义层次构成的三层可信度网络。为了最小化用户的影响,关注事件更深层次的语义关系。

6.2.1 Network structure 网络结构

层次化的内容网络有三层实体:消息层、子事件层和事件层

如果一个消息被聚集成该子事件,则该消息被链接到该子事件;子事件链接到该事件;所有消息都相互链接,子事件也是如此。

6.2.2 Credibility propagation 可信度传播

在假设具有较大链路权值的实体具有相似的可信度值的情况下,将可信度传播问题表示为一个图优化问题。

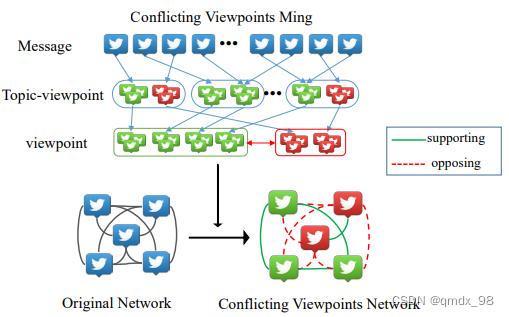

6.3 Conflicting Viewpoints Network 相互冲突的观点网络

微博客(microblogs)信息之间存在两种关系。一种关系是支持,即表达相同观点的消息相互支持彼此的可信度。另一种关系是对立的,表达冲突观点的信息会降低彼此的可信度

6.3.1 Network structure 网络结构

利用微博中相互矛盾的观点,提出了一个支持和反对关系的可信度网络:

- 矛盾的观点挖掘: 冲突的观点是通过一个联合的主题-观点模型来挖掘的。此模型将每个消息表示为主题和每个主题的视点的混合。然后对这些主题-视点对进行约束,形成最终的冲突视点。

- 链接的定义: 任何两个消息之间的链接都是基于挖掘的冲突观点的结果来计算的。链接的权值计算为来自主题模型的两个消息的概率表示之间的距离。而链接的极性是由视点聚类定义的:消息具有相同的视点形成正链接,否则它们形成负链接。

- 网络建设: 事件中的所有消息都彼此链接。它们之间的链接如上所述。

6.3.2 Credibility propagation 可信度传播

针对网络中的负链接(the negative links),提出了一种损失函数,它可以保证具有支持关系的消息具有相似的可信度,而具有相反关系的消息具有相反的可信度,或者两者的可信度都接近于零。在给出损失函数的基础上,给出了损失函数的最优解。

7、DEEP NEURAL NETWORKS APPROACHES 深度神经网络的方法

基于深度学习的方法旨在自动学习谣言数据的深度表示,根据神经网络的不同结构,将神经网络方法进一步细分为两类:

- 循环神经网络(Recurrent Neural Networks): 基于RNN的结构,将谣言数据建模为序列数据。关键是RNN中各单元之间的连接形成一个直接的循环,从而建立一个内部的网络状态,使其能够捕捉到具有谣言扩散特征的动态时间信号。

- 卷积神经网络: CNN由堆叠的卷积和池化层组成,其结构有助于对重要的语义特征进行建模。基于CNN的方法,假设CNN不仅可以自动从输入实例中提取局部-全局的重要特征,还可以揭示这些高级交互。

7.1 RNN-based methods 基于RNN的方法

- 用递归神经网络检测谣言: 一个谣言事件由成千上万个帖子组成,将帖子按时间间隔进行批量处理,并将它们作为一个时间序列中的单个单元,然后使用RNN序列建模。在每个时间间隔中,将使用词汇表中前k个词汇的 t f ∗ i d f tf*idf tf∗idf值作为输入。模型旨在从监督下的谣言数据中学习时间和文本表征。

- 引入了注意力机制: 首先将帖子分成时间间隔,并使用 t f ∗ i d f tf ∗ idf tf∗idf作为输入的表示。在每个时间步长中,隐藏状态将被分配一个权重参数,以衡量其重要性和对结果的贡献。

- 混合模型(CSI): 模型由三个模块组成: 捕获、评分和整合。第一个模块是基于反应和文本;它使用一个循环神经网络来捕捉用户在特定文章上的活动的时间模式。第二个模块根据用户的行为来学习来源特征,一个用户由一个向量来表示。在第三个模块中,前两个模块的结果被整合为一个向量,用来对一篇文章进行虚假与否的分类。

- 基于多模态融合的模型: 对于一个给定的帖子,其文本和社会背景首先被LSTM单元融合。然后,联合表示与从预训练的深度VGG-19中提取的视觉特征相融合。LSTM在每个时间步骤的输出被用作神经元级别的注意力,以便在融合过程中协调视觉特征。

7.2 CNN-based methods 基于CNN的方法

- 基于卷积神经网络的谣言检测方法: 将每个谣言事件分成几个阶段。随后,所有的事件被分割成若干组微博帖子。通过doc2vec学习每组的表示方法,因此CAMI的输入序列是由一组向量组成的。最后,这些向量被送入两层卷积神经网络,得到两类分类的最终结果。

- 基于CNN+RN的模型: 模型利用CNN提取一连串更高层次的短语表征来学习各个谣言相关推文的隐藏表征。然后利用RNN的部分来处理CNN获得的时间序列。

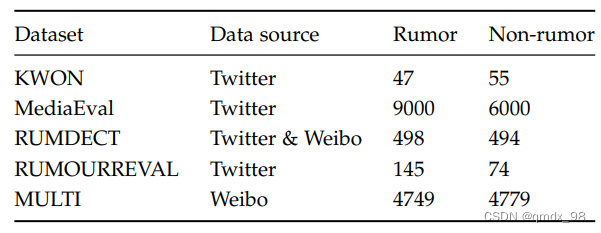

8、数据集

9、结论

社交媒体上传播的谣言可能严重影响人们的日常生活。然而,大多数应用仍然依靠人工努力,无论是人类专家还是普通用户,来打击不断增加的谣言。因此,发展自动谣言检测方法显得十分必要。作者将现有的工作分为三个范式,即基于手工制作的特征方法、基于传播的方法和神经网络方法。

作者详细描述了三种不同的谣言检测范式:基于特征的分类方法、可信度传播方法和神经网络方法。对于这些范式中的每一种方法,其目的都是为了实现两个目标:一个是提取突出的特征来代表由谣言组成的多媒体内容和社交网络上的谣言所产生的社会背景,另一个目标是建立强大的机器学习算法来将谣言与普通故事分开。

10、未来研究的四个主要挑战

-

早期检测: 谣言在几秒钟或几分钟内就会成为病毒,在谣言的早期阶段发现它们是至关重要的。然而,大多数现有的研究通过假设他们拥有谣言的所有生活时间内的所有内容来检测谣言。

-

解释式检测: 现有的谣言检测方法只给出了一个故事是否是谣言的最终决定,几乎没有透露他们为什么做出这个决定的信息,找到支持这一决定的证据将有利于揭穿谣言并防止其进一步传播。

-

长文本谣言检测: 长文谣言有丰富的语义信息,不仅要提高长文谣言的检测性能,还要指出虚假信息在段落中的准确位置。

-

多模态的谣言检测: 分析多模态数据之间的关系,开发基于融合的先进模型来利用这些数据,可以成为在更复杂的场景中检测谣言的关键。

深度学习

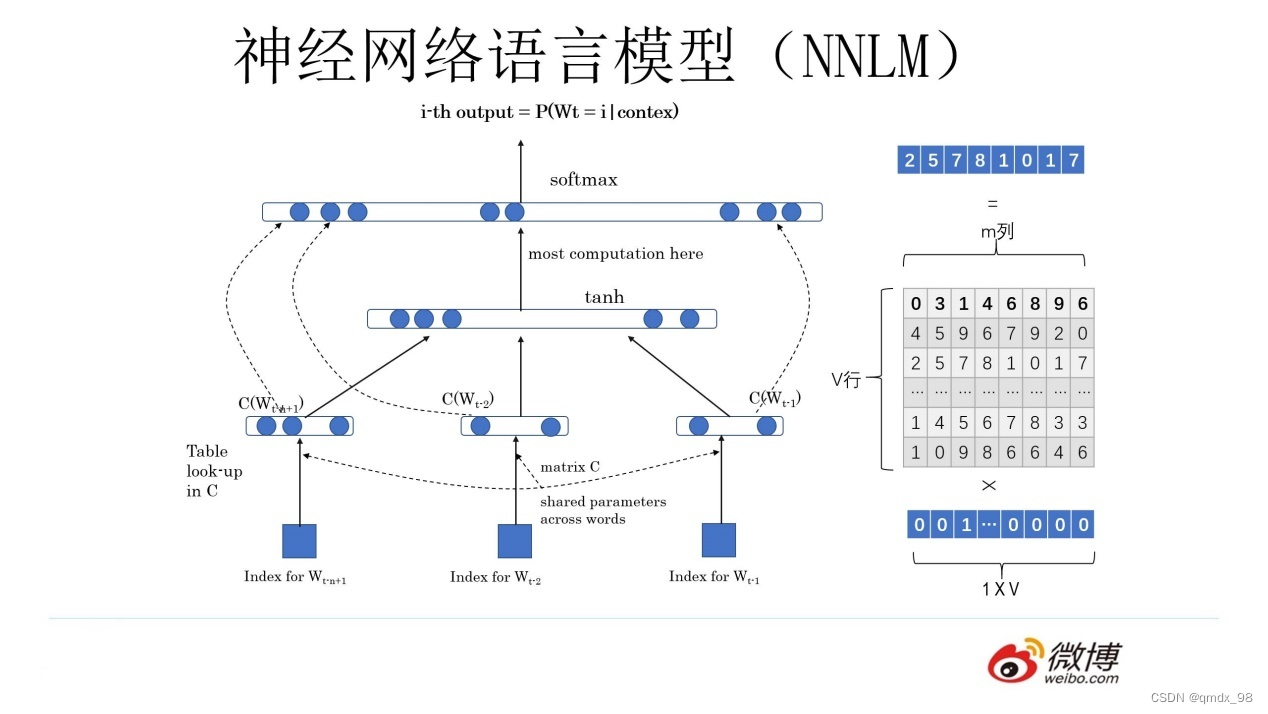

1、Word Embedding

由于独热表示无法解决词之间相似性问题,这种表示很快就被词向量表示给替代了,神经网络语言模型中出现的一个词向量$ C(w_i)$就是单词对应的 Word Embedding 值——词向量

上图所示有一个

V

×

m

V×m

V×m 的矩阵 Q,这个矩阵 Q 包含 V 行,V 代表词典大小,每一行的内容代表对应单词的 Word Embedding 值。

不过 Q 的内容也是网络参数,需要学习获得,训练刚开始用随机值初始化矩阵 Q,当这个网络训练好之后,矩阵 Q 的内容被正确赋值,每一行代表一个单词对应的 Word embedding 值。

举例词向量的计算过程:

[

0

0

0

1

0

]

[

17

24

1

23

5

7

4

6

13

10

12

19

11

18

25

]

=

[

1

0

1

2

1

9

]

\begin{bmatrix}0 & 0 & 0 & 1 & 0\end{bmatrix} \begin{bmatrix} 17 & 24 & 1 \\ 23 & 5 & 7 \\ 4 & 6 & 13 \\ 10 & 12 & 19 \\ 11 & 18 & 25\end{bmatrix}= \begin{bmatrix}1 & 0 & 1 & 2 & 1 & 9\end{bmatrix}

[00010]

1723410112456121817131925

=[101219]

通过上述词向量的计算,可以发现第 4 个词的词向量表示为

[

10

12

19

]

\begin{bmatrix}10 & 12 & 19\end{bmatrix}

[101219]。

如果再次采用余弦相似度计算两个词之间的相似度,结果不再是 0 ,既可以一定程度上描述两个词之间的相似度。

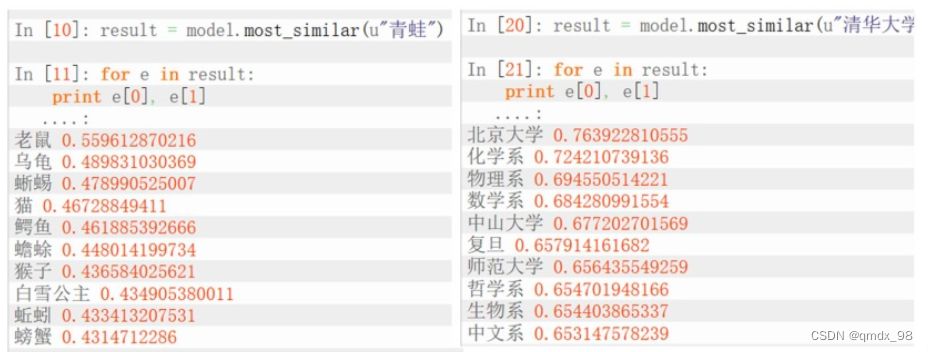

2、Word2vec概念

Word2Vec 的网络结构其实和神经网络语言模型(NNLM)是基本类似的,不过尽管网络结构相近,而且都是做语言模型任务,但是他们训练方法不太一样。

开发 Word2Vec 的核心:解决在做什么来锻炼一个词在中心词的上下文中出现的概率

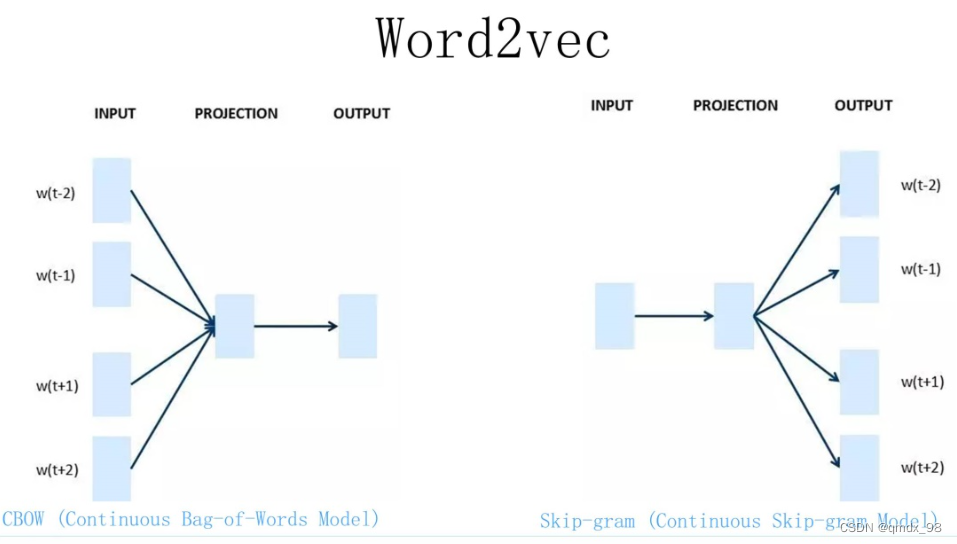

Word2Vec 有两种训练方法:

- 第一种叫 CBOW,核心思想是从一个句子里面把一个词抠掉,用这个词的上文和下文去预测被抠掉的这个词;

- 第二种叫做 Skip-gram,和 CBOW 正好反过来,输入某个单词,要求网络预测它的上下文单词。

NNLM训练:输入一个单词的上文,去预测这个单词。主要任务是要学习一个解决语言模型任务的网络结构,语言模型是看到上文预测下文。

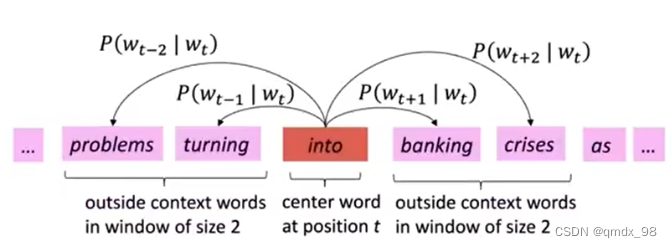

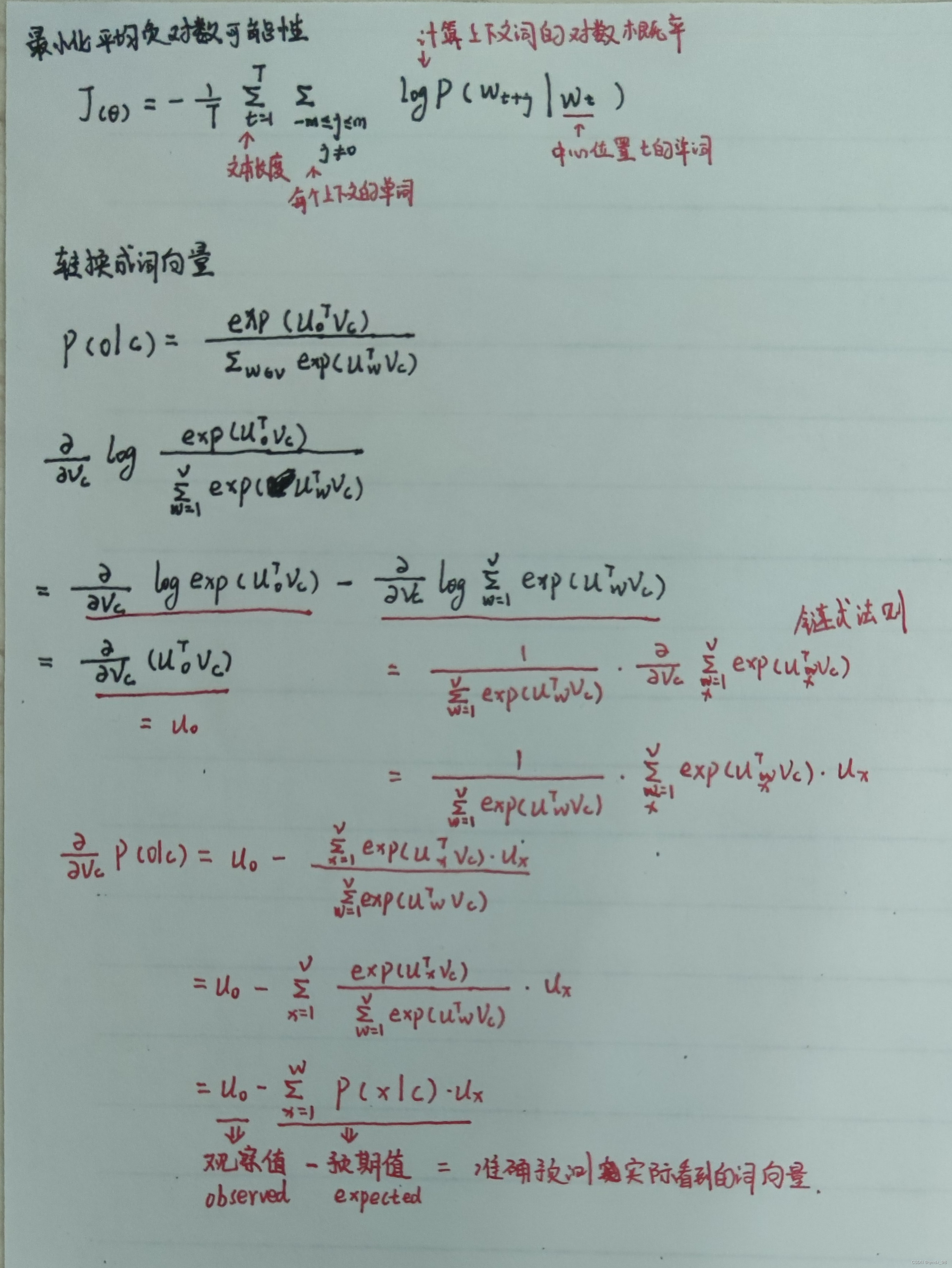

3、 P ( w t + j ∣ w t ) P(w_{t+j}|w_t) P(wt+j∣wt)计算过程

总结

本周学习了独热编码、Word Embedding和Word2vec模型,了解了其基本原理及Word2vec模型数学推导。

548

548

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?