准备

1.HADOOP集群环境或者伪集群;

2.KETTLE6.0环境;

前言

该部署是在windows环境下操作,linux上操作类似。

KETTLE HADOOP插件配置

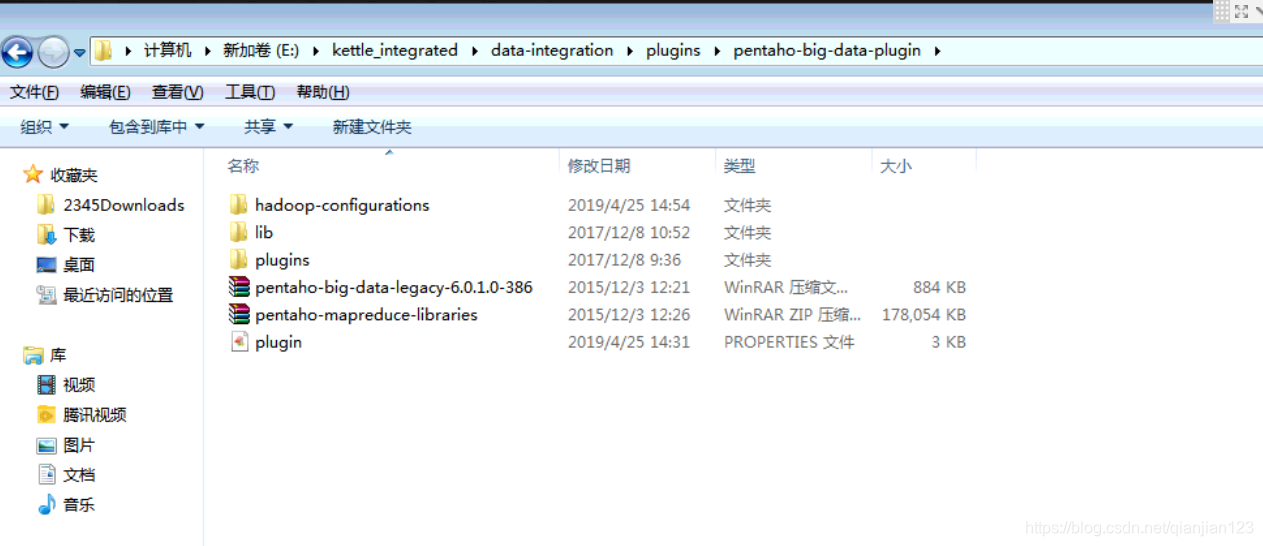

1.打开插件所在目录,E:\kettle_integrated\data-integration\plugins\pentaho-big-data-plugin。如图:

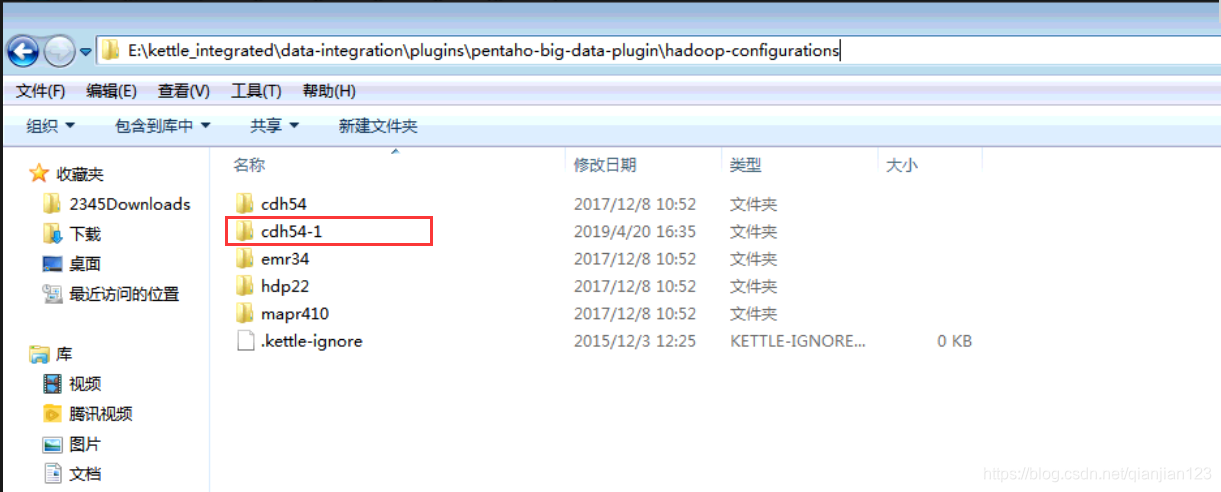

2.打开步骤[1]图中的hadoop-configurations目录,如下图:

其中cdh54-1是直接复制cdh54的,之后的操作就是cdh54-1。

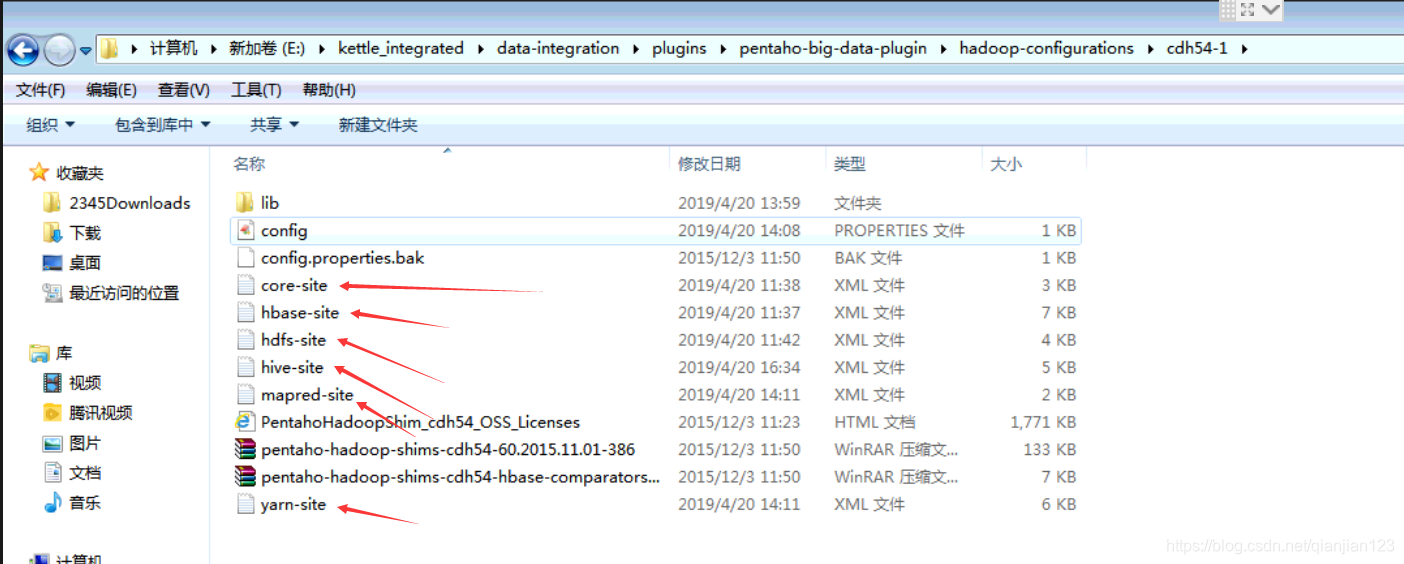

3.复制HADOOP集群下的配置文件放到cdh54-1目录下,如下图:

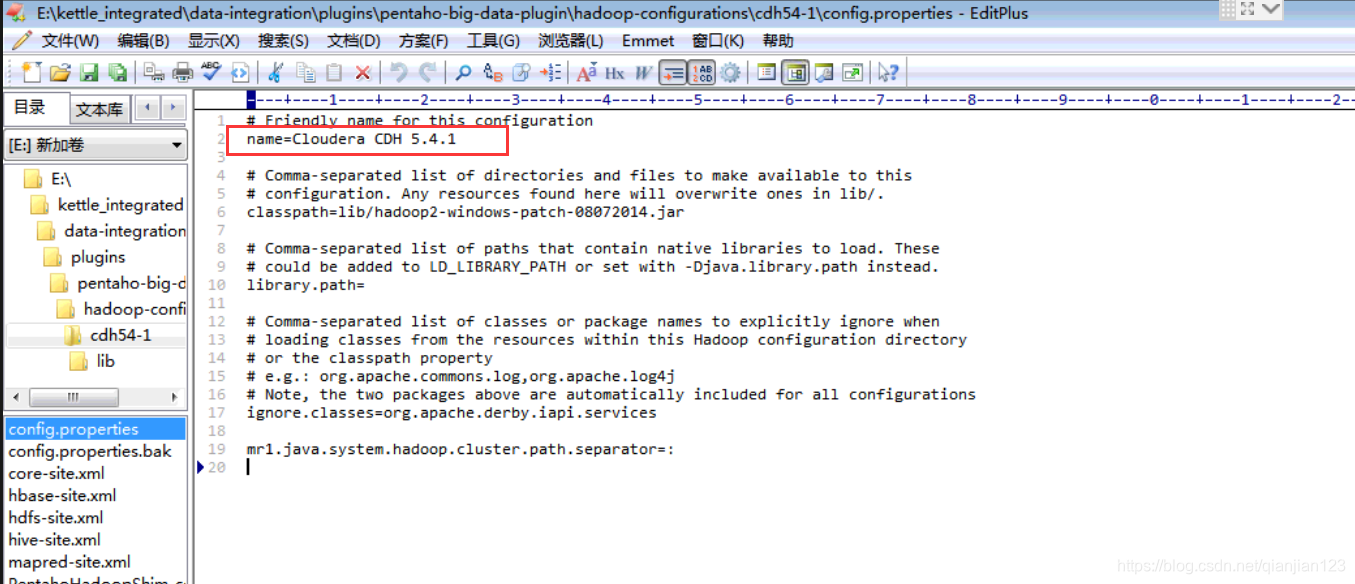

4.配置步骤[3]图片中config.properties文件,修改其中name属性值(因为这是从cdh54直接复制过来的,所以需要重命名,不然在spoon的可视化页面会出现重名不好区分),如下图:

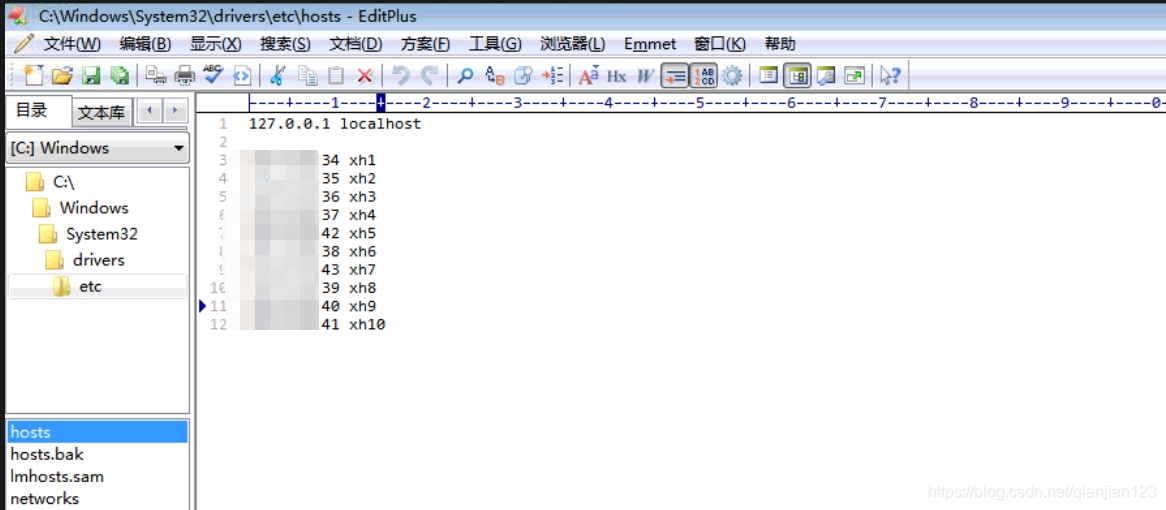

5.修改windows环境的hosts文件(因为是要在windows上测试,所以需要配置HADOOP集群对应的主机名映射),文件路径:C:\Windows\System32\drivers\etc\hosts,如下图:

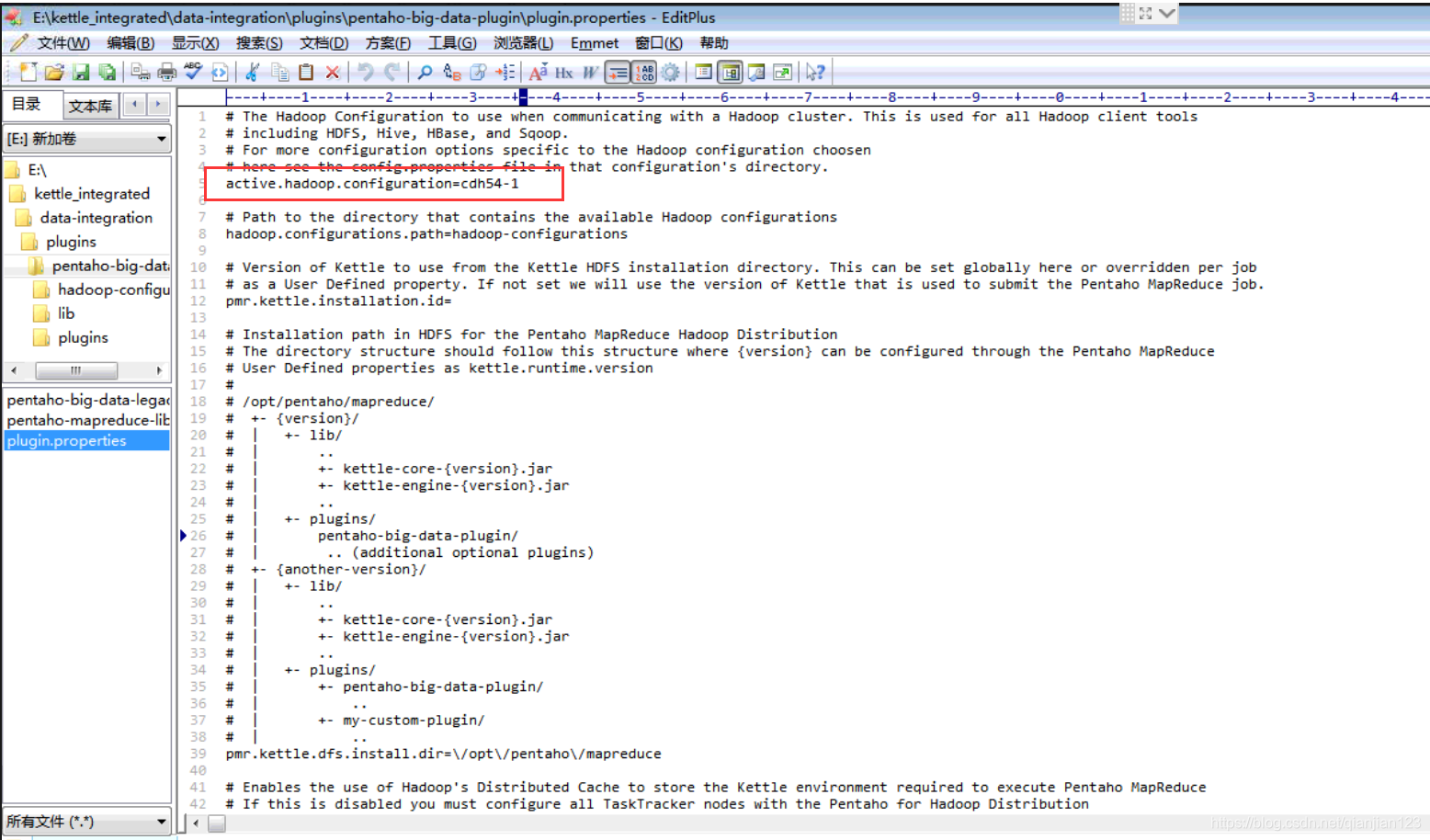

6.修改启用的HADOOP配置目录

打开路径:E:\kettle_integrated\data-integration\plugins\pentaho-big-data-plugin,找到plugin.properties文件,修改active.hadoop.configuration,如下图:

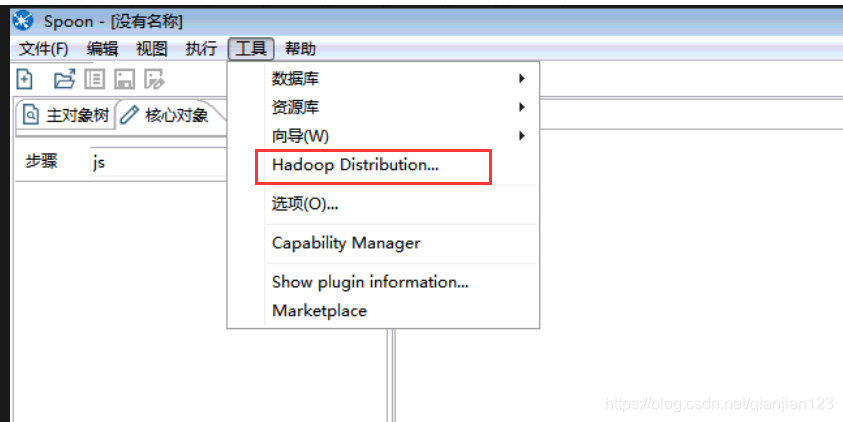

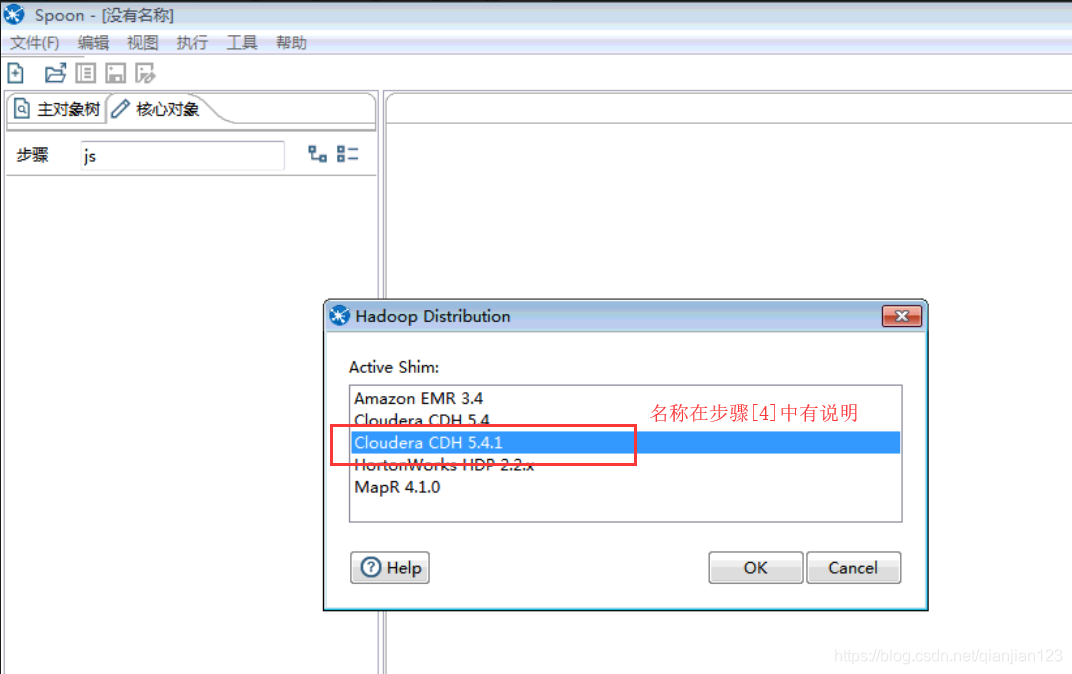

当然也可以在spoon可视化界面,直接选择,操作如下:菜单工具->hadoop distribution

插件使用

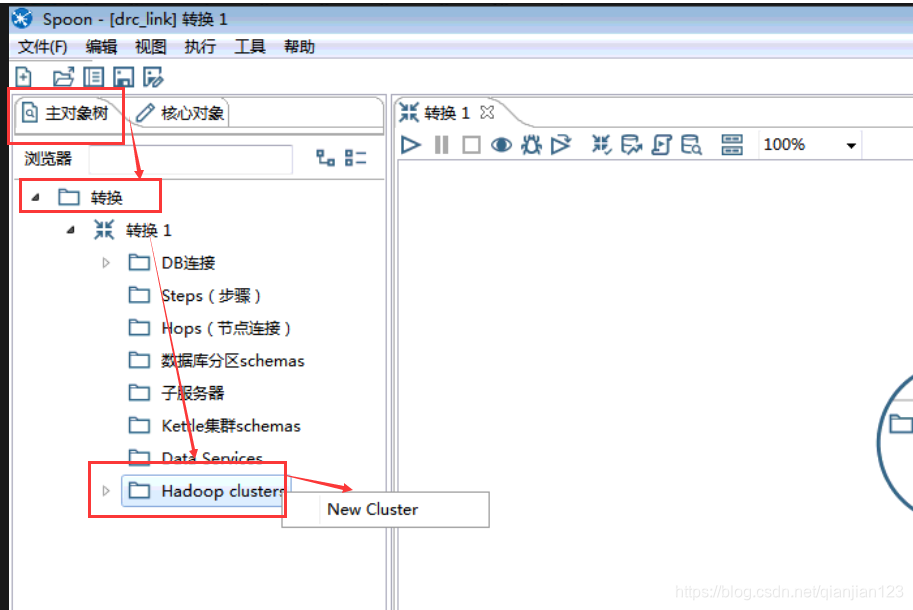

1.打开spoon可视化界面,新建一个转换。然后选择主对象树,新建一个cluster。如下图:

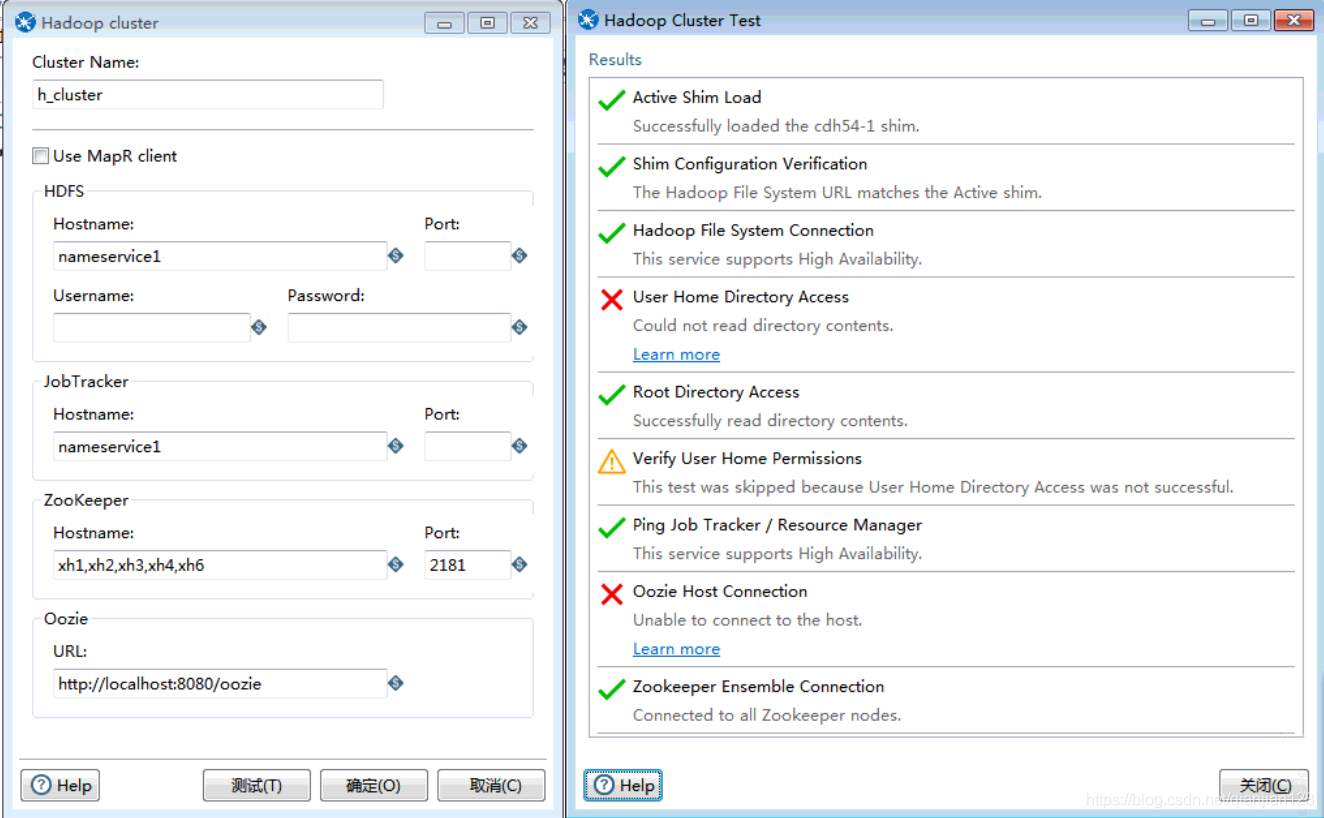

2.填写HADOOP的集群连接信息,点击【测试】。如下图:

之后的HBASE、hadoop file input/output插件使用,可以参考这篇博文:

https://blog.youkuaiyun.com/fzuzhanghao1993/article/details/78784877

注意项

1.Hadoop File Input插件使用时会出现文件没有权限创建的问题。

可参考这篇博文:https://www.cnblogs.com/sMKing/p/7221511.html

2.Hadoop File Input/output这两个插件要配置相关的字段映射,不然数据无法正常获取。

3. hbase input/output插件的hbase-site.xml文件路径务必加上“/”,不然无法正常连接hbase

如:

windows环境:

/D:\Backup\桌面\kio\hbase\hbase-site.xml

或者file:///D:\Backup\桌面\kio\hbase\hbase-site.xml

linux环境:

/home/***/hbase-site.xml

或者

file:///home/***/hbase-site.xml

因为插件源码中会判断路径是否是file://前缀,不是的话会进行补全。

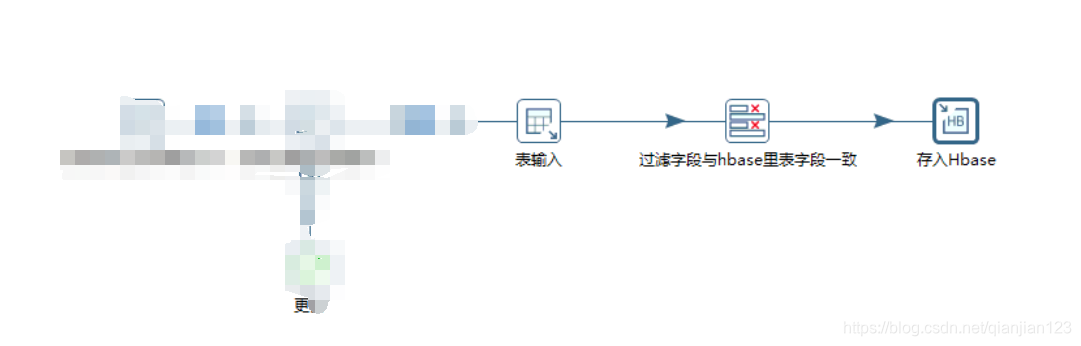

4. 上一步骤传来的数据插入hbase,字段数据量必须一致,不然会报错,如下图:

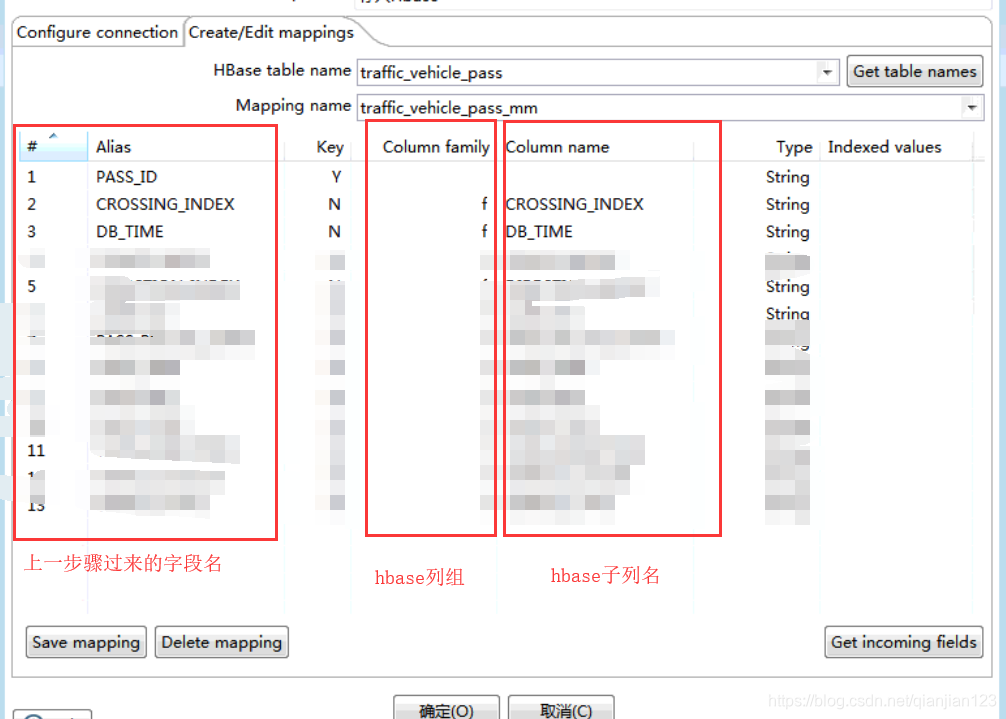

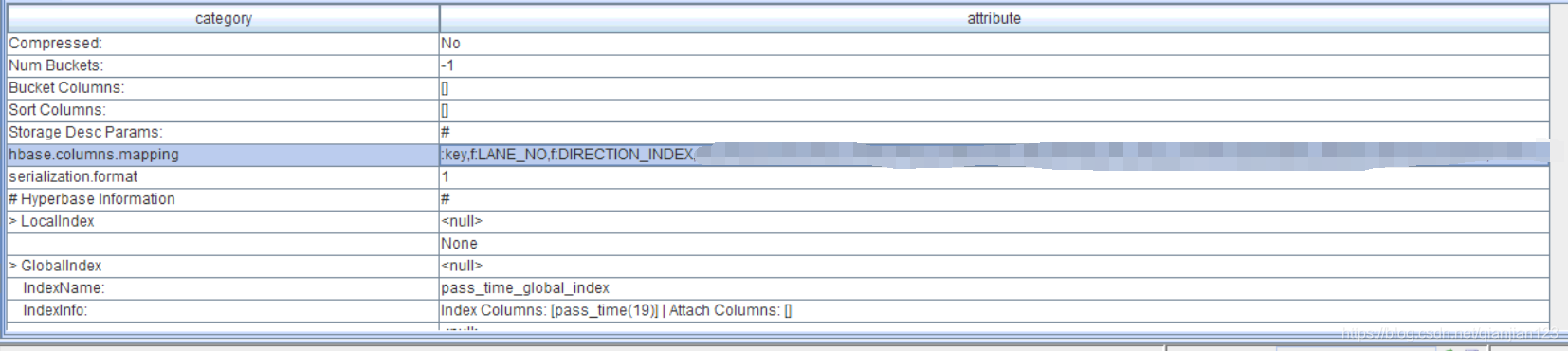

5、hbase字段映射说明,如下图

hbase表结构示例如下图:

本文介绍了在Windows环境下Kettle 6.0与Hadoop插件的配置和使用。首先说明了所需的Hadoop集群和Kettle 6.0环境,接着详细阐述了插件的配置步骤,包括复制配置文件、修改属性等。还介绍了插件的使用方法,最后列举了使用过程中的注意事项。

本文介绍了在Windows环境下Kettle 6.0与Hadoop插件的配置和使用。首先说明了所需的Hadoop集群和Kettle 6.0环境,接着详细阐述了插件的配置步骤,包括复制配置文件、修改属性等。还介绍了插件的使用方法,最后列举了使用过程中的注意事项。

1563

1563

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?