在信息爆炸时代,数据是企业和个人核心资产。从海量文档等中高效精准提取信息是痛点。传统关键词搜索面对复杂口语化查询常力不从心,无法理解用户深层意图,急需更智能、接近自然语言交互的解决方案。

当下普遍存在的几大痛点:

- 知识孤岛与检索困境:企业内部知识散落于 Confluence、SharePoint、本地文件夹等不同系统,成信息孤岛。员工(尤其新员工)找答案需在多平台切换,耗时低效。

- AI 技术应用门槛高:大语言模型为解决问题带来希望,但多数非 AI 专业开发者和中小企业,从零部署、微调、管理大模型并封装成应用,涉及复杂后端开发、算法知识、GPU 资源管理及高昂运维成本,几乎无法完成。

- 模型性能与成本博弈:用顶级模型官方 API 性能好,但规模化应用调用费用高;用开源模型自行部署,会遇技术门槛和运维困境。找到性能与成本平衡点是决策者难题。

- 应用僵化与定制难题:很多成品知识库软件功能固化,难依企业业务流程定制。如企业希望 AI 助手答题时调用内部 API 查询实时数据或执行特定操作,深度定制需求常难满足。

为解决痛点,本文以从零搭建专属《哈利·波特》全书知识问答系统这一实战案例,展示如何将低代码 AI 应用开发平台 Dify 与蓝耘 MaaS 平台完美结合,一站式构建满足个性化需求的 AI 智能助手。其方法论和技术栈可用于企业内部文档等任何领域。

1

Dify平台的云端快速部署

构建 AI 应用的第一步,是拥有一个稳定、可扩展的开发与运行环境。Dify 作为一个功能强大的 AI 应用编排平台,我们选择将其部署在云服务器上,以获得最佳的性能、稳定性和可访问性。

- 云服务器选型与 Dify 镜像的妙用

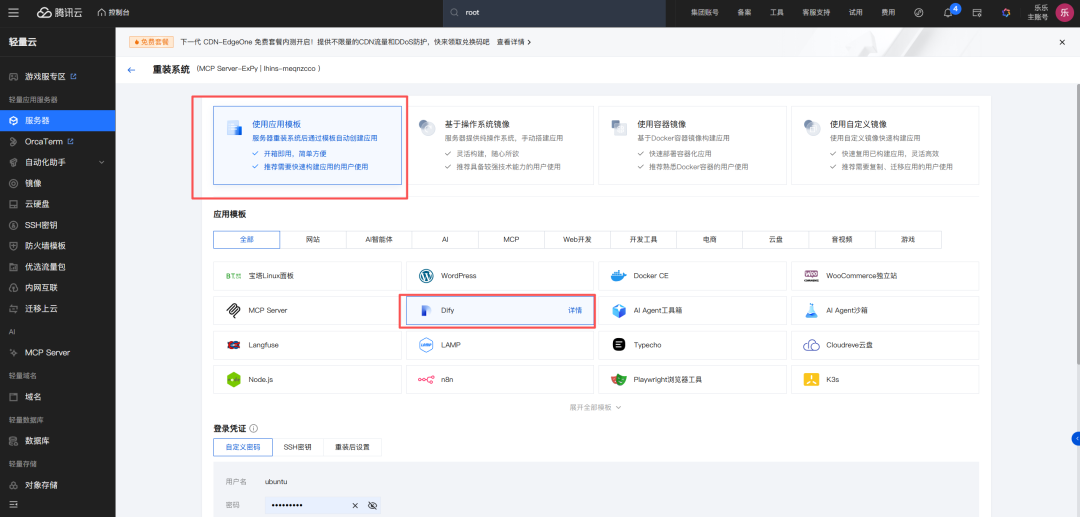

对于初学者而言,从零开始在服务器上配置 Dify 的运行环境(包括 Docker、数据库等)是一项繁琐且容易出错的工作。幸运的是,主流的云服务商(如本文演示所用的平台)通常会提供预装了常用应用的“镜像市场”。

我们直接在云服务器控制台进行重装或创建实例的操作,在选择操作系统镜像时,放弃传统的 CentOS 或 Ubuntu,直接在镜像市场中搜索并选择“Dify”。

选择预装 Dify 镜像的好处是显而易见的:它将 Dify 运行所需的所有软件、依赖库和基础配置都打包在了一起。你无需执行任何复杂的命令行操作,服务器实例创建完成后,一个“开箱即用”的 Dify 环境就已经为你准备好了。这大大降低了入门门槛,让你能将精力完全集中在 AI 应用的构建上。

- 访问 Dify 并完成初始化设置

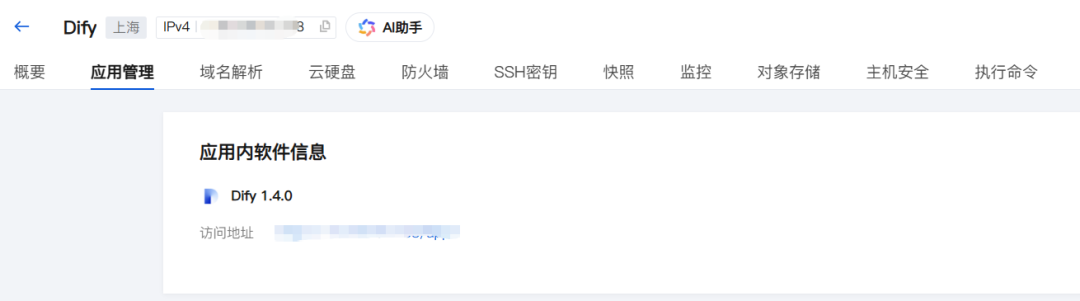

等待云服务器实例成功创建后,在服务器列表中点击进入该实例的详情页。

在实例详情页中,找到“应用管理”或类似的标签页。这里通常会展示预装应用的相关信息,最关键的就是 Dify 的后台访问地址。

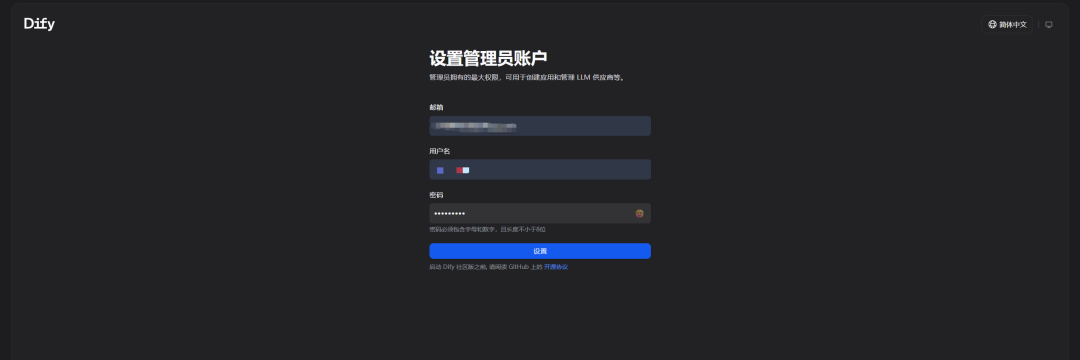

点击该访问地址,浏览器将带你进入 Dify 的初始化界面。首次访问时,系统会引导你创建一个管理员账户。请务必填写真实有效的邮箱,并设置一个安全的密码。这个账户将是你管理整个 Dify 平台、创建和维护所有 AI 应用的最高权限账户。

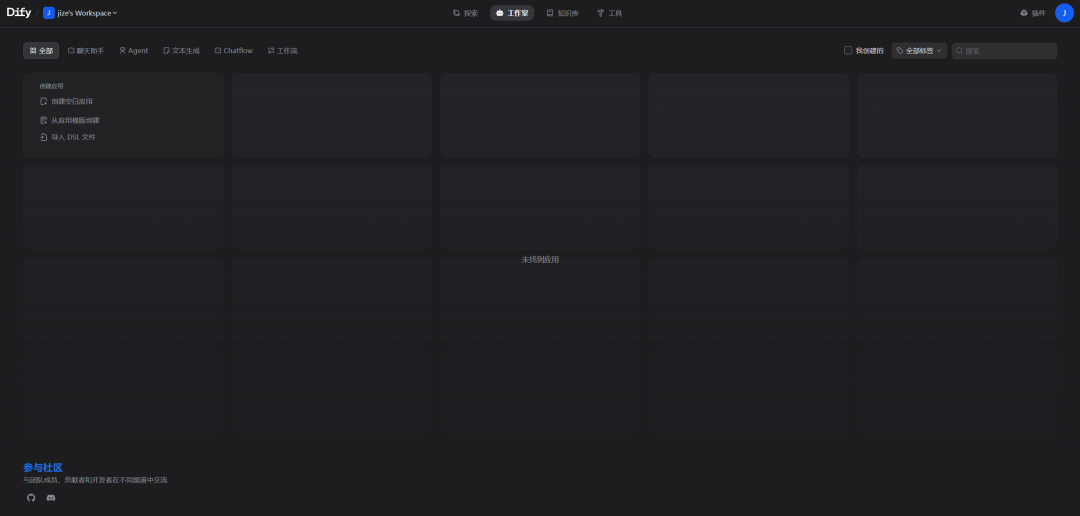

成功登录后,你将看到 Dify 的主界面。这是一个设计简洁且功能强大的工作台,你可以在这里开始探索和构建你的第一个 AI 应用了。

至此,我们的 AI 应用开发平台已经稳固地建立在云端,随时可以接入强大的语言模型,开始真正的创造之旅。

2

对接蓝耘 MaaS 平台的高性能大模型

Dify 似精密“大脑框架”,擅编排逻辑、管理数据和呈现交互,自然语言理解与生成的“思考”能力由大语言模型(LLM)提供。Dify 支持多模型供应商,我们选蓝耘 MaaS 平台作 AI 应用“动力引擎”。

选择蓝耘的核心原因在于其精准地解决了性能与成本的博弈难题:

- 极致的速度体验: 在问答、对话等交互式场景中,模型响应速度决定用户体验,等待数秒的机器人难以接受。蓝耘借助国内部署的优化推理集群和高效 API 网关,提供毫秒级接口响应速度,保障对话流畅自然。

- 卓越的成本效益:蓝耘用模型推理的批量处理和资源复用技术,大幅降低单个 API 请求成本。与官方按 Token 计费的高价相比,蓝耘定价更具竞争力,让大规模、高频次 AI 应用落地成为可能。

- 丰富的模型选择:蓝耘平台聚合 Kimi、文心一言、通义千问等多款业界领先大模型,可依应用场景需求(如长文本理解、代码生成、多语言支持等)灵活选最合适模型。

- 注册蓝耘并获取核心凭证:API-Key

首先,我们需要访问并注册蓝耘平台。

打开蓝耘平台进行注册操作。

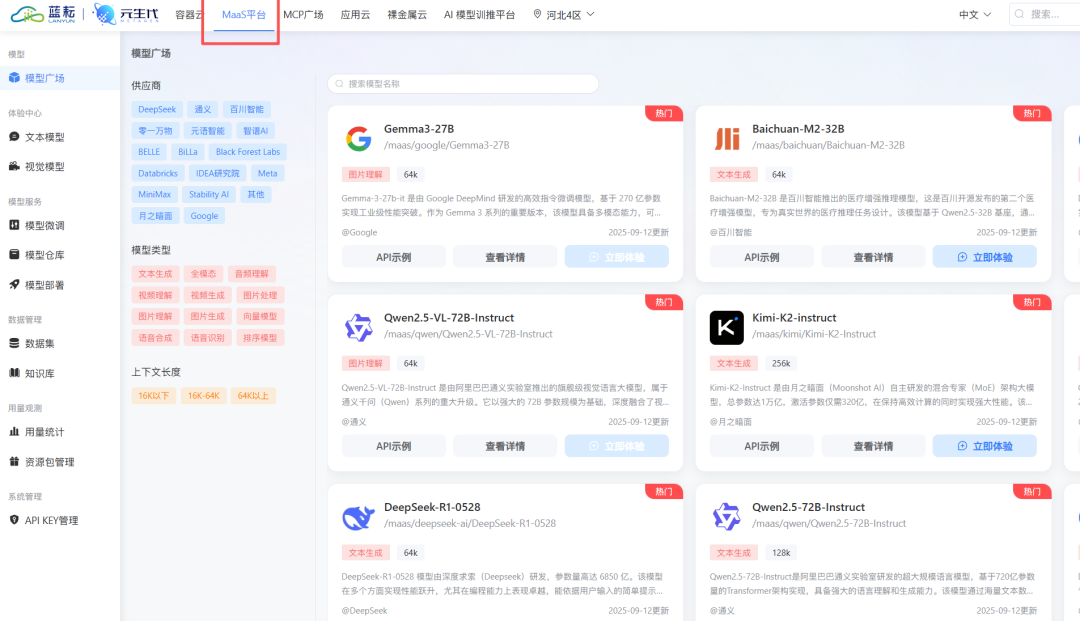

完成注册并登录后,在顶部导航栏找到“MaaS 平台”入口。在这里,你可以浏览平台支持的所有模型及其介绍。

在正式使用模型之前,我们需要创建一个 API-Key。这相当于一把访问蓝耘模型服务的“钥匙”,后续在 Dify 中的配置会用到。请妥善保管好你的 API-Key,不要泄露给他人。

- 在 Dify 中无缝集成蓝耘模型

现在,我们回到 Dify 的管理后台,将蓝耘的“动力引擎”安装进去。

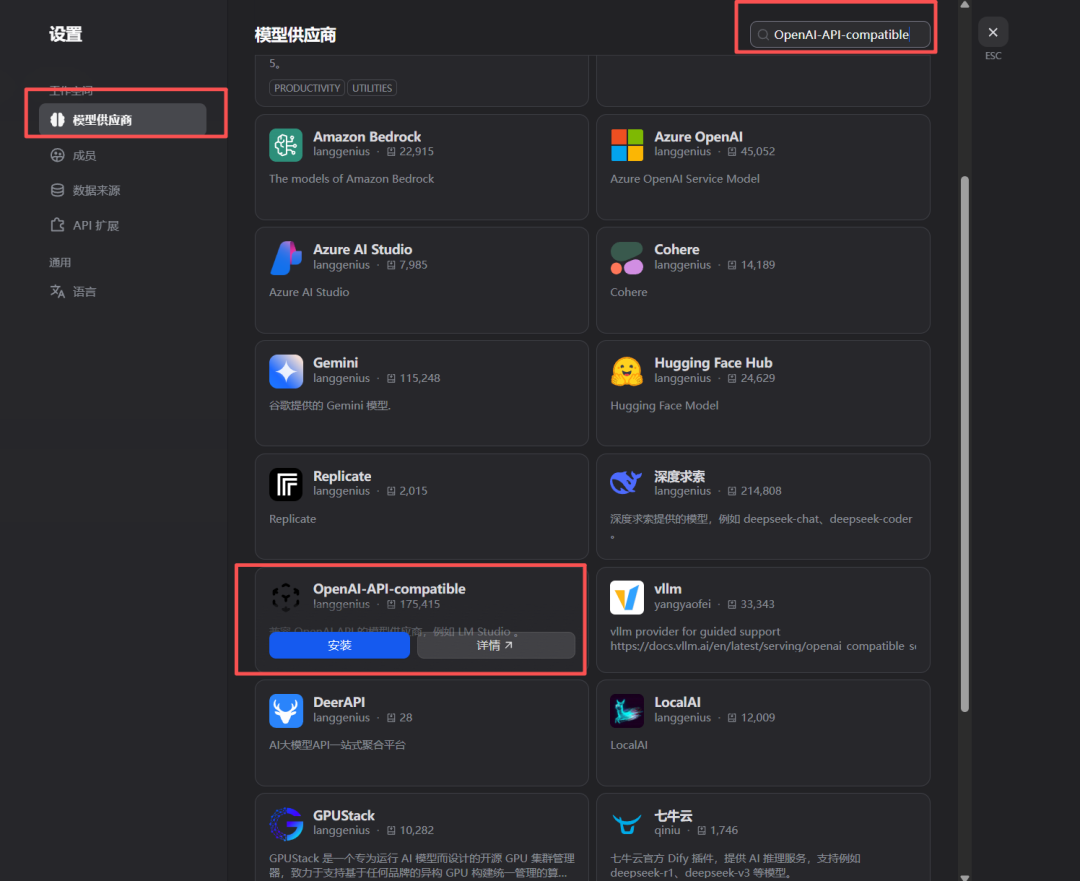

点击右上角的用户头像,在下拉菜单中选择“设置”。

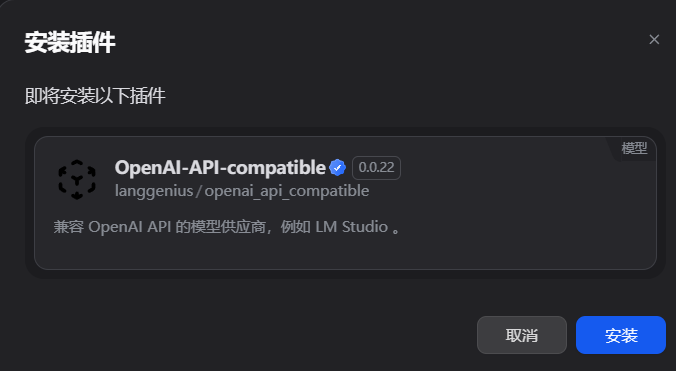

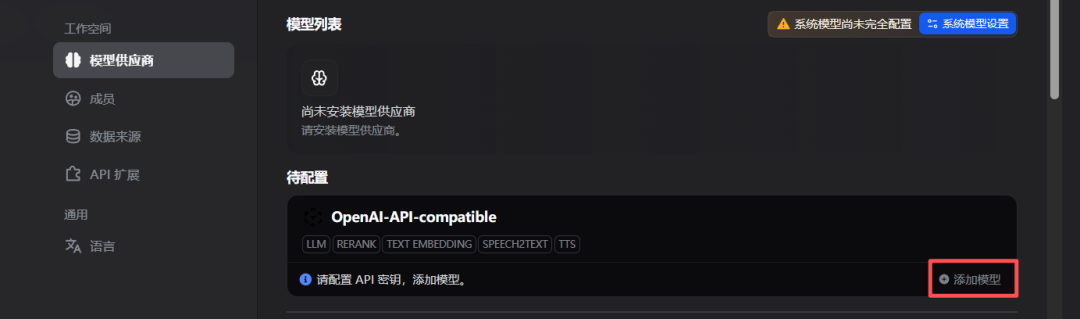

在设置菜单的左侧导航栏中,找到“模型供应商”。在正式添加蓝耘之前,我们需要先安装一个关键的插件,让 Dify 能够兼容类似 OpenAI API 格式的接口。点击“工具” -> “插件市场”,搜索并安装 OpenAI-API-compatible 插件。

插件安装成功后,回到“模型供应商”页面,点击“添加模型”。

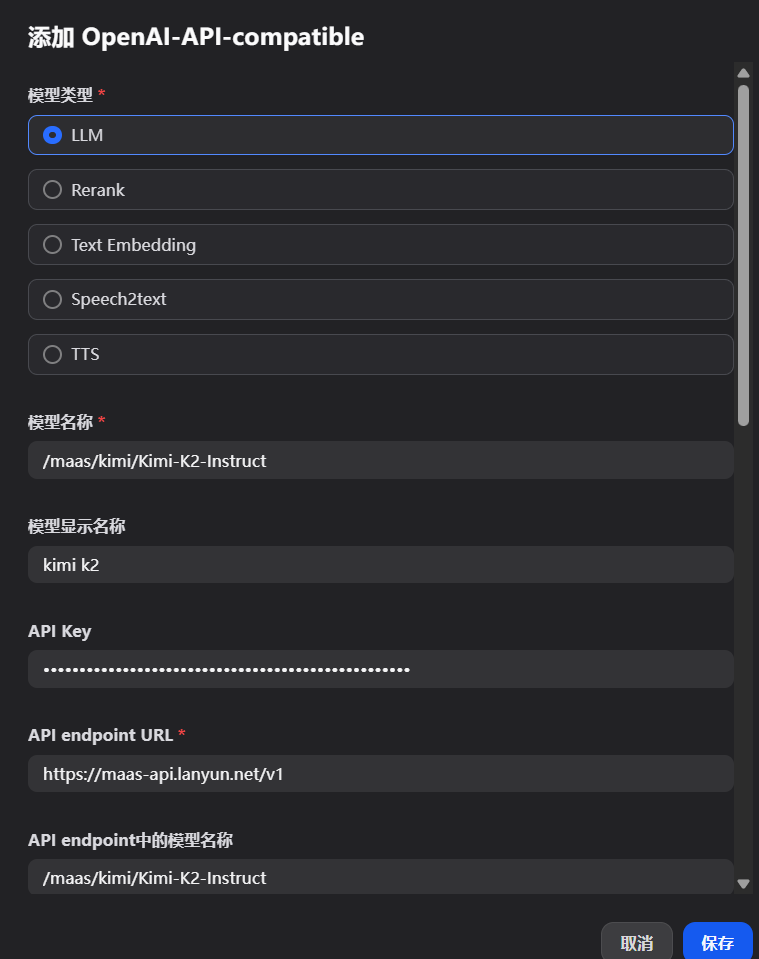

在弹出的配置窗口中,选择我们刚刚安装的 OpenAI-API-compatible 插件,然后填写以下关键信息:

- API Base URL: 这是蓝耘 MaaS 平台的 API 服务地址,统一填写 https://maas-api.lanyun.net/v1。

- API Key: 将你刚刚从蓝耘平台创建并复制的 API-Key 粘贴到这里。

- 模型名称: 为这个模型起一个自定义的、易于识别的名字,比如 lanyun-kimi-k2,方便后续在构建应用时选择。

- 模型 ID: 填写你希望使用的具体模型的标识符,这个标识符可以在蓝耘 MaaS 平台的模型列表中找到。例如,我们要使用 Kimi K2 Instruct 模型,就填写 /maas/kimi/Kimi-K2-Instruct。

填写完成后的效果如下图所示:

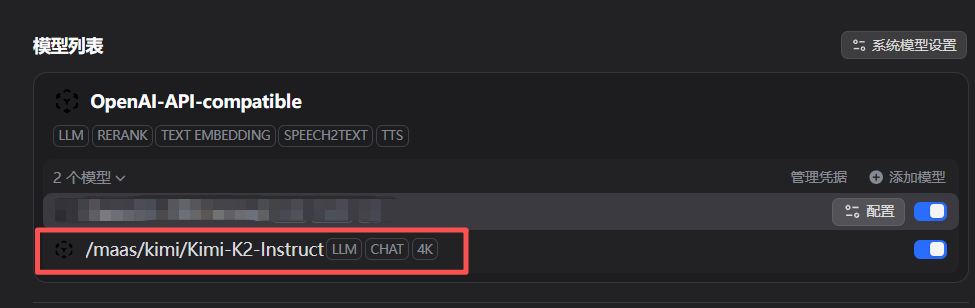

点击保存,蓝耘提供的 Kimi K2 模型就成功添加到了 Dify 的模型库中。

现在,我们的 Dify 平台不仅有了“大脑框架”,更拥有了一颗由蓝耘提供的、跳动强劲的“心脏”。

3

构建知识核心

有平台和模型后,要为 AI 注入“知识”。Dify 的知识库功能是核心亮点,应用先进的 RAG (Retrieval-Augmented Generation) 技术,能智能处理上传文档,转为大模型可理解和检索的格式。

- 创建知识库并上传原始资料

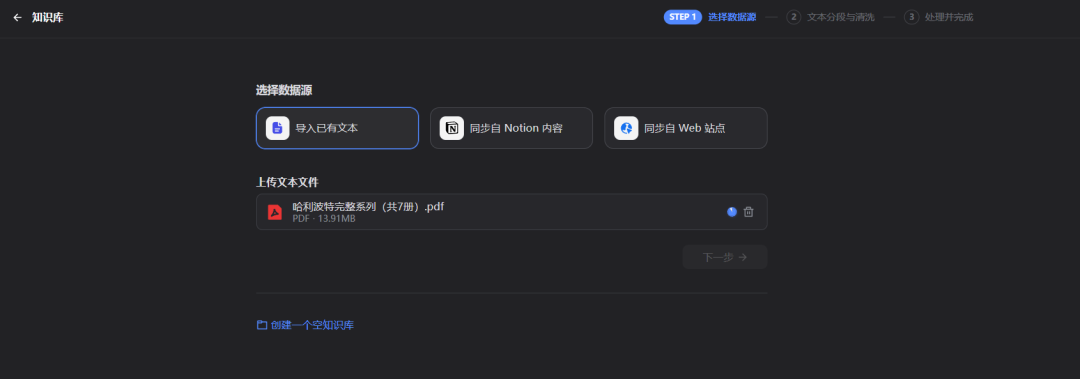

在 Dify 的主界面,点击左侧的“知识库”图标,然后点击“创建知识库”。我们将创建一个名为“哈利波特全书”的知识库。

接着,我们上传《哈利·波特》全套的原著文本文件。Dify 支持多种文件格式,包括 txt, pdf, docx 等。

- 理解背后的技术:文本清洗、分段与索引

文件上传后,Dify 会引导你进行一系列的文本处理设置。这一步至关重要,直接影响到最终问答的准确性。

- 文本清洗: 自动去除文档中无关的页眉、页脚、多余的空行和特殊字符,保证输入给模型的文本是干净、高质量的。

- 分段与切块 (Segmentation & Chunking):大语言模型“上下文窗口”有限。因此,Dify 需将长篇文档(如整本书)切成有意义小段落(Chunk)。可自动或自定义分段。合理切块大小,既能保证段落含足够上下文信息,又不超模型处理极限。

- 向量化与索引 (Embedding & Indexing): 这是 RAG 技术核心。Dify 用“嵌入模型”将每个文本块转为“向量”,可视为文本块在多维空间的“语义坐标”,所有文本向量存于“向量数据库”。用户提问时,Dify 把问题转成向量,在数据库快速找到“语义最接近”的几个文本块向量,作为上下文信息供大模型生成答案 。

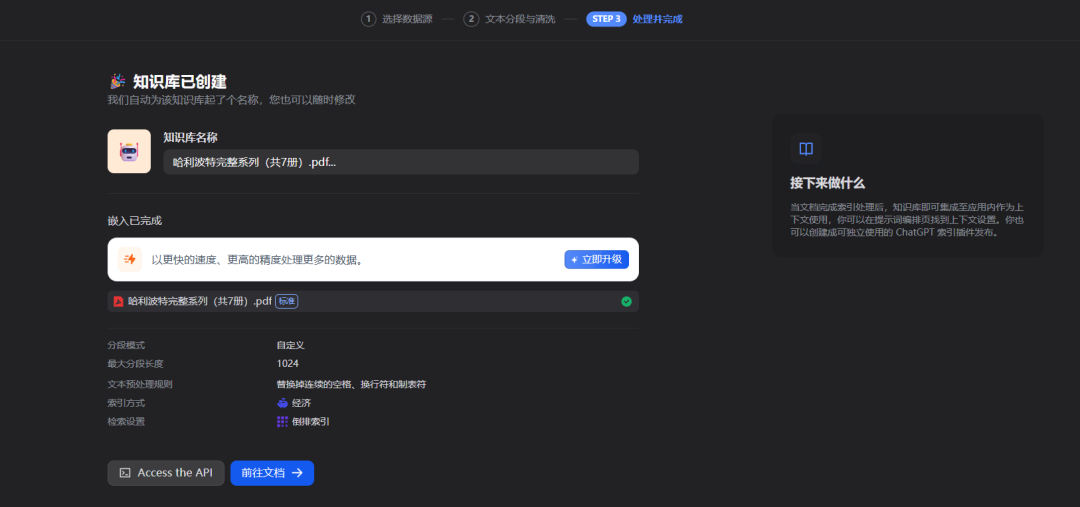

整个过程是全自动的,你只需根据引导完成设置。处理完成后,知识库的状态会显示为“可用”。

现在,我们已经将《哈利·波特》全书的知识,高效地“喂”给了我们的 AI 系统。

4

编排智能流程

知识库准备就绪,模型也已接入,现在我们需要将它们串联起来,设计一个完整的工作流程 (Workflow),告诉 AI 在收到用户问题后,应该如何一步步地思考和行动。

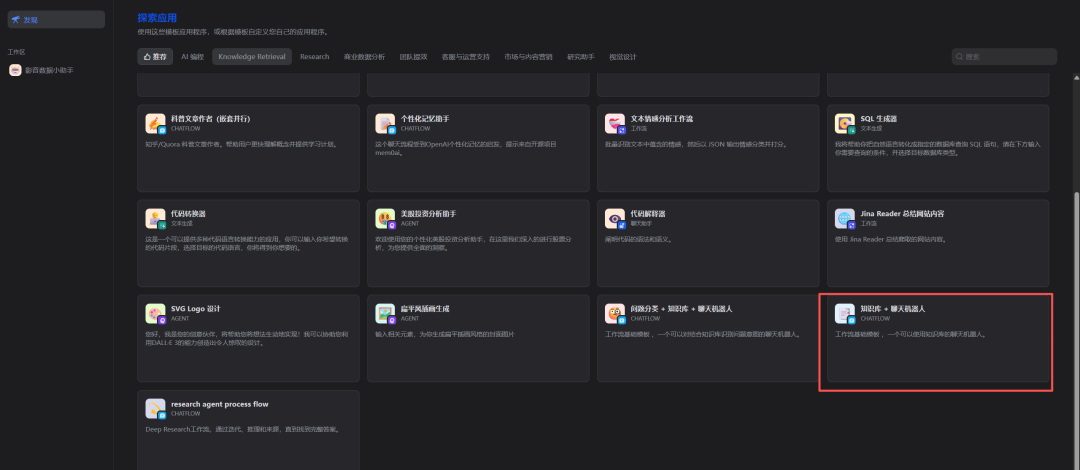

- 选择工作流模板

回到 Dify 主页,点击“创建应用”,选择“聊天机器人”类型。Dify 提供了多种预设的应用模板,我们直接选择“知识库+聊天机器人”这个最经典的模板。

进入应用后,点击左侧的“编排”标签,你将看到一个可视化的工作流画布。

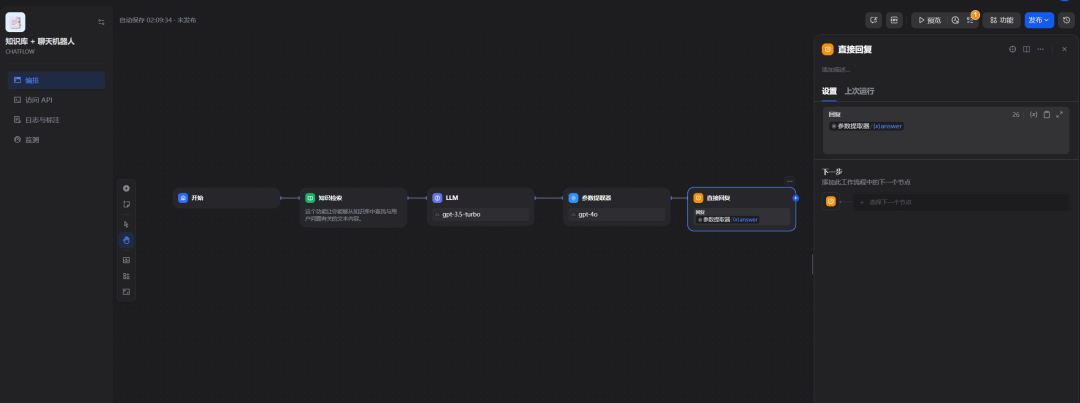

这个画布上已经预设了几个关键节点,代表了 AI 处理问题的标准流程:

- 开始: 接收用户的输入。

- 知识检索: 从知识库中查找与用户问题相关的信息。

- LLM (大语言模型): 将用户问题和检索到的知识整合起来,生成最终答案。

- 回复: 将生成的答案返回给用户。

- 配置关键节点

我们的任务就是对这些节点进行配置,将我们之前创建的资源关联进来。

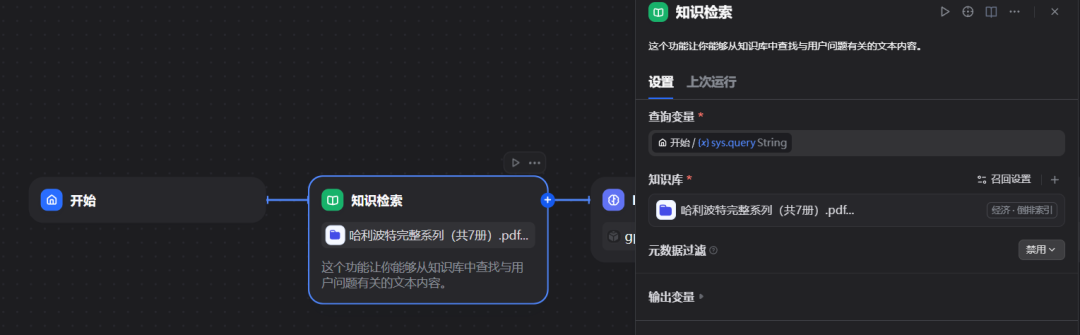

配置知识检索节点: 点击“知识检索”节点,在右侧的配置面板中,将“知识库”选项设置为我们刚刚创建的“哈利波特全书”。

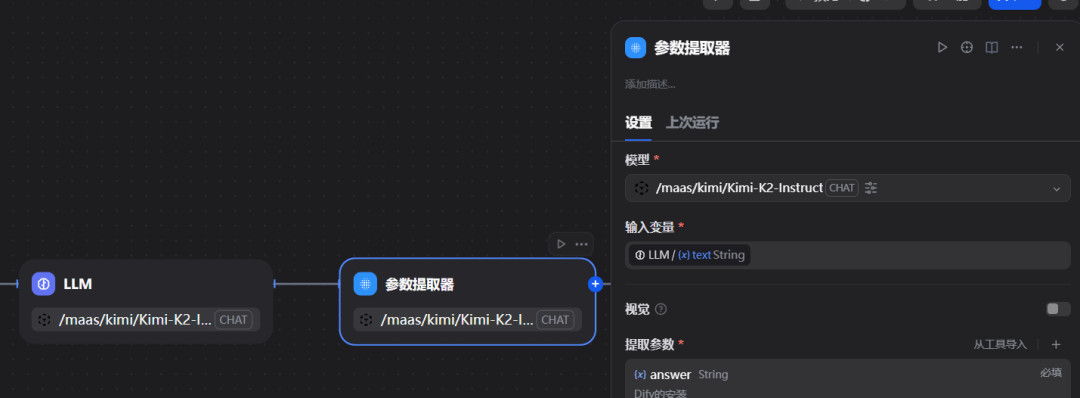

配置 LLM 节点: 点击“LLM”节点(在模板中可能还有“参数提取器”等也需要配置),在模型选择下拉框中,选择我们之前配置好的 lanyun-kimi-k2 模型。

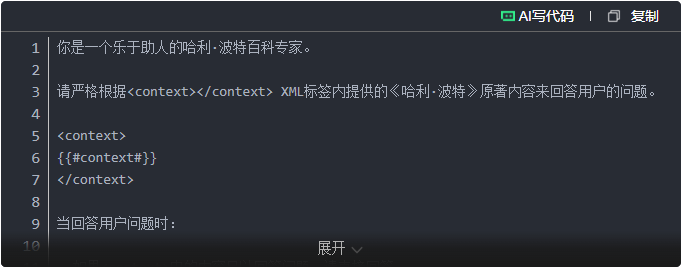

精调 Prompt (提示词):在 LLM 节点配置中,最重要的是 Prompt。它是给 AI 的“指令”,告知其扮演的角色及如何运用我们提供的知识。模板已有不错的 Prompt,可在此基础上微调:

这里的 {{#context#}} 是一个占位符,Dify 在实际运行时,会自动将从知识库中检索到的相关文本块填充到这里。

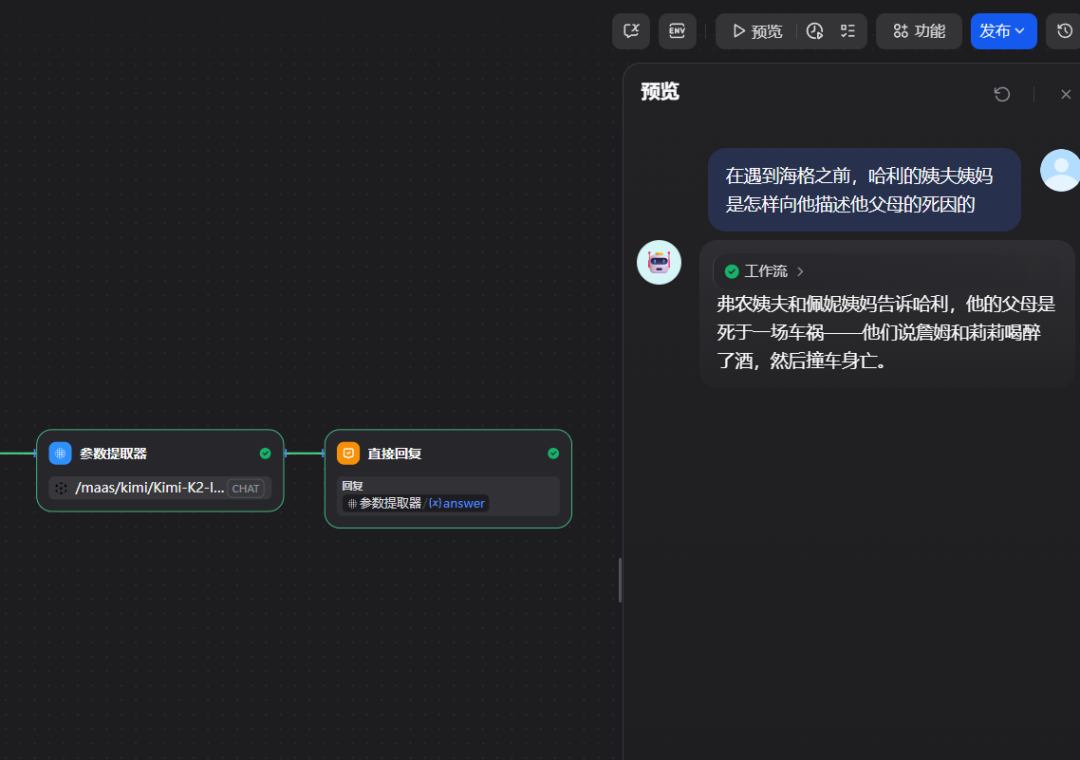

- 调试与发布

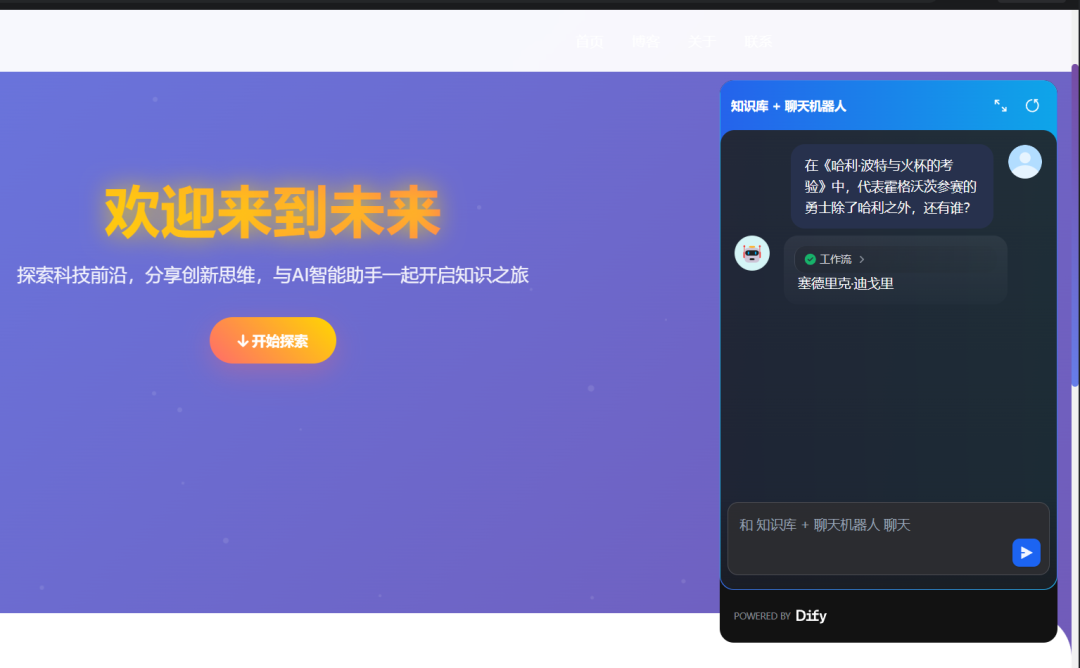

配置完成后,可以直接在画布的右侧进行实时调试。输入一个关于哈利·波特的问题,例如“赫敏的守护神是什么?”,然后点击“运行”。

你可以看到工作流的每个节点都按顺序执行,并最终在“回复”节点输出了正确的答案:“水獭”。测试效果满意后,点击右上角的“发布”按钮,我们的 AI 问答机器人就正式上线了!

5

将AI 助手嵌入任何网站

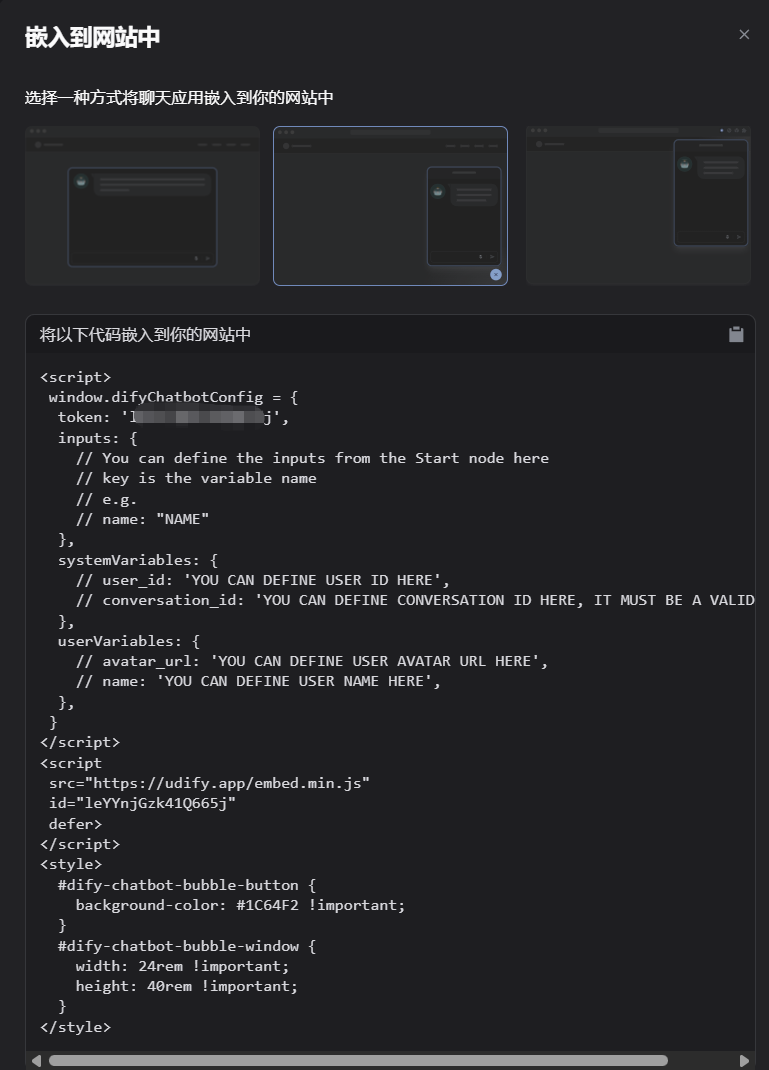

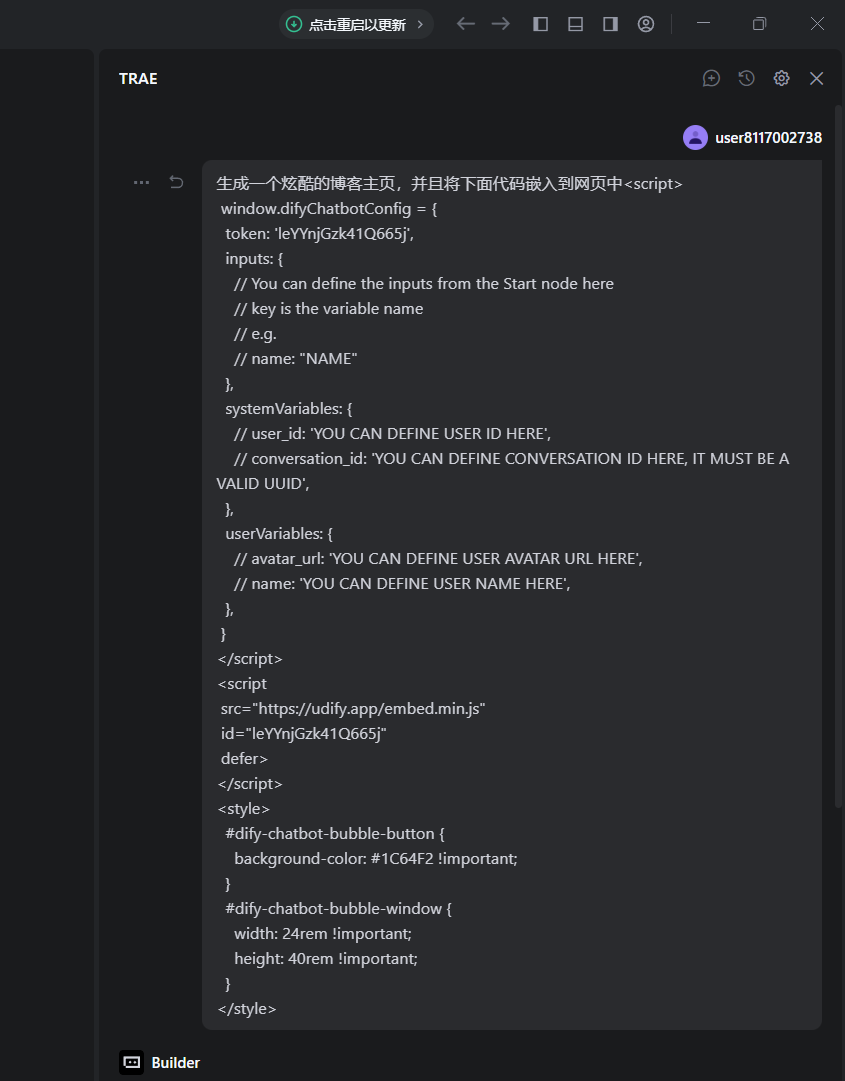

应用发布后,Dify 提供了多种集成方式,其中最便捷的就是“嵌入网站”。

- 获取嵌入代码

在应用概览页面,找到并点击“嵌入网站”选项。

Dify 提供了几种嵌入样式,我们选择中间的“气泡式”聊天机器人。这会在网站的右下角生成一个可点击的聊天图标。

Dify 会自动生成一段 HTML 和 JavaScript 代码。这段代码就是连接你的网站和 AI 助手的桥梁。

- 在你的网站中嵌入代码

接下来,我们创建一个简单的博客网页(或在任何你已有的网站项目中),将上面生成的代码片段粘贴到网页的 标签结束之前。

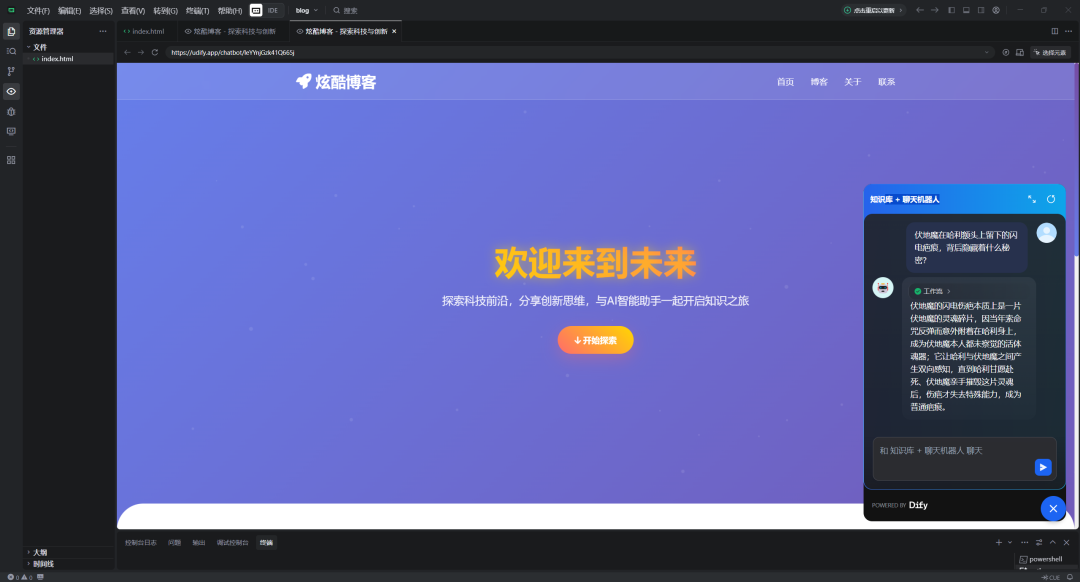

- 本地测试与最终效果

为了在本地预览效果,我们可以使用 Python 启动一个简单的 Web 服务器。在你的网页文件所在的目录下,打开终端或命令行,输入以下命令:

然后打开浏览器,访问 http://localhost:8000。你将看到你的网页,并且在右下角出现了一个 Dify 聊天图标。

点击图标,一个精美的聊天窗口就会弹出。现在,任何访问你网站的用户都可以与你的哈利·波特专家进行实时问答了!

Dify 将构建 AI 应用的复杂组件封装成可视化界面,让产品经理等有创意者能快速将想法落地为 AI 应用,实现 AI“平民化”。

蓝耘解决 AI 应用核心“动力”问题,其高速 API 响应保障用户体验,成本控制是 AI 应用推广关键,让开发者无后顾之忧调用顶尖大模型能力,专注业务逻辑与创新。

“Dify + 蓝耘”应用场景广泛:企业内部导入资料打造“超级员工”提升运营效率;客户服务构建知识库形成智能客服,解决多数重复性咨询;教育培训打造课程学习助教随时答疑;个人知识管理整合资料构建“第二大脑”快速回顾关联知识。

技术进步拆除创新壁垒,蓝耘与 Dify 让构建强大实用 AI 应用不再是巨头专利,轮到你思考如何利用它们解决问题、创造价值。

想入门 AI 大模型却找不到清晰方向?备考大厂 AI 岗还在四处搜集零散资料?别再浪费时间啦!2025 年 AI 大模型全套学习资料已整理完毕,从学习路线到面试真题,从工具教程到行业报告,一站式覆盖你的所有需求,现在全部免费分享!

👇👇扫码免费领取全部内容👇👇

一、学习必备:100+本大模型电子书+26 份行业报告 + 600+ 套技术PPT,帮你看透 AI 趋势

想了解大模型的行业动态、商业落地案例?大模型电子书?这份资料帮你站在 “行业高度” 学 AI:

1. 100+本大模型方向电子书

2. 26 份行业研究报告:覆盖多领域实践与趋势

报告包含阿里、DeepSeek 等权威机构发布的核心内容,涵盖:

- 职业趋势:《AI + 职业趋势报告》《中国 AI 人才粮仓模型解析》;

- 商业落地:《生成式 AI 商业落地白皮书》《AI Agent 应用落地技术白皮书》;

- 领域细分:《AGI 在金融领域的应用报告》《AI GC 实践案例集》;

- 行业监测:《2024 年中国大模型季度监测报告》《2025 年中国技术市场发展趋势》。

3. 600+套技术大会 PPT:听行业大咖讲实战

PPT 整理自 2024-2025 年热门技术大会,包含百度、腾讯、字节等企业的一线实践:

- 安全方向:《端侧大模型的安全建设》《大模型驱动安全升级(腾讯代码安全实践)》;

- 产品与创新:《大模型产品如何创新与创收》《AI 时代的新范式:构建 AI 产品》;

- 多模态与 Agent:《Step-Video 开源模型(视频生成进展)》《Agentic RAG 的现在与未来》;

- 工程落地:《从原型到生产:AgentOps 加速字节 AI 应用落地》《智能代码助手 CodeFuse 的架构设计》。

二、求职必看:大厂 AI 岗面试 “弹药库”,300 + 真题 + 107 道面经直接抱走

想冲字节、腾讯、阿里、蔚来等大厂 AI 岗?这份面试资料帮你提前 “押题”,拒绝临场慌!

1. 107 道大厂面经:覆盖 Prompt、RAG、大模型应用工程师等热门岗位

面经整理自 2021-2025 年真实面试场景,包含 TPlink、字节、腾讯、蔚来、虾皮、中兴、科大讯飞、京东等企业的高频考题,每道题都附带思路解析:

2. 102 道 AI 大模型真题:直击大模型核心考点

针对大模型专属考题,从概念到实践全面覆盖,帮你理清底层逻辑:

3. 97 道 LLMs 真题:聚焦大型语言模型高频问题

专门拆解 LLMs 的核心痛点与解决方案,比如让很多人头疼的 “复读机问题”:

三、路线必明: AI 大模型学习路线图,1 张图理清核心内容

刚接触 AI 大模型,不知道该从哪学起?这份「AI大模型 学习路线图」直接帮你划重点,不用再盲目摸索!

路线图涵盖 5 大核心板块,从基础到进阶层层递进:一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:了解大模型的基础知识,以及大模型在各个行业的应用和分析,学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段:AI大模型RAG应用开发工程,主要学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,主要学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调,并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

四、资料领取:全套内容免费抱走,学 AI 不用再找第二份

不管你是 0 基础想入门 AI 大模型,还是有基础想冲刺大厂、了解行业趋势,这份资料都能满足你!

现在只需按照提示操作,就能免费领取:

👇👇扫码免费领取全部内容👇👇

2025 年想抓住 AI 大模型的风口?别犹豫,这份免费资料就是你的 “起跑线”!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?