还记得ChatGPT刚火那会儿,朋友圈满屏都是"我和AI的对话截图"。可最近,越来越多开发者开始担心:我的敏感数据会不会被云端大模型"偷窥"?企业级应用如何在享受AI红利的同时,确保数据安全?

答案很简单:本地化部署。

今天就带你用SpringAI+Ollama+Qwen:7b

30分钟搭建一套完全私有的智能聊天系统!

核心实现步骤

一、环境准备

(1) 本地Ollama环境,下载本地Qwen大模型

轻松掌握 AI 大模型!Windows 新突破:Ollama 赋能本地部署

(2) SpringAI代码集成

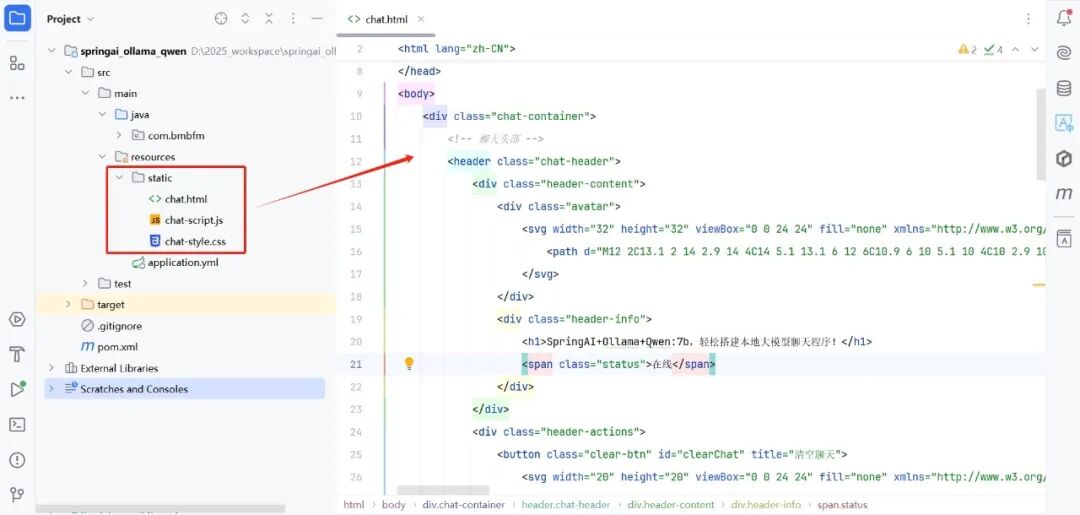

(3) 前端页面代码

二、SpringAI对接Ollama的千问大模型

(1) 引入依赖 pom.xml

<!-- ollama依赖 -->

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-starter-model-ollama</artifactId>

</dependency>

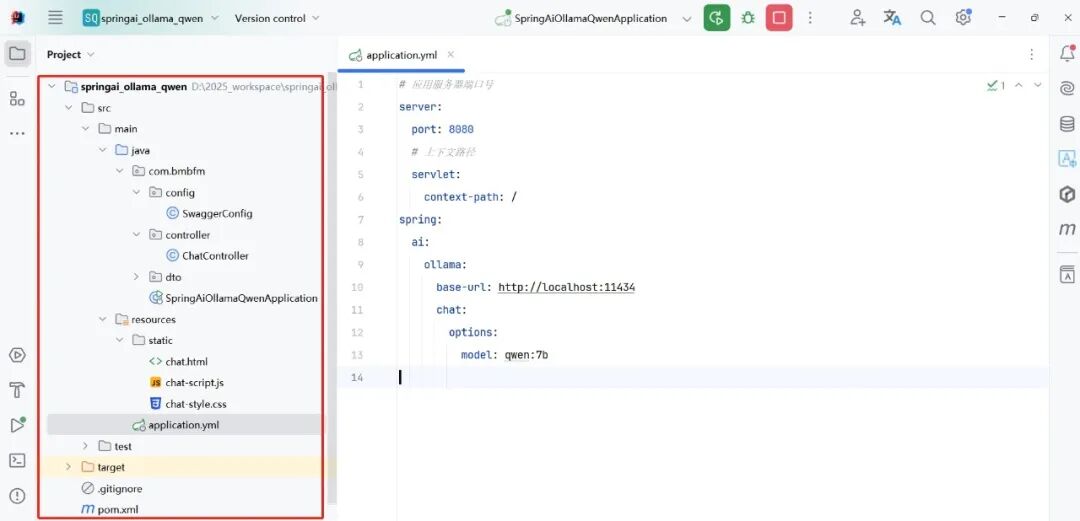

(2) 配置对接Qwen本地大模型 application.yml

# 应用服务器端口号

server:

port: 8080

# 上下文路径

servlet:

context-path: /

spring:

ai:

ollama:

base-url: http://localhost:11434

chat:

options:

model: qwen:7b

三、后端聊天业务代码实现

package com.bmbfm.controller;

import com.bmbfm.dto.ReqParamDTO;

import io.swagger.v3.oas.annotations.Operation;

import org.springframework.ai.chat.model.ChatModel;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.*;

import reactor.core.publisher.Flux;

@RestController

public class ChatController {

@Autowired

private ChatModel chatModel;

@PostMapping("/chat/v1")

@Operation(summary = "聊天流式调用")

public Flux<String> clientAIChat(@RequestBody ReqParamDTO reqParamDTO) {

Flux<String> stream = chatModel.stream(reqParamDTO.getMessage());

return stream;

}

}

四、演示效果

AI正在重塑软件架构。从云端集中式服务,到边缘计算分布式部署,技术演进的背后是对效率、安全、成本的多维优化。

SpringAI+Ollama+Qwen这套组合,为Java开发者提供了拥抱AI浪潮的最佳实践路径。不只是写代码,更是在思考如何用技术创造真正的商业价值。

👇****点击下方进入卡片

如果本文章能给你一点启发,感谢点个赞、在看、转发三连,如果想第一时间收到推送,请点上星标⭐关注公众号。

大模型算是目前当之无愧最火的一个方向了,算是新时代的风口!有小伙伴觉得,作为新领域、新方向人才需求必然相当大,与之相应的人才缺乏、人才竞争自然也会更少,那转行去做大模型是不是一个更好的选择呢?是不是更好就业呢?是不是就暂时能抵抗35岁中年危机呢?

答案当然是这样,大模型必然是新风口!

那如何学习大模型 ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。但是具体到个人,只能说是:

最先掌握AI的人,将会比较晚掌握AI的人有竞争优势。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

但现在很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习路线完善出来!

在这个版本当中:

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型路线+学习教程已经给大家整理并打包分享出来, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:了解大模型的基础知识,以及大模型在各个行业的应用和分析,学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段:AI大模型RAG应用开发工程,主要学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,主要学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调,并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

9522

9522

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?