“AI 大模型太卷了,我每天用 DeepSeek 却不知道怎么在面试里答题。”

“明明刷了很多题,可一到面试就慌得要死。”

——这是我最近听到最多的两句话。

如果你是正在准备秋招同学,或者是一位想转型大模型方向的工程师,下面这些内容,可能会让你少走很多弯路。

😖 面试到底靠“运气”还是靠“玄学”?

在这个技术快速迭代的时代,尤其是大模型领域,许多面试者会有一种强烈的挫败感:

- 面试官一张口就是“MoE调度策略和稀疏激活”,瞬间大脑放空。

- 明明自己在公司天天用大模型 API,结果一句“请你讲讲 RLHF 的实现细节”直接答不出来。

- ChatGPT、DeepSeek、Kimi 用得顺手,但到了面试,不知道怎么从“用”切换到“懂”。

问题不是你不会,是你没准备对。

📘 100道高频真题,击穿面试玄学——《百面大模型》

这就是我为什么要推荐这本书:《百面大模型》。

本书已经整理并打包成PDF了,扫描即可拿到这本书

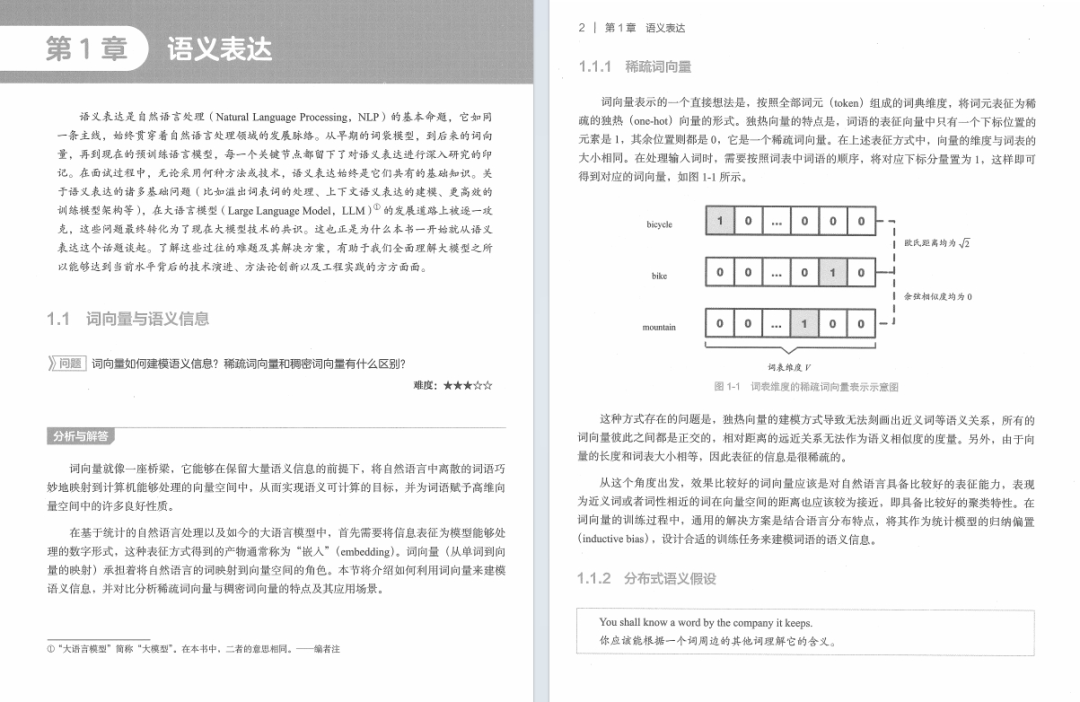

本书收录了约百道大模型工程师常见的面试题目和解答,系统、全面地介绍了与大模型相关的技术,涵盖语义表达、数据预处理、预训练、对齐、垂类微调、组件、评估、架构、检索增强生成(RAG)、智能体、PEFT(参数高效微调),以及训练与推理等内容。

书中通过丰富的实例、图表及代码讲解,将复杂概念阐释得通俗易懂,是大模型领域的一本不可多得的实用指南。本书适合对大模型和Transformer等技术感兴趣的学生、研究者和工程师阅读和参考。

作者简介

包梦蛟,北京航空航天大学硕士,美团北斗计划高级算法专家,负责大众点评大模型应用落地开发,曾获得Kaggle Grandmaster称号、KDD CUP 2024冠军,业余时间撰写知乎专栏和公众号“包包算法笔记”,全网关注数5万+。

刘如日,北京航空航天大学硕士,研究兴趣为机器学习与自然语言处理。曾以第一作者身份发表顶会论文并多次在顶会竞赛中取得冠军等优异成绩。现于美团从事大模型相关技术研究与产业应用。

朱俊达,北京航空航天大学硕士,研究兴趣为大模型架构优化方向,有多家大厂实习经历,发表了多篇大模型相关论文。

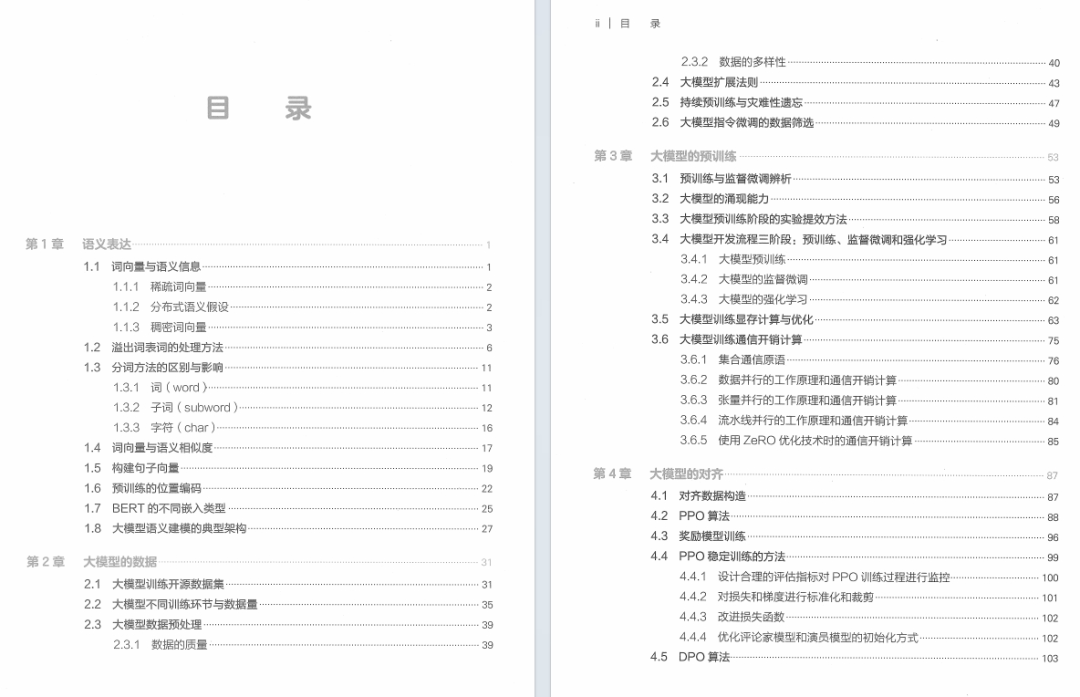

目录

第 1章 语义表达 1

- 1.1 词向量与语义信息 1

- 1.2 溢出词表词的处理方法 6

- 1.3 分词方法的区别与影响 11

- 1.4 词向量与语义相似度 17

- 1.5 构建句子向量 19

- 1.6 预训练的位置编码 22

- 1.7 BERT的不同嵌入类型 25

- 1.8 大模型语义建模的典型架构 27

第 2章 大模型的数据 31

- 2.1 大模型训练开源数据集 31

- 2.2 大模型不同训练环节与数据量 35

- 2.3 大模型数据预处理 39

- 2.4 大模型扩展法则 43

- 2.5 持续预训练与灾难性遗忘 47

- 2.6 大模型指令微调的数据筛选 49

第3章 大模型的预训练 53

- 3.1 预训练与监督微调辨析 53

- 3.2 大模型的涌现能力 56

- 3.3 大模型预训练阶段的实验提效方法 58

- 3.4 大模型开发流程三阶段:预训练、监督微调和强化学习 61

- 3.5 大模型训练显存计算与优化 63

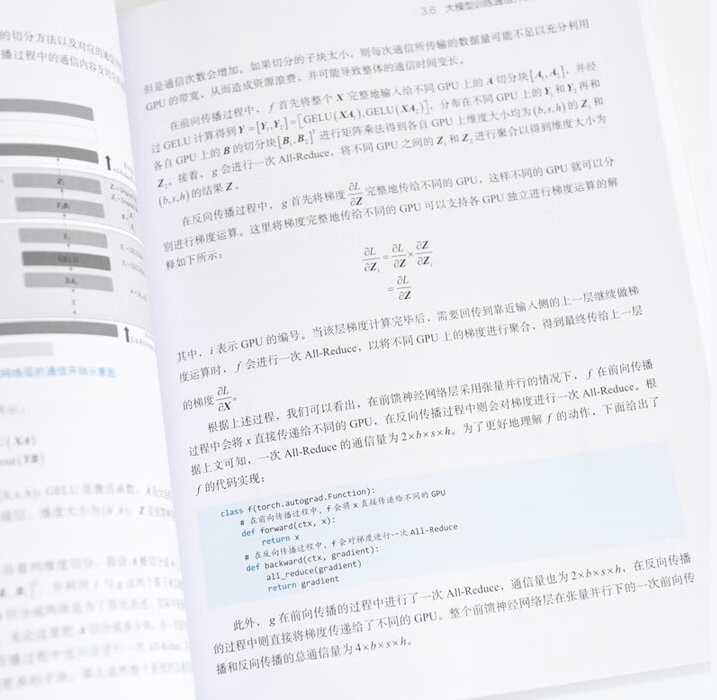

- 3.6 大模型训练通信开销计算 75

第4章 大模型的对齐 87

- 4.1 对齐数据构造 87

- 4.2 PPO算法 88

- 4.3 奖励模型训练 96

- 4.4 PPO稳定训练的方法 99

- 4.5 DPO算法 103

- 4.6 DPO与PPO辨析 105

- 4.7 其他偏好对齐方法综述 108

- 4.8 对齐训练稳定性监测 119

- 4.9 大模型后训练环节辨析 122

第5章 大模型的垂类微调 124

- 5.1 (垂类)监督微调 124

- 5.2 后训练的词表扩充 128

- 5.3 有效的长度外推方法 130

- 5.4 大模型微调的损失函数 140

- 5.5 大模型知识注入方法 144

第6章 大模型的组件 147

- 6.1 Transformer的架构 147

- 6.2 注意力分数计算细节 153

- 6.3 词元化算法的区别与特点 156

- 6.4 RoPE 160

- 6.5 ALiBi 165

- 6.6 Sparse Attention 169

- 6.7 Linear Attention 173

- 6.8 多头注意力机制及其优化(MHA、MQA 和GQA) 175

- 6.9 各种归一化方法 181

- 6.10 归一化模块位置的影响——PostNorm和PreNorm 184

- 6.11 Dropout机制 187

- 6.12 模型训练参数初始化方法概述 190

第7章 大模型的评估 194

- 7.1 大模型的评测榜单与内容 194

- 7.2 大模型评测的原则 199

- 7.3 大模型的修复方法 200

- 7.4 生成式模型的评测指标 203

- 7.5 大模型的自动化评估 209

- 7.6 大模型的对抗性测试 211

- 7.7 大模型的备案流程 212

第8章 大模型的架构 217

- 8.1 因果解码器架构成为主流的原因 217

- 8.2 大模型的集成融合方法 220

- 8.3 MoE 226

第9章 检索增强生成 233

- 9.1 RAG的组成与评估 233

- 9.2 RAG中的召回方法 237

- 9.3 RAG与重排 241

- 9.4 RAG的工程化问题 244

第 10章 大模型智能体 248

- 10.1 智能体的组成 248

- 10.2 智能体的规划能力 251

- 10.3 智能体的记忆模块 255

- 10.4 智能体的工具调用 257

- 10.5 XAgent框架 263

- 10.6 AutoGen框架 266

- 10.7 智能体框架实践 269

第 11章 大模型PEFT 273

- 11.1 LoRA 273

- 11.2 PEFT方法概述 279

- 11.3 PEFT与全参数微调 286

第 12章 大模型的训练与推理 288

- 12.1 大模型解码与采样方法综述 288

- 12.2 大模型生成参数及其含义 292

- 12.3 大模型训练与推理预填充阶段的加速方法——FlashAttention 297

- 12.4 大模型专家并行训练 317

- 12.5 大模型推理加速——PagedAttention 321

- 12.6 大模型量化的细节 327

- 12.7 大模型多维并行化训练策略 328

第 13章 DeepSeek 335

- 13.1 DeepSeek系列模型架构创新 335

- 13.2 DeepSeek-R1训练流程 353

- 参考文献 357

《百面大模型》真正厉害的地方在于——它不是单纯的“背八股”,而是帮你建立起一套系统的知识框架和思维逻辑。

每道题都配有:

- 🧠 背后的原理分析

- 🧩 面试官意图解析

- 🛠 答题思路拆解 + 延伸知识点

它像一个“你身边的面试指导专家”,告诉你:“这题不只是问概念,它其实在考你XXX底层机制是否理解。”

《百面大模型》不仅能助你拿下 Offer,也能成为你工作、学习过程中的「知识点速查手册」。

本书已经整理并打包成PDF了,扫描即可拿到这本书

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

在这个版本当中:

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包分享出来, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的

核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调;并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?