在人工智能浪潮席卷全球的今天,大语言模型正以前所未有的速度推动着科技进步和产业变革。从 ChatGPT 到各类行业应用,LLM 不仅重塑了人机交互的方式,更成为推动学术研究与产业创新的关键技术。

面对这一飞速演进的技术体系,如何系统理解其理论基础、掌握核心算法与工程实践,已成为每一位 AI 从业者、研究者、高校学子的必修课。

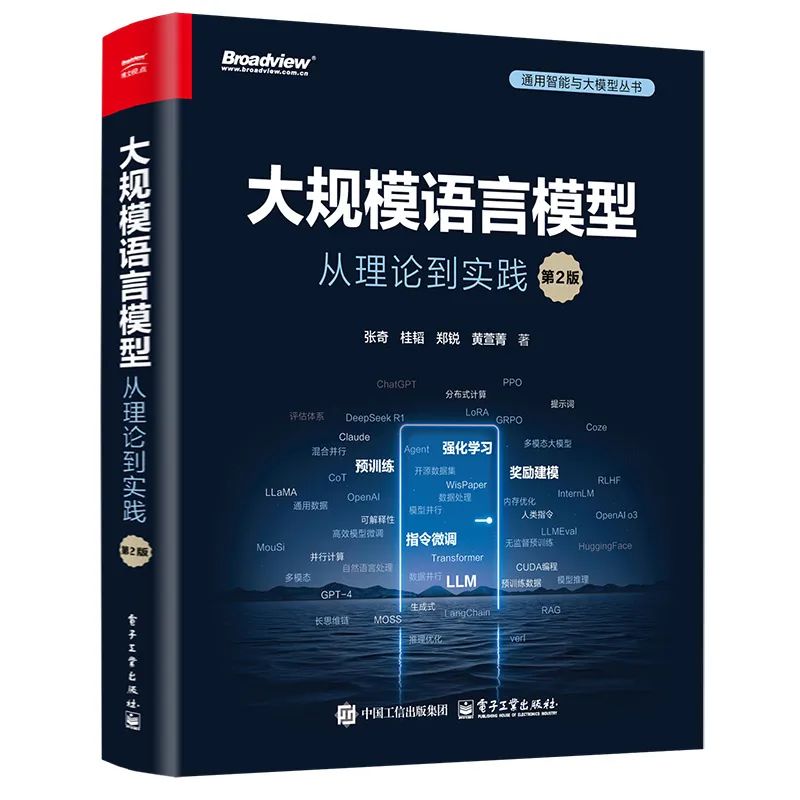

这些发现促使本书的作者“复旦大学NLP团队”张奇、桂韬、郑锐、黄萱菁几位老师对本书第 1 版进行修订升级,补充最新的研究成果和技术内容。

《大规模语言模型:从理论到实践(第2版)》的出版上市,希望可以让读者快速掌握大语言模型的研究与应用,更好地应对相关技术挑战,为推动这一领域的进步贡献力量。

这本《大规模语言模型:从理论到实践(第2版)》书已整理并打包好PDF了

点击可拿↓↓↓

目录:

第1章 绪论1

1.1 大语言模型的基本概念1

1.2 大语言模型的发展历程4

1.3 大语言模型的构建流程8

1.4 本书的内容安排10

第2章 大语言模型基础13

2.1 Transformer结构13

2.1.1 嵌入表示层14

2.1.2 注意力层15

2.1.3 前馈层18

2.1.4 残差连接与层归一化19

2.1.5 编码器和解码器结构20

2.2 生成式预训练语言模型GPT25

2.2.1 自监督预训练25

2.2.2 有监督下游任务微调26

2.2.3 预训练语言模型实践27

2.3 大语言模型的结构32

2.3.1 LLaMA的模型结构33

2.3.2 注意力机制优化39

2.4 混合专家模型46

2.4.1 稀疏混合专家模型47

2.4.2 稠密混合专家模型49

2.4.3 软混合专家模型50

2.5 实践思考51

第3章 大语言模型预训练数据52

3.1 数据来源52

3.1.1 通用数据53

3.1.2 领域数据55

3.2 数据处理56

3.2.1 质量过滤56

3.2.2 冗余去除57

3.2.3 隐私消除58

3.2.4 词元切分59

3.3 数据影响分析64

3.3.1 数据规模64

3.3.2 数据质量66

3.3.3 数据多样性69

3.4 开源数据集70

3.4.1 Pile 70

3.4.2 ROOTS73

3.4.3 RefinedWeb 75

3.4.4 CulturaX77

3.4.5 SlimPajama 78

3.5 实践思考82

第4章 分布式训练83

4.1 分布式训练概述83

4.2 分布式训练的并行策略85

4.2.1 数据并行86

4.2.2 模型并行90

4.2.3 混合并行98

4.2.4 计算设备内存优化99

4.3 分布式训练的集群架构103

4.3.1 高性能计算集群的典型硬件组成103

4.3.2 参数服务器架构104

4.3.3 去中心化架构105

4.4 DeepSpeed实践110

4.4.1 基础概念112

4.4.2 LLaMA分布式训练实践115

4.5 实践思考126

第5章 指令微调127

5.1 指令微调训练127

5.1.1 指令微调数据127

5.1.2 指令微调数据构建方法129

5.1.3 指令微调数据评估与影响135

5.1.4 指令微调训练策略141

5.1.5 开源指令数据集142

5.2 高效模型微调144

5.2.1 LoRA 144

5.2.2 LoRA的变体148

5.3 模型上下文窗口扩展150

5.3.1 具有外推能力的位置编码150

5.3.2 插值法151

5.4 DeepSpeed-Chat SFT实践153

5.4.1 代码结构155

5.4.2 数据预处理157

5.4.3 自定义模型159

5.4.4 模型训练161

5.4.5 模型推理162

5.5 实践思考162

第6章 强化学习164

6.1 强化学习概述164

6.1.1 强化学习基础概念165

6.1.2 强化学习与有监督学习的区别166

6.2 策略梯度方法168

6.2.1 策略梯度168

6.2.2 REINFORCE算法170

6.2.3 广义优势估计171

6.2.4 近端策略优化算法173

6.2.5 RLOO算法175

6.2.6 GRPO算法177

6.3 推理模型的强化学习179

6.3.1 DeepSeek-R1 179

6.3.2 Kimi k1.5 182

6.4 基于人类反馈的强化学习185

6.4.1 基于人类反馈的强化学习流程185

6.4.2 奖励模型186

6.5 verl实践191

6.6 实践思考199

第7章 多模态大语言模型200

7.1 多模态大语言模型基础200

7.1.1 典型的多模态大语言模型201

7.1.2 多模态大语言模型的挑战204

7.2 大语言模型与多模态融合架构205

7.2.1 视觉语言模型架构205

7.2.2 语音语言模型架构209

7.2.3 多模态大语言模型架构213

7.3 多模态大语言模型训练策略217

7.3.1 数据处理218

7.3.2 视觉语义关联219

7.3.3 多模态文本对齐220

7.4 MiniGPT-4实践222

7.4.1 MiniGPT-4模型架构222

7.4.2 MiniGPT-4训练策略225

7.5 实践思考229

第8章 大模型智能体231

8.1 智能体基础231

8.1.1 智能体发展历史231

8.1.2 大模型智能体应用范式232

8.2 大模型智能体架构235

8.2.1 感知模块236

8.2.2 规划模块237

8.2.3 记忆模块238

8.2.4 工具使用模块239

8.3 大模型智能体训练241

8.3.1 工具学习241

8.3.2 推理规划244

8.3.3 长期记忆250

8.4 大模型智能体实践252

8.4.1 手工编写代码252

8.4.2 LangChain框架259

8.4.3 智能体平台Coze实践276

8.5 实践思考279

第9章 检索增强生成280

9.1 检索增强生成基础280

9.1.1 RAG系统的框架281

9.1.2 RAG任务分级282

9.1.3 RAG系统的难点286

9.2 Modular RAG架构287

9.2.1 索引模块288

9.2.2 检索前优化模块291

9.2.3 检索模块293

9.2.4 检索后优化模块296

9.2.5 生成模块297

9.2.6 编排模块298

9.3 RAG系统设计模式301

9.3.1 线性模式301

9.3.2 条件模式302

9.3.3 分支模式303

9.3.4 循环模式304

9.4 RAG系统优化306

9.4.1 文本嵌入模型微调306

9.4.2 查询优化308

9.4.3 幻觉感知的生成模型优化311

9.4.4 重排模型优化312

9.4.5 检索与生成联合优化315

9.5 RAG系统评估316

9.5.1 RAG系统评估的挑战316

9.5.2 评估目标317

9.5.3 评估数据集319

9.5.4 评估指标320

9.6 RAG实践324

9.6.1 构建基础RAG系统324

9.6.2 查询分解与检索结果融合的RAG系统326

9.7 实践思考328

第10章 大语言模型效率优化330

10.1 效率优化基础330

10.2 模型优化334

10.2.1 Transformer代替架构334

10.2.2 模型量化336

10.2.3 模型稀疏化339

10.2.4 知识蒸馏342

10.3 低精度训练345

10.3.1 FP8编码345

10.3.2 FP8大语言模型训练346

10.4 高效推理351

10.4.1 算法级别的推理优化351

10.4.2 系统级别的推理优化356

10.5 vLLM推理框架实践358

10.6 实践思考361

第11章 大语言模型评估362

11.1 模型评估概述362

11.2 大语言模型评估体系364

11.2.1 知识与能力364

11.2.2 伦理与安全367

11.2.3 垂直领域371

11.3 大语言模型评估方法376

11.3.1 评估指标376

11.3.2 评估方法381

11.4 大语言模型评估实践386

11.4.1 基础模型评估387

11.4.2 SFT模型和RL模型评估389

11.5 实践思考399

第12章 大语言模型应用开发401

12.1 大语言模型典型应用场景401

12.1.1 内容创作与生成401

12.1.2 对话系统与聊天机器人402

12.1.3 翻译与多语言处理403

12.1.4 信息抽取与知识图谱404

12.1.5 代码生成与编程辅助404

12.1.6 智能搜索与推荐405

12.1.7 教育与培训406

12.1.8 企业管理与决策支持407

12.1.9 法律与合规407

12.2 大语言模型应用开发案例408

12.2.1 浏览器智能插件408

12.2.2 论文搜索助理412

12.3 大语言模型本地部署实践413

12.3.1 llama.cpp 414

12.3.2 Ollama 417

12.3.3 Open WebUI 419

12.4 实践思考420

参考文献422

索引451

第二版核心升级内容如下**:**

(1) 前沿技术聚焦:深度剖析MoE架构、多模态、智能体、RAG四大技术趋势

(2) 知识体系重构:覆盖预训练→微调→强化学习→应用开发→效率优化的全流程

(3) 实践价值提升:新增逾40%的前沿研究成果与技术案例,增设工程实践指南与评估体系模块

章节

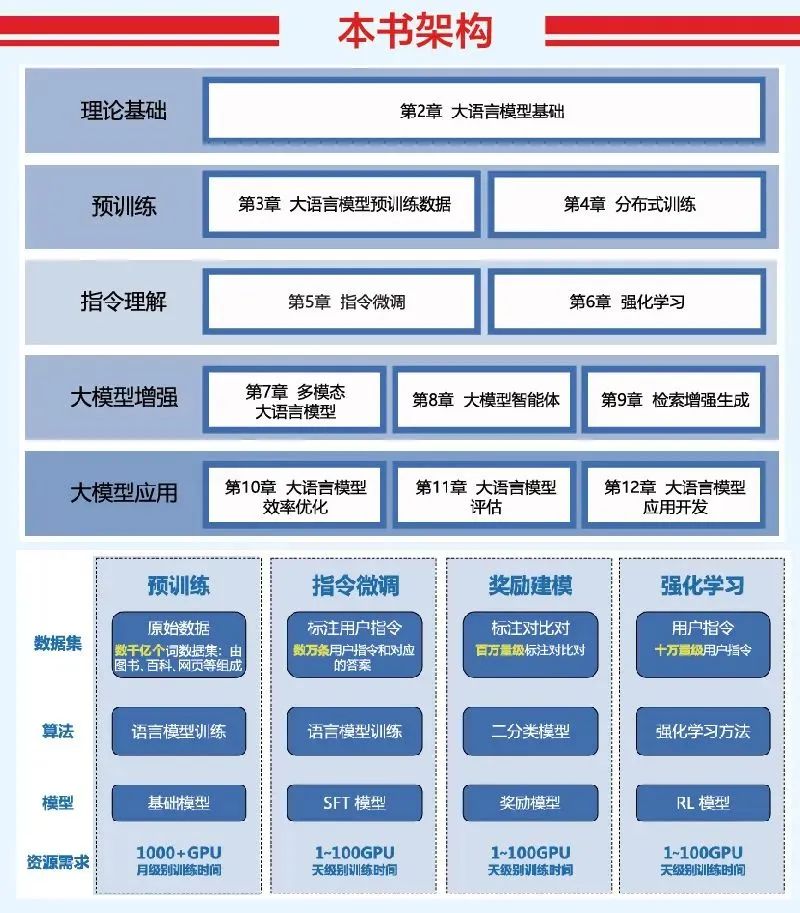

本书共分为12章,围绕大语言模型基础理论、预训练、指令理解、大模型增强和大模型应用五个部分展开。

第1章 绪论

简明介绍了大语言模型的基本概念、发展历史、构建流程,并说明了本书的结构安排,为读者建立起全局认知框架。

第2章 大语言模型基础

深入解析了 LLM 的核心结构——Transformer,包括嵌入、注意力、前馈网络等组成部分,并详解 GPT 模型、混合专家模型(MoE)等不同架构,帮助读者建立从基本结构到模型架构的技术认知。

第3章 预训练数据

介绍了预训练所需的大规模语料来源与数据处理方法(如清洗、去重、切词等),并探讨数据质量、规模、多样性对模型性能的影响。还列举了主流开源数据集,为实际预训练奠定数据基础。

第4章 分布式训练

详细讲解数据并行、模型并行、混合并行等策略及其内存优化技巧,结合实际框架(如 DeepSpeed)的实践,帮助读者理解如何高效训练大模型。

第5章 指令微调

系统介绍了指令微调的理念、数据构建与评估方法、LoRA 等高效微调技术,并辅以 DeepSpeed-Chat 的实践说明,面向实际应用强化模型指令理解与响应能力。

第6章 强化学习

聚焦于 RLHF(基于人类反馈的强化学习),介绍策略梯度、PPO 等算法在语言模型中的应用,结合 DeepSeek-R1、Kimi 等模型案例,展示 RL 在提升生成质量方面的重要作用。

第7章 多模态大语言模型

探讨语言模型与视觉、语音等模态融合的架构与挑战,并详细介绍 MiniGPT-4 的结构和训练方法,是理解 AI 从语言走向感知智能的关键章节。

第8章 大模型智能体

围绕“智能体”概念,讲述其模块化架构(感知、记忆、工具等),并以 LangChain 与 Coze 平台为实践例,说明如何基于 LLM 构建具备规划与行动能力的智能体系统。

第9章 检索增强生成(RAG)

系统介绍 RAG 的整体架构、模块化设计、优化策略与评估方法,适用于提升 LLM 在开放知识任务中的能力。也包括构建与优化 RAG 系统的工程实践。

第10章 效率优化

讨论 LLM 的训练与推理效率,包括模型压缩、低精度训练、稀疏化、知识蒸馏等方法,并以 vLLM 推理框架为实践案例,为部署与落地提供技术方案。

第11章 模型评估

构建了评估 LLM 的系统框架,涵盖知识能力、伦理安全与垂直领域,结合具体评估指标和数据集,为模型开发与应用提供反馈机制与质量保障。

第12章 应用开发

介绍 LLM 在多个场景的应用(如聊天、代码、搜索、教育等),并包含实际开发案例与本地部署实践(如 llama.cpp、Ollama),为开发者提供从原理到落地的全链路指南。

总结:

这本书构建了一个由理论基础 → 数据处理 → 模型训练 → 微调与强化 → 多模态 → 智能体 → 应用开发与部署组成的完整技术闭环,是面向工程实践和科研学习的全景式 LLM 教程。既适合新手入门,也适合有经验的开发者系统提升。

本书架构

围绕 LLM 理论基础、预训练、指令理解、大模型增强、大模型应用五大部分展开。

这本《大规模语言模型:从理论到实践(第2版)》书已整理并打包好PDF了

点击可拿↓↓↓

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

在这个版本当中:

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包分享出来, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的

核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调;并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

1552

1552

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?