基于Transformer的预训练语言模型:解锁自然语言处理的新潜能

在自然语言处理(NLP)领域,预训练语言模型已成为研究和应用的热点。特别是基于Transformer的预训练语言模型,如BERT、GPT等,以其卓越的性能和广泛的应用前景,引领着NLP技术的发展趋势。本文将深入探讨基于Transformer的预训练语言模型的原理、架构、预训练策略及其在实际中的应用。

一、引言:预训练语言模型的崛起

传统的NLP任务通常需要针对每个任务单独设计和训练模型,这不仅费时费力,而且难以获得高性能的模型。预训练语言模型的出现改变了这一局面。通过在大规模文本数据上进行预训练,模型能够学习到通用的语言表示和特征,然后在具体的NLP任务上进行微调,从而显著提高任务性能。

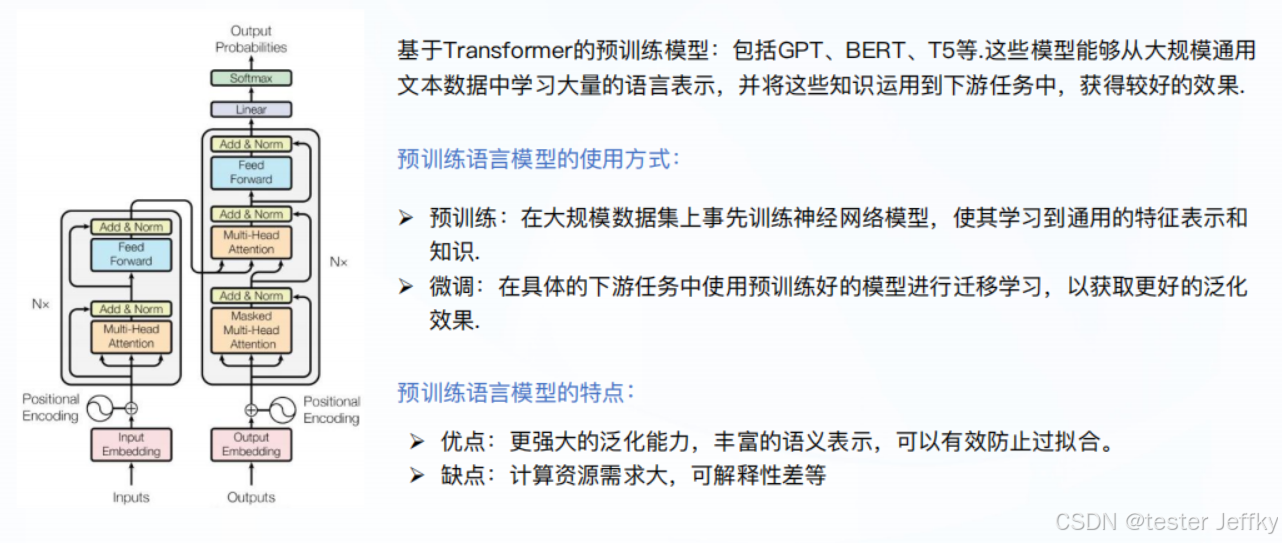

二、Transformer架构简介

Transformer是一种新型的神经网络架构,它摒弃了传统的循环神经网络(RNN)和长短期记忆网络(LSTM),而是基于注意力机制(Attention Mechanism)来处理序列数据。Transformer具有并行计算能力强、训练效率高等优点,成为了预训练语言模型的首选架构。

-

自注意力机制(Self-Attention):自注意力机制是Transformer的核心组件,它允许模型在处理当前位置的词时,动态地关注输入序列中的其他词,从而捕捉到词与词之间的复杂关系。

-

位置编码(Positional Encoding):由于Transformer本身无法直接捕捉词序信息,因此需要通过位置编码来引入序列的位置信息。

-

前馈神经网络(Feed-Forward Neural Network):每个自注意力层后面都跟着一个前馈神经网络,用于进一步处理自注意力层的输出。

三、基于Transformer的预训练语言模型

- BERT(Bidirectional Encoder Representations from Transformers)

- 预训练目标:Masked Language Model(MLM)和Next Sentence Prediction(NSP)。

- 特点:BERT采用了双向编码的方式,即在预训练时同时考虑词的前后语境,从而获得了更丰富的语义表示。

- 应用:BERT在多个NLP任务上取得了SOTA(State-of-the-Art)的成绩,如情感分析、问答系统、文本分类等。

- GPT(Generative Pretrained Transformer)

- 预训练目标:下一个词预测(Next Word Prediction)。

- 特点:GPT采用了生成式的预训练方式,即模型在预训练时不断预测下一个词,从而学会了词序和语义信息。GPT通常具有更强的生成能力。

- 应用:GPT在文本生成、机器翻译、对话系统等领域展现出了强大的实力。

- 其他模型

- 除了BERT和GPT外,还有RoBERTa、ALBERT、T5等基于Transformer的预训练语言模型,它们在不同的设计思路和优化策略下,各自展现了独特的优势和应用场景。

四、预训练策略与微调

- 预训练策略

- 无监督预训练:在没有标注数据的情况下,通过预测下一个词、掩码语言模型等方式进行预训练。

- 有监督微调:在预训练后,使用特定任务的标注数据对模型进行微调,以提高其在具体任务上的性能。

- 多任务学习:同时利用多个相关任务的标注数据进行微调,以进一步提高模型的泛化能力和性能。

- 微调策略

- 任务特定层:在微调时,只更新任务特定层的参数,而保留预训练层的参数不变。这有助于保护预训练时的通用知识。

- 全量微调:虽然全量微调可以获得更好的任务性能,但需要更多的计算资源和时间。

五、实际应用场景

-

文本分类与情感分析:通过微调预训练语言模型,可以有效地进行文本分类和情感分析任务。例如,BERT在GLUE benchmark上的多项指标均达到了SOTA成绩。

-

问答系统:预训练语言模型可以作为问答系统的基础,通过阅读理解等任务进行微调,从而实现准确的问答功能。

-

机器翻译与文本生成:GPT等模型在机器翻译和文本生成领域展现出了强大的实力,能够生成流畅、自然的文本。

-

跨领域应用:预训练语言模型还被应用于代码生成、生物医学信息学等多个领域,展示了其广泛的应用前景。

六、结论与展望

基于Transformer的预训练语言模型已经成为NLP领域的核心技术之一。它们通过在大规模文本数据上进行预训练,学习到通用的语言表示和特征,然后在具体的NLP任务上进行微调,从而显著提高了任务性能。然而,随着语言数据的不断增长和处理需求的不断提高,预训练语言模型也面临着一些挑战和限制,如模型复杂度高、训练时间长、数据稀疏问题等。未来,我们可以期待结合更加先进的深度学习技术和优化算法,进一步提升预训练语言模型的性能和效率。同时,探索预训练语言模型在更多领域中的应用也将成为一个重要的研究方向。

2613

2613

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?