神经网络语言模型:深度探索与实践

在自然语言处理(NLP)领域,语言模型是理解和生成人类语言的基础工具。随着深度学习技术的飞速发展,神经网络语言模型已成为该领域的研究热点。本文将深入探讨神经网络语言模型的原理、架构、训练方法及其在实际中的应用,为读者提供一份专业且内容丰富的博客文章。

一、引言:语言模型的重要性与演进

语言模型是用于估计一段文本出现概率的算法或公式。在NLP任务中,如机器翻译、文本生成、语音识别等,语言模型都扮演着至关重要的角色。传统的基于规则和统计的语言模型虽然在一定程度上取得了成功,但面对复杂的语言现象和大规模文本处理需求时,其局限性逐渐显现。神经网络语言模型的出现,为解决这些问题提供了新的途径。

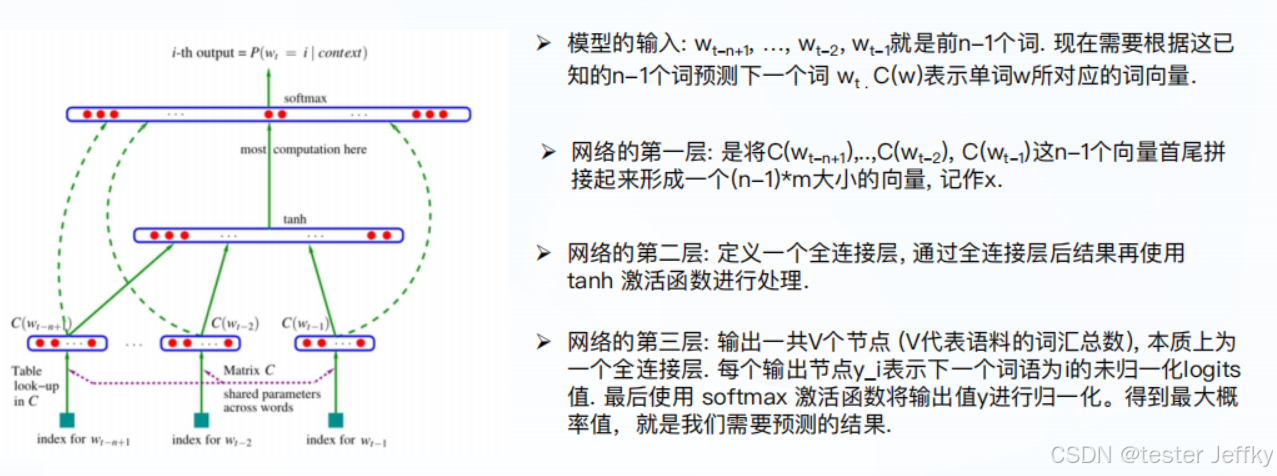

二、神经网络语言模型的原理与架构

- 原理

神经网络语言模型通过构建神经网络来学习文本中的词序和语义信息。它利用大量的文本数据进行训练,自动从数据中学习语言规律和模式,从而能够对未知文本进行概率预测。

- 架构

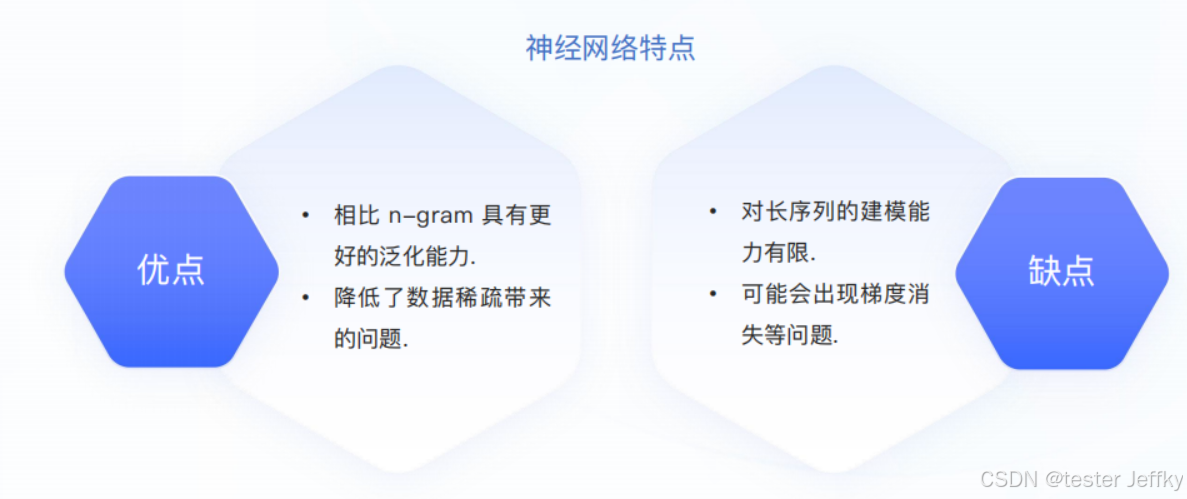

- 循环神经网络(RNN):RNN是神经网络语言模型的一种基础架构,它能够处理序列数据,并保留之前的信息。然而,标准的RNN在处理长距离依赖关系时表现不佳,容易出现梯度消失或梯度爆炸问题。

- 长短期记忆网络(LSTM):LSTM是一种特殊的RNN,它引入了门控机制,能够更有效地捕捉长期依赖信息。因此,LSTM在语言模型任务中表现出色。

- 变压器(Transformer):Transformer是一种基于注意力机制的模型,它摒弃了传统的循环结构,能够更高效地处理序列数据。Transformer在多个NLP任务中取得了突破性的进展,成为了当前的研究热点。

- 特点

三、神经网络语言模型的训练方法

-

前向传播:输入文本通过神经网络进行处理,得到每个词的输出概率。

-

损失函数:常用的损失函数包括交叉熵损失等,用于衡量模型预测与真实标签之间的差异。

-

反向传播与优化:通过反向传播算法计算损失函数关于模型参数的梯度,并使用优化算法(如随机梯度下降SGD等)更新模型参数,以最小化损失函数。

-

训练技巧:为了提高训练效率和模型性能,常用的训练技巧包括批量归一化、学习率调整、预训练与微调等。

四、神经网络语言模型的实际应用场景

-

文本生成:神经网络语言模型能够根据给定的文本内容生成续写或全新的文本,广泛应用于自动写作、对话系统等领域。

-

机器翻译:在机器翻译任务中,语言模型用于预测目标语言的词序和语义信息,从而提高翻译质量和流畅性。

-

语音识别:神经网络语言模型能够结合语音信号处理技术,实现对口语的准确识别和转写。

-

情感分析与分类:通过学习文本中的语义信息,神经网络语言模型可以辅助进行情感分析、文本分类等任务。

五、结论与展望

神经网络语言模型以其强大的表示能力和学习能力,在自然语言处理领域展现出了巨大的潜力。然而,随着语言数据的不断增长和处理需求的不断提高,神经网络语言模型也面临着一些挑战和限制,如模型复杂度高、训练时间长、数据稀疏问题等。未来,我们可以期待结合更加先进的深度学习技术和优化算法,进一步提升神经网络语言模型的性能和效率。同时,探索神经网络语言模型在更多领域中的应用也将成为一个重要的研究方向。

1026

1026

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?