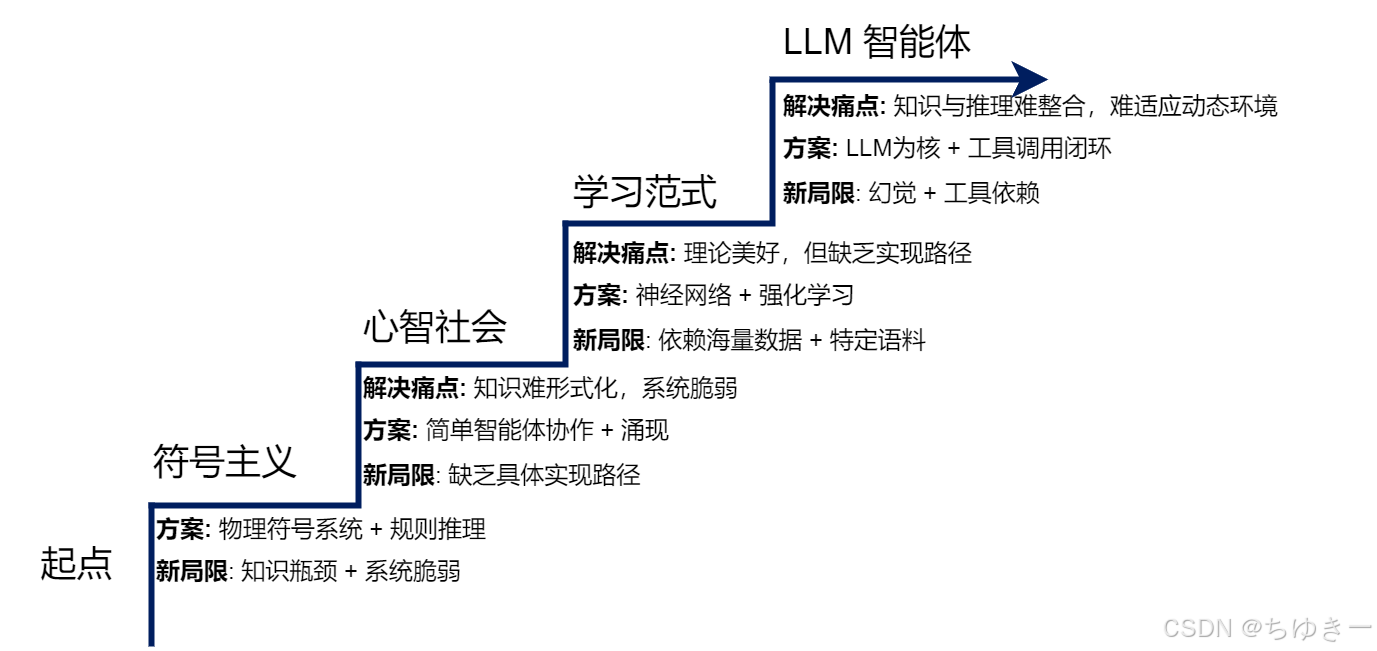

为了深刻理解现代智能体为何呈现出如今的形态,我们需要回溯历史。本章将从“古典时代”出发,见证智能如何从逻辑符号的规则体系,演变为分布式的协作思想,最终通过“学习”范式催生出现代智能体 。

2.1 基于符号与逻辑的早期智能体

人工智能领域的早期探索,深受数理逻辑和计算机科学基本原理的影响。在那个时代,研究者们普遍持有一种信念:人类的智能,尤其是逻辑推理能力,可以被形式化的符号体系所捕捉和复现。 这一核心思想催生了人工智能的第一个重要范式——符号主义 (Symbolicism),也被称为“逻辑 AI”或“传统 AI” 。

在符号主义看来,智能行为的核心是基于一套明确规则对符号进行操作。因此,一个智能体可以被视为一个物理符号系统:它通过内部的符号来表示外部世界,并通过逻辑推理来规划行动 。

💡 深度解析:符号主义的本质

在这个阶段,智能体的“智慧”完全来源于设计者预先编码的知识库和推理规则,而非通过自主学习获得。这与现代 Deep Learning 的“黑盒”模式完全相反,符号主义是完全“白盒”的、可解释的逻辑推演。

2.1.1 物理符号系统假说

符号主义时代的理论根据,是 1976 年由艾伦·纽厄尔 (Allen Newell) 和赫伯特·西蒙 (Herbert A. Simon) 共同提出的 物理符号系统假说 (Physical Symbol System Hypothesis, PSSH) 。

该假说包含两个核心论断 :

- 充分性论断:任何一个物理符号系统,都具备产生通用智能行为的充分手段。

- 必要性论断:任何一个能够展现通用智能行为的系统,其本质必然是一个物理符号系统。

物理符号系统的构成

这里的物理符号系统指的是一个能够在物理世界中存在的系统,它由一组可被区分的符号和一系列对这些符号进行操作的过程组成。

简而言之,PSSH 大胆地宣称:智能的本质,就是符号的计算与处理 。

💡 注解:从 PSSH 到现代计算机

这个假说将“心智”这一哲学问题转化为了“工程”问题。它暗示了只要我们能找到正确的知识表示 (Representation) 和 推理算法 (Inference Algorithm),就能在硅基芯片上实现智能。这直接指引了后来专家系统和自动规划(Automated Planning)的研究。

2.1.2 专家系统

在物理符号系统假说的直接影响下,专家系统 (Expert System) 成为符号主义时代最成功的应用成果。其核心目标是模拟人类专家在特定领域内解决问题的能力 。

通用架构

一个典型的专家系统通常由知识库、推理机、用户界面等几个核心部分构成。这种架构清晰地体现了知识与推理相分离的设计思想 。

核心组件详解

- 知识库 (Knowledge Base):

- 这是知识存储中心。

- 知识表示:最常用的是产生式规则 (Production Rules),即

IF-THEN形式。 - Example:

IF 病人有发烧症状 AND 咳嗽 THEN 可能患有呼吸道感染。

- 推理机 (Inference Engine):

- 核心计算引擎,负责在知识库中寻找并应用规则。

- 工作方式:

- 正向链 (Forward Chaining):数据驱动。从已知事实出发,不断匹配规则的 IF 部分,推导结论。

- 反向链 (Backward Chaining):目标驱动。从假设的目标(如“是否患肺炎”)出发,反向寻找能推导出该目标的规则,递归验证子目标。

💡 深度解析:正向链 vs 反向链

- 正向链适合“监控”或“配置”场景:既然有了这些零件,我能组装成什么?

- 反向链适合“诊断”场景:为了确认是这个病,我需要检查哪些症状?(MYCIN 就是典型代表)。

应用案例:MYCIN 系统

MYCIN 是 20 世纪 70 年代斯坦福大学开发的著名专家系统,用于辅助诊断细菌性血液感染 。

- 工作原理:包含约 600 条规则,主要采用 反向链 推理。

- 流程:从“确定致病菌”这一最高目标出发,反向推导。

- 重要创新:置信因子 (Certainty Factor, CF)

MYCIN 引入了 CF (-1 到 1 之间的数值) 来表示结论的可信度。这使得系统能够处理不确定的、模糊的医学知识 。

2.1.3 SHRDLU

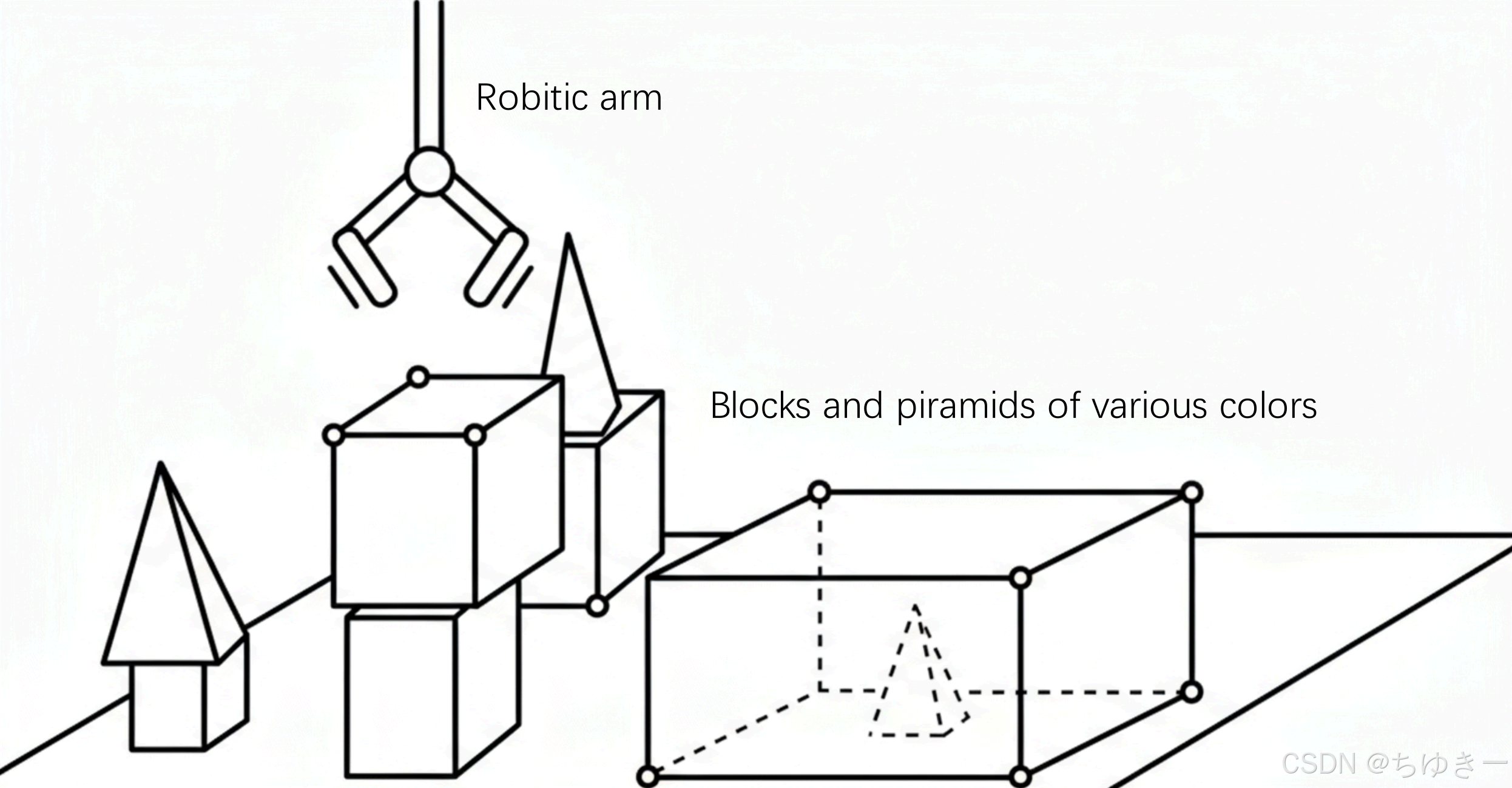

如果说专家系统展示了符号 AI 的“深度”,那么 SHRDLU (Terry Winograd, 1968-1970) 则在“广度”上实现了突破。它旨在构建一个能在 “积木世界 (Block World)” 中通过自然语言与人类交互的综合性智能体 。

“积木世界”交互界面

SHRDLU 运行在一个模拟的三维虚拟空间中,包含:

- 不同形状、颜色、大小的积木(Blocks and pyramids)。

- 一个虚拟机械臂(Robotic arm)。

- 用户通过自然语言下达指令,系统执行动作或回答。

核心能力集成

SHRDLU 首次将多个 AI 模块集成在统一系统中:

- 自然语言理解:

- 能解析复杂歧义句。

- 指代消解:理解

Put it into the box中的it指代上文抓取的物体。

- 规划与行动:

- 自主规划:指令是“把蓝色积木放到红色积木上”,如果红色积木上有东西,它会规划出“先移开障碍物”的序列。

- 记忆与问答:

- 世界状态:

Is there a large block behind a pyramid? - 行为动机:

Why did you pick up the red block?->BECAUSE YOU ASKED ME TO.

💡 注解:SHRDLU 的历史地位

SHRDLU 的“感知-思考-行动”闭环设计,奠定了现代智能体(Agent)研究的基础架构。但它的成功严格局限于“积木世界”这个微观环境,一旦脱离这个规则明确的封闭世界,系统就会失效。

2.1.4 符号主义面临的根本性挑战

尽管早期项目成就显著,但从 20 世纪 80 年代起,符号主义 AI 在走向开放现实世界时,遇到了根本性难题 。

(1) 常识知识与知识获取瓶颈

-

知识获取瓶颈 (Knowledge Acquisition Bottleneck):将人类专家的内隐知识编码为 IF-THEN 规则极其昂贵且耗时。试图将整个世界的知识手工符号化几乎是不可能的 。

-

常识问题 (Common-sense Problem):人类依赖庞大的背景常识(如“水是湿的”),除非显式编码,否则符号系统对此一无所知 。

(2) 框架问题与系统脆弱性

-

框架问题 (Frame Problem):在动态世界中,智能体执行动作后,判断哪些事物未发生改变是一个逻辑难题。为每个动作显式声明所有不变的状态,计算上不可行 。

-

系统脆弱性 (Brittleness):符号系统完全依赖预设规则。一旦遇到规则之外的微小变化,系统便可能完全失灵,无法像人类一样灵活变通 。

💡 深度解析:框架问题 (Frame Problem)

想象你有一个机器人。你告诉它“打开灯”。规则库里写了“打开灯 -> 房间变亮”。但是,机器人怎么知道“打开灯”这个动作不会导致“墙壁颜色改变”、“窗户破碎”或者“重力消失”?

在符号逻辑中,如果不写下Action(OpenLight) -> NOT Change(WallColor),逻辑上就无法确定墙壁颜色是否变了。而在现实世界,不发生改变的东西是无穷无尽的,我们无法穷举这些“非效果”。这就是著名的框架问题。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?