| 一、Lenet-5的结构 点击此处返回总目录 二、lenet-5在Mnist上的应用

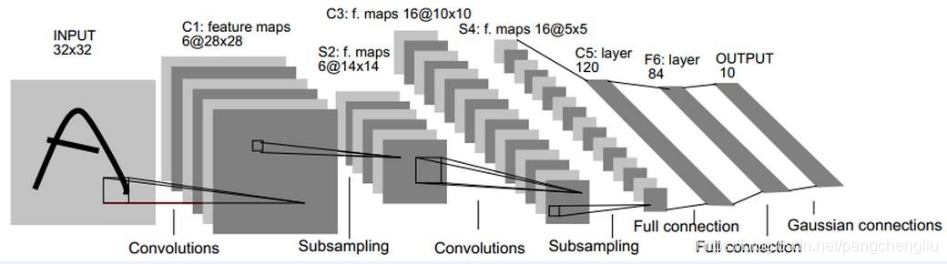

一、Lenet-5结构 Lenet-5是LeCun等人在1998年提出。结构如下:

或:

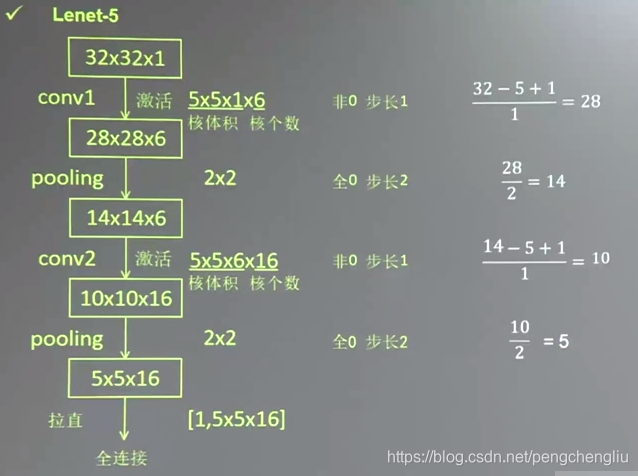

(C1)Lenet-5首先使用了6个5*5*1的核对输入的32*32*1的图片进行卷积计算。卷积计算后的结果通过激活函数。由于不使用0填充,步长为1,用padding公式计算得到,输出图片长为28。由于用了6个核,所以深度是6。参数个数为(5*5*1+1)*6 = 156个。

(S2)随后,使用了2*2的核对输出的28*28*6的图片进行池化,步长是2。输入长28除以步长2等于14。可见通过池化操作,减少了75%的图片信息。池化操作不改变图片的深度,所以输出是14*14*6。

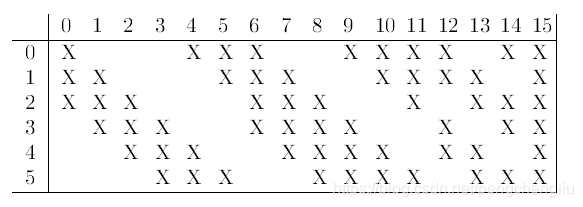

(C3)使用16个5*5*6的核。核的深度要和输入的深度一致,所以核的深度是6。一个卷积核会把6张图变成一张图。参数的个数为(5*5*6+1)*16 = 2416个。不使用0填充,步长为1。输出尺寸大小为(14-5+1)/1 = 10。输出图片的深度等于使用卷积核的个数,所以输出为16个10*10的特征图。卷积计算的结果通过激活函数。

(S4)使用2*2的池化核,对16个10*10的图片进行池化,步长为2。池化不改变图片的深度。输出16个5*5的图片。

(C5)最后把16个5*5的图片拉成一维数组,再送到全连接网络。 C5层的一种解释是:使用120个5*5*16的卷积核进行卷积。每个卷积核的大小跟图片大小相同,所以使用一个卷积核生成的一个图片只包含一个像素点。120个卷积核产生120个像素点。卷积核参数有(5*5*16+1)*120=48120个。 C5层的另一种解释是:首先把16张5*5的图片拉成一维数组,再送到全连接神经网络。输入5*5*16个点,经过一层的全连接神经网络,生成了120个点。全连接神经网络的参数有(5*5*16)*120个w+120个b = 48120个参数。

(F6)1层的全连接网络。参数有120*84个w+84个b=10164个。

二、Lenet-5在Mnist数据集上的应用 由于MNIST数据集存放的是28*28*1的灰度图片,我们把Lenet-5进行更改,让他匹配28*28*1的输入图片。 先用32个5*5*1的卷积核对输入的28*28*1的图片做卷积,过 |

卷积神经网络(1)----Lenet-5

最新推荐文章于 2025-03-07 16:26:52 发布

本文介绍了卷积神经网络的基础知识,并详细解析了经典的LeNet-5模型,包括其结构、工作原理以及在图像识别中的应用。通过学习,读者将对卷积神经网络有初步理解。

本文介绍了卷积神经网络的基础知识,并详细解析了经典的LeNet-5模型,包括其结构、工作原理以及在图像识别中的应用。通过学习,读者将对卷积神经网络有初步理解。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

902

902

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?