DeepSeek 本地部署工具 v6.0:便捷高效的 AI 模型本地化利器

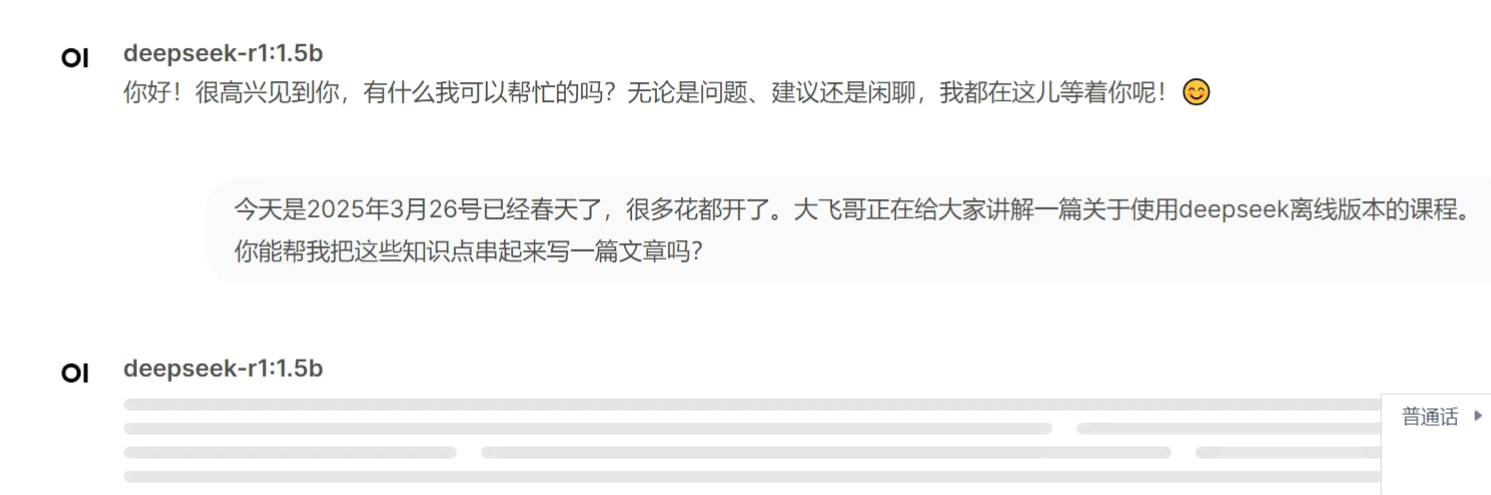

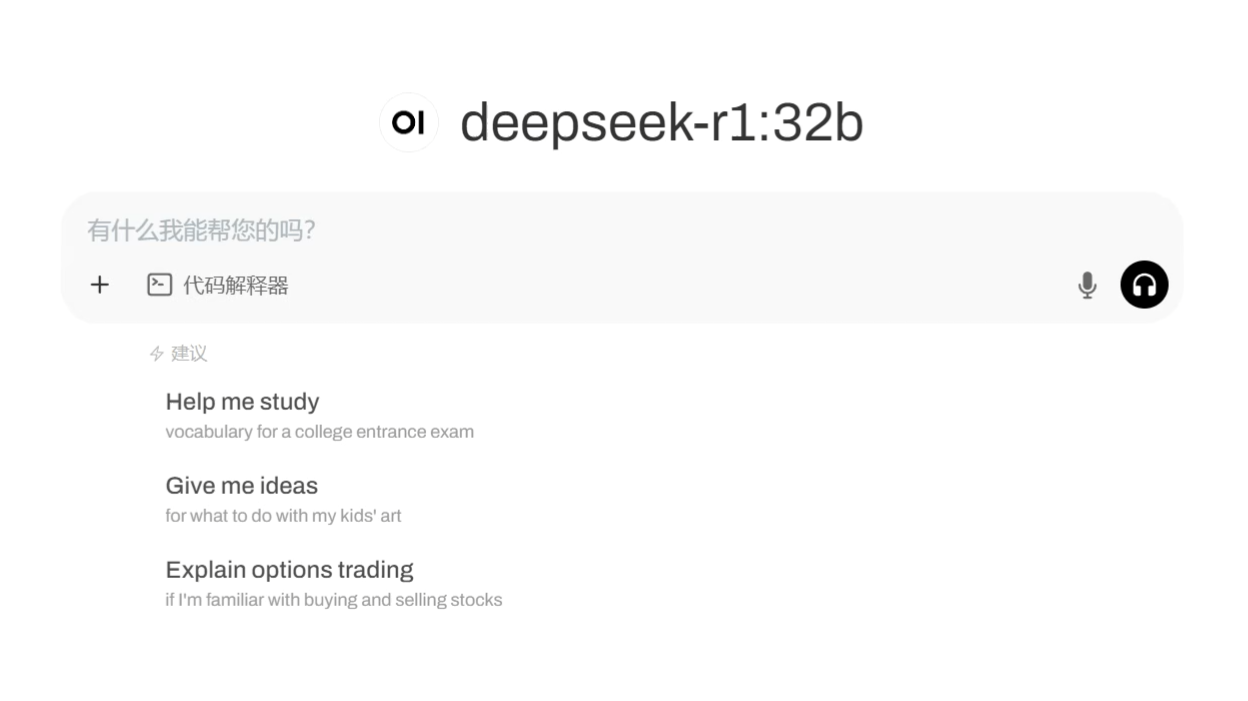

DeepSeek 本地部署工具 v6.0 作为一款专为本地化 AI 推理精心打造的卓越产品,堪称 AI 领域的革新性部署工具。它打破传统复杂部署流程的桎梏,以一键解压即用的超便捷操作模式,让用户无需面对繁琐的配置步骤,即可迅速启动 1.5b 至 32b 多种规格的预训练模型,为各类用户开启轻松驾驭 AI 模型的大门。

该工具功能卓越。极简部署流程下,一体化封装设计摒弃了手动配置 CUDA 环境以及安装依赖库等复杂流程,用户仅需下载压缩包解压,便能通过图形化界面或者命令行轻松启动服务,内置智能调度系统会依据硬件资源状况自动合理分配,无论是 NVIDIA、AMD 显卡,还是苹果 M 系列芯片,都能被充分且高效利用。在模型兼容性与性能优化上,它对 DeepSeek 系列多种模型(如 1.5b、7b、14b、32b 等)均友好支持,

借助动态量化技术,将显存占用压缩至行业领先水平,实测 32b 模型在 8GB 显存设备上依旧能够流畅运行,推理速度较同类方案大幅提升 30% ,面对高性能需求场景,多卡并行加速功能可通过简单配置调用多 GPU 资源。此外,它还具备多场景适配能力,内置 RAG 引擎与知识库直连功能,助力快速搭建企业级智能问答系统,开发者通过 API 接口或 Python 库能将模型无缝集成到现有工作流,实现代码生成、数据分析、内容创作等多场景自动化处理,且与 Ollama 等开源部署框架兼容,支持模型格式无缝转换与扩展。

其适用人群广泛,无论是 AI 开发新手,渴望简单上手体验模型部署乐趣;还是专业开发者,期望在项目中快速集成模型;亦或是企业用户,需要搭建高效的智能应用,v6.0 都能满足需求。使用时,用户先下载对应压缩包解压,打开图形化界面或在命令行中,选择所需运行的模型规格,简单设置相关参数(如推理精度等),点击启动即可开始使用。

DeepSeek 本地部署工具 v6.0 的核心使命是让 AI 模型部署变得轻松高效,消除技术门槛,为用户创造极大价值,赋予开发者和企业在 AI 应用开发与部署上的灵活性和自主性。技术上,深度优化模型架构与推理引擎,大幅降低硬件门槛;在安全认证方面,严格保障数据安全与隐私,防止模型被滥用;性能指标出色,模型加载速度快,推理延迟低。

在硬件要求与兼容性上,对于入门级用户,2GB 显存显卡搭配 8GB 内存即可运行 1.5b - 7b 模型;专业级部署推荐 16GB 显存加 32GB 内存,以支持 14b - 32b 模型;如需集群扩展,还可通过信服云管理平台实现多节点资源统一调度,并且能适配 Windows、Linux、macOS 等多种操作系统以及 NVIDIA、AMD、Intel 等主流显卡。自推出以来,DeepSeek 本地部署工具 v6.0 已在市场上获得广泛验证,众多开发者借助它高效完成项目开发,企业利用它成功搭建智能应用,凭借出色的性能、便捷的操作和良好的兼容性,已然成为 AI 模型本地化部署的首选工具之一 。

7473

7473

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?