前面讲了几节决策树从底层的构造原理,更多的是面向分类的决策树,从树的用途上讲还有一种用途,那就是回归树,结构也是树,但是出来的结果是回归值。可能很多人不用回归树做任务的时候很少去管回归树,以至于有时候也不知道它们的区别,但是还是有必要掌握,因为牛逼的树算法,比如GBDT,xgboost的单棵树可不是分类树,是回归树。

所谓分类树就是面向分类的,每个决策树最末端的叶子结点出来的是一个分类标签,不是0就是1或者2等类别。回归树就是面向回归的,回归就是拟合函数一样,输出连续值,比如根据一大堆当天的特征输出明天的气温,气温是每个样本唯一输出的值,只不过输出的值根据特征的不一样输出值不一样而已,但是它们输出的意义是一样的,那就是都是气温。搞清楚这两者的输出区别很重要。

再来简单回顾下决策树的历程,对于分类树,最开始以信息熵的方式作为特征分裂节点的选择,是第一代ID3方法,之后改进信息熵的部分缺点,采用信息增益的方式作为分类节点,变成了C4.5方法,再有就是采用gini系数的方式作为特征分裂的方法,变成了CART分类树,但是gini系数的方法更多见于回归树里面,此时回归分类已经有点混用了。

CART的字面意思就是分类和回归树(classification and regression tree)。关于分类树就不再介绍了。重点解释下回归树的构造与区别。

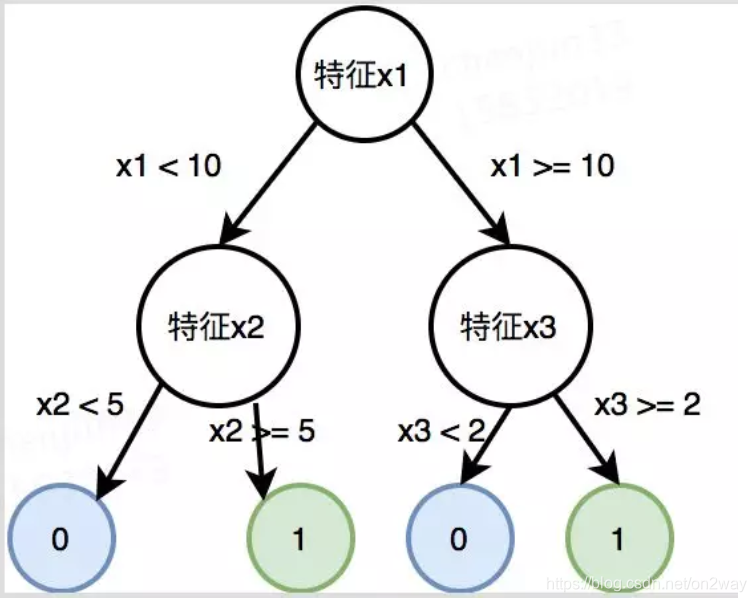

我们说分类树的最后一层叶子结点后才是分类标签,其他时候的节点都不是,可以认为是某个特征属性。简单如图1所示,树构建完以后就是父节点都是按照大特征走,走到最后才是分类结果。

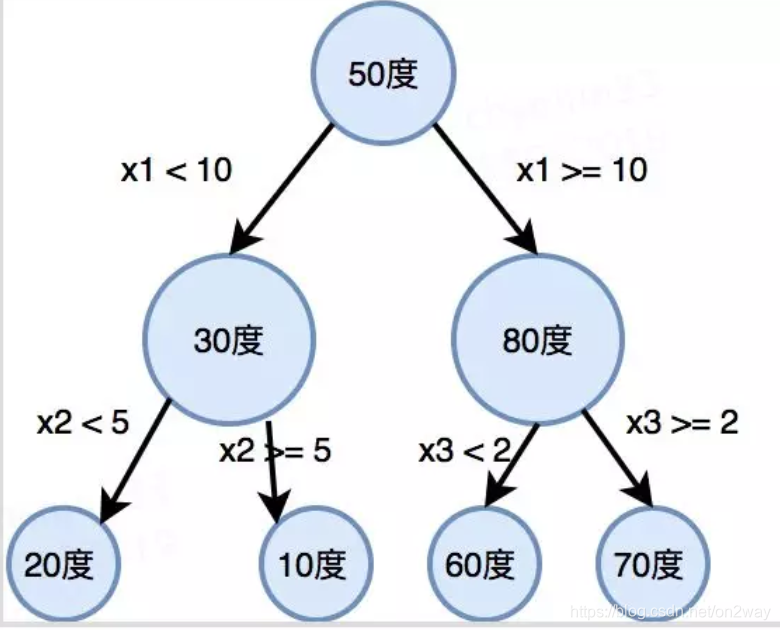

那么回归树不是这样,它们所有节点可以理解为都是一个东西,就是待回归属性,比如温度,最后的回归值是把树走完走到最后一个节点的值。简单如图2所示:

<

<

本文介绍了决策树中的分类树和回归树。分类树输出分类标签,回归树输出连续值。回顾了决策树发展历程,重点解释回归树构造与区别,指出其节点可理解为待回归属性。还说明了回归树构建方法,通过遍历找分割属性与值,用平方误差最小化准则选特征,它是GBDT、Xgboost基础。

本文介绍了决策树中的分类树和回归树。分类树输出分类标签,回归树输出连续值。回顾了决策树发展历程,重点解释回归树构造与区别,指出其节点可理解为待回归属性。还说明了回归树构建方法,通过遍历找分割属性与值,用平方误差最小化准则选特征,它是GBDT、Xgboost基础。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

369

369