文章目录

1 简介

论文题目:CLIO: Role-interactive Multi-event Head Attention Network for Document-level Event Extraction

论文来源:COLING 2022

组织机构:中科院信息工程研究所

论文链接:https://aclanthology.org/2022.coling-1.221.pdf

1.1 动机

- 文档级事件抽取存在两个挑战:嵌套论元(WikiEvents中14.23% RAMS中13.94%)和同时存在多个事件(WikiEvents中86.88%)。

1.2 创新

- 提出role-interactive multi-event head attention network解决嵌套论元和多个事件问题。

2 方法

模型的整体结构如上图,主要包括三个部分:(1)Roleinteractive Multi-event Head Attention, (2) Multiple Events Extraction, (3) Event Representation Enhancing

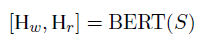

首先将文档和论元角色进行拼接,S= [CLS]D[SEP]R[SEP], 然后使用BERT进行编码(公式1),由于不少每个词都是有意义的,使用L2-Norm衡量单词表达意义的能力(公式2)。

|

|

2.1 Role-interactive Multi-event Head Attention

对于每个事件类型,衡量每个role-word对的相关性,首先使用全连接映射到一个低的维度(公式1),然后使用concat attention计算词表示和角色表示的相关性(公式2)

|

|

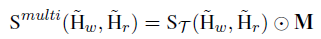

全部的事件类型,使用role-interactive event attention得到event heads,堆叠得到 S T S_T ST,使用矩阵M减少事件的角色数量(不在该事件的为0,公式1),最终的多事件相关矩阵为公式2

|

|

2.2 Multiple Events Extraction

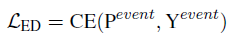

在多事件相关矩阵中,大于阈值的role-word对为当前角色的论元抽取结果,loss为交叉熵

为了更好地检测文档中的事件,为每个事件构造具体的表示。对事件类型t的role-interactive event attention进行标准化,然后使用平均池化得到文档表示

H

D

H_D

HD,最后进行2分类(公式1),loss为交叉熵(公式1)。

|

|

2.3 Event Representation Enhancing

上述阶段得到词向量具有各项异性(anisotropic,词向量在向量空间中为行锥形),因此使用对比学习加强事件表示,拉近角色到论元的距离,拉远角色到其他词的距离,基于InfoNCE,衡量相似性为cosine 相似性(公式1),目标函数为公式2,总loss为公式3。

|

|

|

3 实验

实验数据集为RAMS和WikiEvents,实验结果如下图:

在嵌套论元和不嵌套论元的数据上的实验结果:

在不同数量事件上的实验结果:

词向量的可视化:

Case study:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?