在colab中运行本节内容需先安装d2l

!pip install d2l==0.14.1、隐藏层

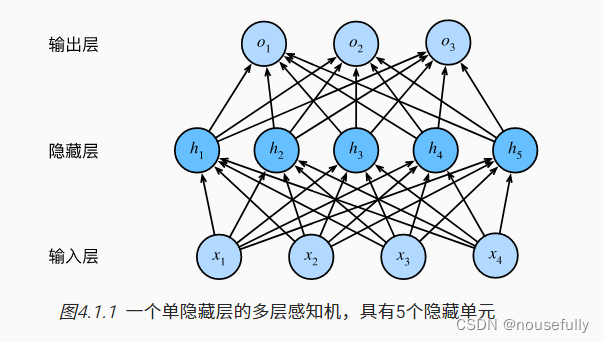

我们可以通过在网络中加入一个或多个隐藏层来克服线性模型的限制, 使其能处理更普遍的函数关系类型。

多层感知机可以通过隐藏神经元,捕捉到输入之间复杂的相互作用, 这些神经元依赖于每个输入的值。

虽然一个单隐层网络能学习任何函数, 但并不意味着我们应该尝试使用单隐藏层网络来解决所有问题。 事实上,通过使用更深(而不是更广)的网络,我们可以更容易地逼近许多函数。

2. 激活函数

通过计算加权和并加上偏置来确定神经元是否应该被激活, 它们将输入信号转换为输出的可微运算。 大多数激活函数都是非线性的。

导入需要的包:

%matplotlib inline

import torch

from d2l import torch as d2l2.1. ReLU函数

最受欢迎的激活函数是修正线性单元(Rectified linear unit,ReLU)

RELU(x)=max(x,0)

通俗地说,ReLU函数通过将相应的活性值设为0,仅保留正元素并丢弃所有负元素。 为了直观感受一下,我们可以画出函数的曲线图。 正如从图中所看到,激活函数是分段线性的。

本文介绍了多层感知机如何通过隐藏层增强模型能力,重点讨论了ReLU、sigmoid和tanh三种常见的激活函数,包括它们的定义、曲线展示和导数特性。理解这些概念有助于设计更有效的神经网络模型。

本文介绍了多层感知机如何通过隐藏层增强模型能力,重点讨论了ReLU、sigmoid和tanh三种常见的激活函数,包括它们的定义、曲线展示和导数特性。理解这些概念有助于设计更有效的神经网络模型。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1482

1482

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?