文章目录

1.神经网络如何调参?

GridSearch

神经网络调参的方法一般叫网格搜索法,对所有参数进行循环遍历,尝试每一种可能性,找出最优结果。其原理就像是在数组里寻找最大值。

2. 讲一下Transformer?以及它比RNN优势在哪里?

tensorfmer使用的编码解码器原理,它将输入序列编码成一个连续表达式,在输出端将这个表达式又转换成序列。

它的编码器和解码器各有6层,在每一层后面都会接一个残差归一化层。模型中的所有子层的输出维度都是512。

-

对于RNN来说,它当前隐藏层的输出只与上一层的隐藏层输出和当前的输入有关系,限制了模型的并行能力且无法处理长期依赖。

-

LSTM在一定程度上能够解决长期依赖问题,但是对于特别长期的依赖仍然无法处理。

-

Tensorfor将序列中任意两个位置之间的距离转换成一个常量;并且它不同于CNN的顺序结构,它能够并行处理问题。

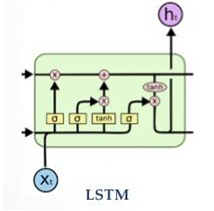

3. LSTM的概念,LSTM有哪些变种以及BPTT(基于时间的反向传播)

LSTM是为了解决RNN无法处理长程依赖问题的,它的结构主要由输入门、遗忘门以及输出门组成。控制门开关的cell类似于信息传送工具,使得LSTM在长序列场景下不会丢失信息。

它的变种包括:

-

MOGRIFIER LSTM:网络的特点是当前这一轮的输入和隐藏状态输入都是由上一轮训练的输入和隐藏状态计算得到的,这就保证了信息各层输入与隐藏状态之间产生关联,更好获取上下文信息。

-

GRU:它的特点是只有更新门和重置门。更新门用来

本文介绍了神经网络的调参方法——网格搜索,Transformer的结构及其对比RNN的优势,LSTM的原理和变种,以及BPTT的工作机制。还讨论了逻辑回归使用交叉熵而非MSE的原因,CNN的优点和缺点,item-CF的推荐算法,以及TFIDF的文本分析作用。最后,概述了决策树的算法和优缺点。

本文介绍了神经网络的调参方法——网格搜索,Transformer的结构及其对比RNN的优势,LSTM的原理和变种,以及BPTT的工作机制。还讨论了逻辑回归使用交叉熵而非MSE的原因,CNN的优点和缺点,item-CF的推荐算法,以及TFIDF的文本分析作用。最后,概述了决策树的算法和优缺点。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

605

605

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?