langchain介绍

LangChain 是一个用于开发由大型语言模型 (LLM) 驱动的应用程序的框架。 简单来说,它可以帮助你更轻松地构建利用 LLM(例如 OpenAI 的 GPT 模型、Google 的 PaLM 模型等)的应用程序。

实践

给大模型添加联网功能也就是添加一个搜索引擎。一种方式就是先经过搜索引擎再把信息传给大模型进行回答,另一种就是使用function calling + 搜索引擎API 让大模型自己决定是否需要使用联网功能。

而免费的搜索引擎指的是duckduckgo,可能效果上没有付费的搜索引擎比如必应api与谷歌api好就是了,但是单纯用于测试联网功能的实现那也足够了。

首先先简单过一遍langchain的使用。

接入OpenAI的大模型并使用非流式与流式响应:

from langchain.chat_models import init_chat_model

from langchain_core.messages import HumanMessage, SystemMessage

api_key = "你的api_key"

model = init_chat_model("gpt-4o-mini", model_provider="openai",api_key=api_key)

print(model.invoke([HumanMessage(content="你是谁?")]))

messages = [

HumanMessage("你是谁?"),

]

for token in model.stream(messages):

print(token.content, end="|")

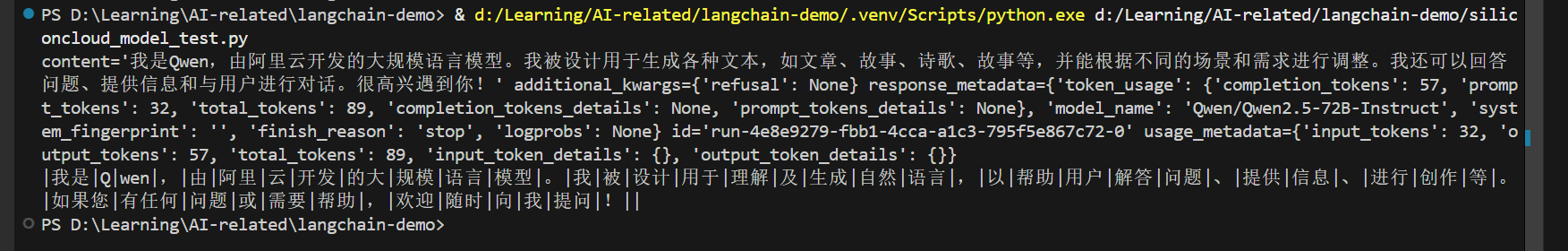

再试一下接入国内的大模型并使用非流式与流式响应:

from langchain.chat_models import init_chat_model

from langchain_core.messages import HumanMessage

api_key = "你的api_key"

base_url = "https://api.siliconflow.cn/v1"

model = init_chat_model("Qwen/Qwen2.5-72B-Instruct", model_provider="openai",api_key=api_key,base_url=base_url)

print(model.invoke([HumanMessage(content="你是谁?")]))

messages = [

HumanMessage("你是谁?"),

]

for token in model.stream(messages):

print(token.content, end="|")

由于这个功能的实现,需要使用工具调用,现在来看看在langchain如何使用工具调用:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4745

4745

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?