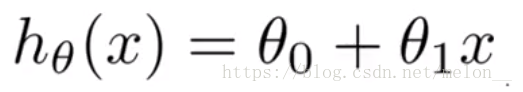

一、模型表示

只含有一个特征/输入变量,这样的问题叫作单变量线性回归问题。

m :表示训练样本的数目

X:代表特征/输入变量

Y:代表目标变量/输出变量

(x, y):表示一个训练样本

(x(i), y(i)) :表示第i个训练样本

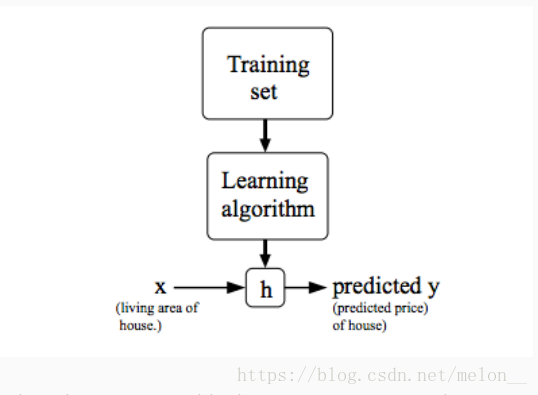

h(hypothesis):function h : X → Y so that h(x)

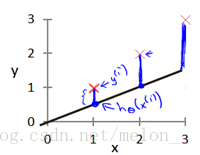

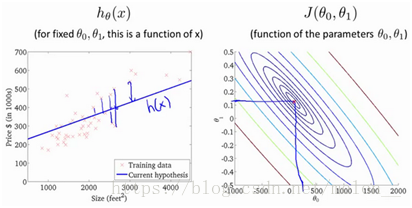

我们选择的参数决定了我们得到的直线相对于我们的训练集的准确程度,模型所预测的值与训练集中实际值之间的差距(下图中蓝线所指)就是建模误差(modeling error)。

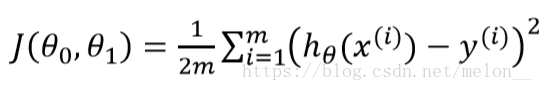

我们的目标便是选择出可以使得建模误差的平方和能够最小的模型参数。 即使得代价函数 最小。

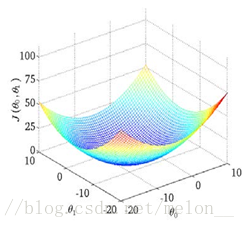

二、代价函数

代价函数的直观理解:

在三维空间中存在一个使得 ![]() 最小的点

最小的点

等高线图

在三维空间中存在一个使得![]() 最小的点

最小的点

本文介绍了单变量线性回归的基本概念,包括模型表示、训练样本的定义及其在数学上的表达方式。进一步解释了如何通过调整参数来减小模型预测值与实际值之间的差距,并引入了代价函数的概念。

本文介绍了单变量线性回归的基本概念,包括模型表示、训练样本的定义及其在数学上的表达方式。进一步解释了如何通过调整参数来减小模型预测值与实际值之间的差距,并引入了代价函数的概念。

384

384

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?