参考文档:https://github.com/InternLM/tutorial/tree/main/langchain

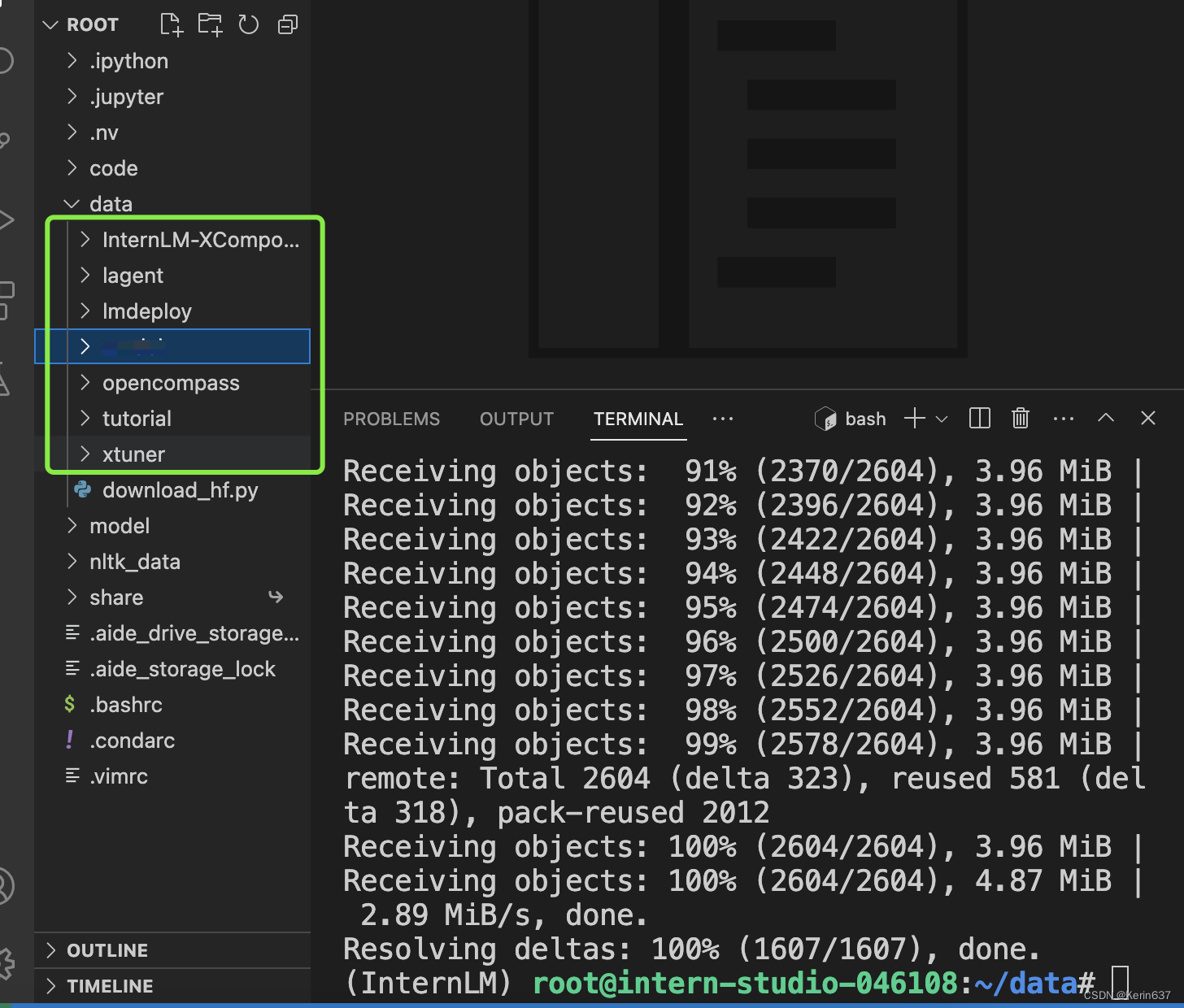

基础作业:复现课程知识库助手搭建过程 (截图)

1.环境配置

2.知识库搭建

(1)数据收集

收集由上海人工智能实验室开源的一系列大模型工具开源仓库作为语料库来源,为语料处理方便,我们将选用上述仓库中所有的 markdown、txt 文件作为示例语料库。注意,也可以选用其中的代码文件加入到知识库中,但需要针对代码文件格式进行额外处理(因为代码文件对逻辑联系要求较高,且规范性较强,在分割时最好基于代码模块进行分割再加入向量数据库)。

(2)在本地构建持久化的向量数据库

# 首先导入所需第三方库

from langchain.document_loaders import UnstructuredFileLoader

from langchain.document_loaders import UnstructuredMarkdownLoader

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.vectorstores import Chroma

from langchain.embeddings.huggingface import HuggingFaceEmbeddings

from tqdm import tqdm

import os

# 获取文件路径函数

def get_files(dir_path):

# args:dir_path,目标文件夹路径

file_list = []

for filepath, dirnames, filenames in os.

本文介绍了如何配置环境,通过收集并处理上海人工智能实验室的开源数据,构建本地向量数据库,利用HuggingFaceEmbeddings和Chroma技术。同时,文章还涉及如何定制LLM子类和创建检索问答链,以及部署WebDemo的步骤,最后鼓励读者在特定领域实践并分享成果。

本文介绍了如何配置环境,通过收集并处理上海人工智能实验室的开源数据,构建本地向量数据库,利用HuggingFaceEmbeddings和Chroma技术。同时,文章还涉及如何定制LLM子类和创建检索问答链,以及部署WebDemo的步骤,最后鼓励读者在特定领域实践并分享成果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2525

2525

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?