目录

2.直方图梯度提升决策树(Histogram-based Gradient Boosting Decision Tree)

3.基于梯度的单边采样(Gradient-based One-Side Sampling)

前言

博主参与过大大小小数十来次数学建模,且也是从事数据分析师这一职业,理解各类模型原理以及每种模型的建模流程和各类题目分析方法。此专栏的目的就是为了让零基础快速使用各类数学模型以及代码,每一篇文章都包含实战项目以及可运行代码,博主紧跟各类数模比赛,每场数模竞赛博主都会将最新的思路和代码写进此专栏以及详细思路和完全代码,打造最实用优质数学建模专栏。专栏模型基本包含所有的预测、分类、聚类、评价、动态规划以及图论算法模型,希望有学习需求的小伙伴不要错过。

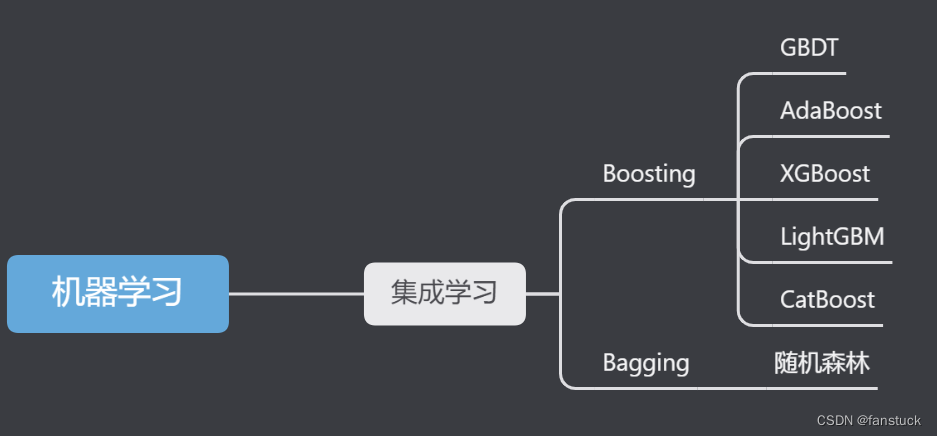

集成学习的方法在全球各大机器学习、数据挖掘竞赛中使用的非常广泛,其概念和思想也是风靡学术界和工业界,我的期刊论文以及毕业百优论文也是用到了集成学习算法。此篇文章主要给Boosting集成算法做总体介绍,了解Boosting集成算法的基本框架以及核心思想。再将每一种集成算法原理和算法包括代码都讲解清楚,结合实际案例项目能够达到实践预测。

一、Boosting算法起源

Valiant和 Kearns提出了弱学习和强学习的

本文深入探讨Boosting算法,从起源、核心思想到框架,重点介绍了AdaBoost、GBDT、XGBoost、LightGBM和CatBoost的原理及特点。通过实例解析,帮助读者快速理解和应用Boosting集成学习模型。

本文深入探讨Boosting算法,从起源、核心思想到框架,重点介绍了AdaBoost、GBDT、XGBoost、LightGBM和CatBoost的原理及特点。通过实例解析,帮助读者快速理解和应用Boosting集成学习模型。

订阅专栏 解锁全文

订阅专栏 解锁全文

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?