目录

- 了解RDD的处理过程

- 掌握转换算子的使用

- 掌握行动算子的使用

一、RDD的处理过程

- Spark用Scala语言实现了RDD的API,程序开发者可以通过调用API对RDD进行操作处理。RDD经过一系列的“转换”操作,每一次转换都会产生不同的RDD,以供给下一次“转换”操作使用,直到最后一个RDD经过“行动”操作才会被真正计算处理,并输出到外部数据源中,若是中间的数据结果需要复用,则可以进行缓存处理,将数据缓存到内存中。

二、RDD算子

- RDD被创建后是只读的,不允许修改。Spark提供了丰富的用于操作RDD的方法,这些方法被称为算子。一个创建完成的RDD只支持两种算子:

转换(Transformation)算子和行动(Action)算子。

(一)转换算子

- RDD处理过程中的“转换”操作主要用于根据已有RDD创建新的RDD,每一次通过Transformation算子计算后都会返回一个新RDD,供给下一个转换算子使用。

- 常用转换算子操作的API

| 转换算子 | 相关说明 |

| filter(func) | |

| map(func) | |

| flatMap(func) | |

| groupByKey() | |

| reduceByKey(func) |

(二)行动算子

- 行动算子主要是将在数据集上运行计算后的数值返回到驱动程序,从而触发真正的计算。

- 常用行动算子操作的API

三、准备工作

(一)准备文件

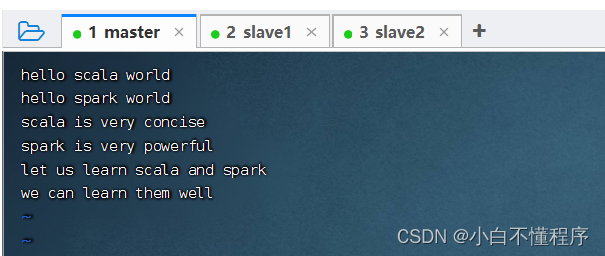

1、准备本地系统文件

- 在

/home目录里创建words.txt

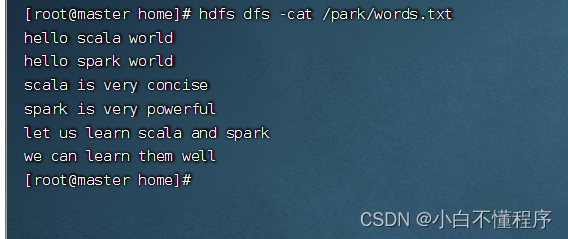

2、把文件上传到HDFS

- 将

words.txt上传到HDFS系统的/park目录里

- 说明:

/park是在上一讲我们创建的目录 - 查看文件内容

(二)启动Spark Shell

1、启动HDFS服务

- 执行命令:

start-dfs.sh

2、启动Spark服务

- 执行命令:

start-all.sh

3、启动Spark Shell

- 执行名命令:

spark-shell --master spark://master:7077

- 以集群模式启动的Spark Shell,不能访问本地文件,只能访问HDFS文件,加不加

hdfs://master:9000前缀都是一样的效果。

四、掌握转换算子

- 转换算子负责对RDD中的数据进行计算并转换为新的RDD。Spark中的所有转换算子都是

惰性的,因为它们不会立即计算结果,而只是记住对某个RDD的具体操作过程,直到遇到行动算子才会与行动算子一起执行。

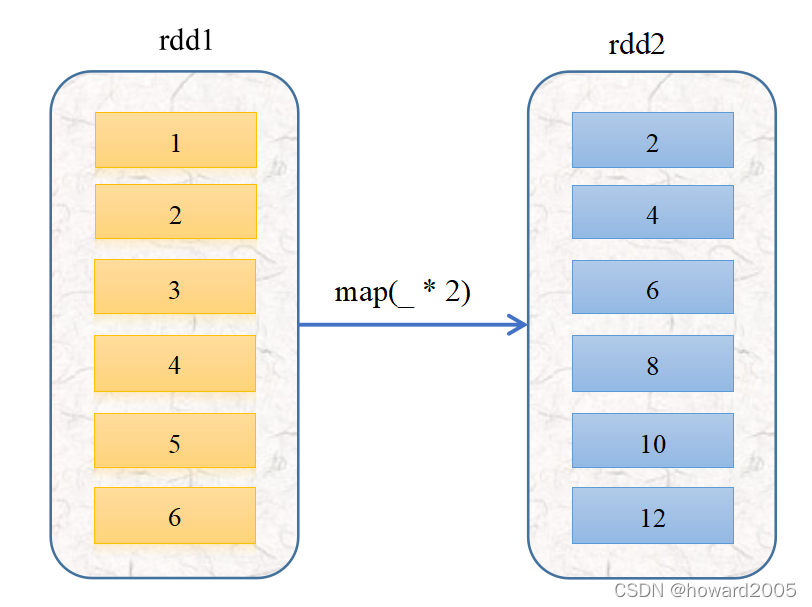

(一)映射算子 - map()

1、映射算子功能

- map()是一种转换算子,它接收一个函数作为参数,并把这个函数应用于RDD的

每个元素,最后将函数的返回结果作为结果RDD中对应元素的值。

2、映射算子案例

- 预备工作:创建一个RDD -

rdd1 - 执行命令:

val rdd1 = sc.parallelize(List(1, 2, 3, 4, 5, 6))

任务1、将rdd1每个元素翻倍得到rdd2

-

对

rdd1应用map()算子,将rdd1中的每个元素平方并返回一个名为rdd2的新RDD

-

上述代码中,向算子map()传入了一个函数

x = > x * 2。其中,x为函数的参数名称,也可以使用其他字符,例如a => a * 2。Spark会将RDD中的每个元素传入该函数的参数中。 -

其实,利用神奇占位符

_可以写得更简洁

rdd1和rdd2中实际上没有任何数据,因为parallelize()和map()都为转化算子,调用转化算子不会立即计算结果。

-

若需要查看计算结果,则可使用行动算子

collect()。(collect是采集或收集之意) -

执行

rdd2.collect进行计算,并将结果以数组的形式收集到当前Driver。因为RDD的元素为分布式的,数据可能分布在不同的节点上。

- 总结

-

take action: 采取行动。心动不如行动。

-

上述使用

map()算子的运行过程如下图所示

- 函数本质就是一种特殊的映射。上面这个映射写成函数:f(x)=x,x∈R

任务2、将rdd1每个元素平方得到rdd2

-

方法一、采用普通函数作为参数传给map()算子

-

方法二、采用下划线表达式作为参数传给map()算子

-

刚才翻倍用的是

map(_ * 2),很自然地想到平方应该是map(_ * _)

-

报错,

(_ * _)经过eta-expansion变成普通函数,不是我们预期的x => x * x,而是(x$1, x$2) => (x$1 * x$2),不是一元函数,而是二元函数,系统立马就蒙逼了,不晓得该怎么取两个参数来进行乘法运算。 - 难道就不能用下划线参数了吗?当然可以,但是必须保证下划线表达式里下划线只出现

1次。引入数学包scala.math._就可以搞定

- 但是有点美中不足,rdd2的元素变成了双精度实数,得转化成整数

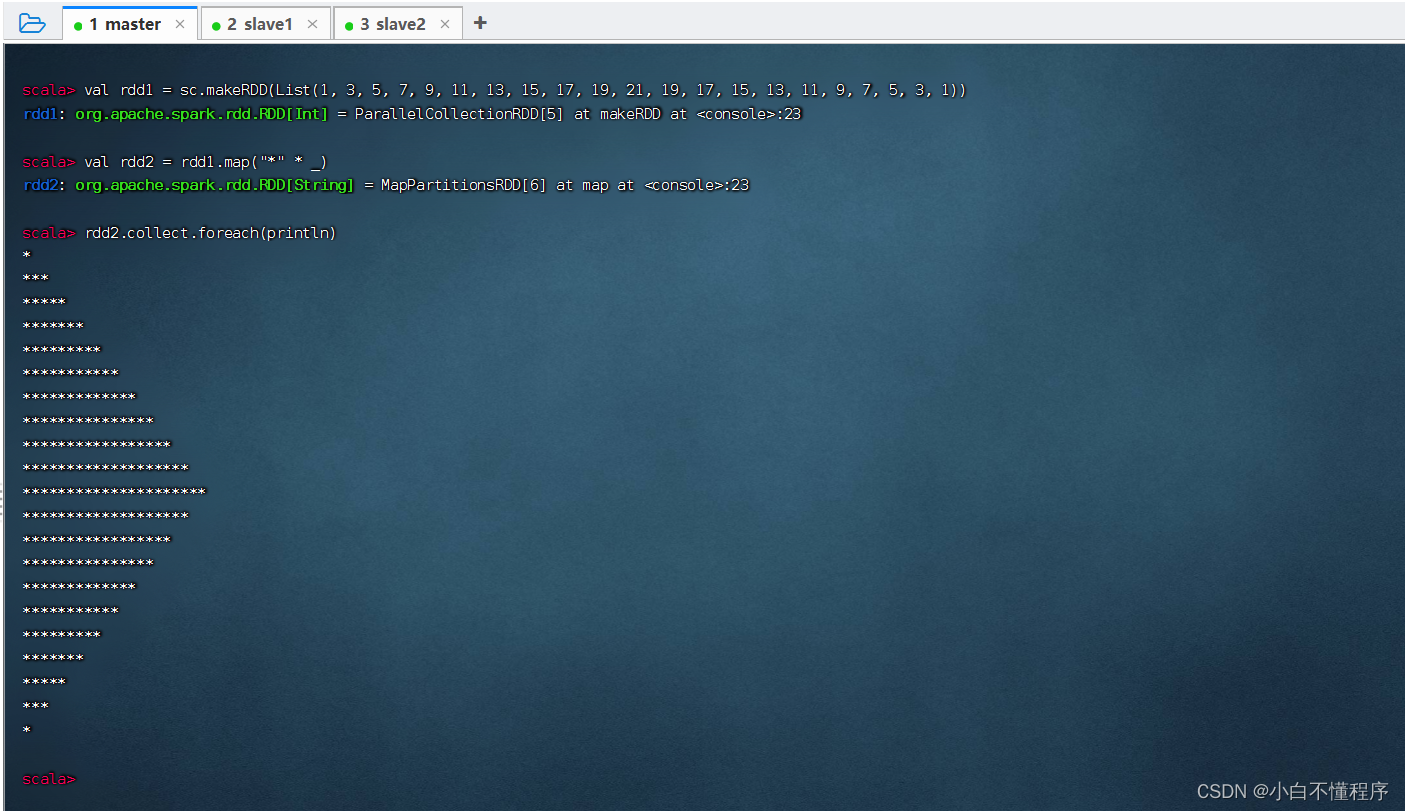

任务3、利用映射算子打印菱形

- 菱形正立的等腰三角形和倒立的等腰三角形组合而成

- 半菱形

- 加上前导空格,显示菱形

(2)在IDEA里创建项目实现

- 参照讲课笔记2.4创建Maven项目 -

SparkRDDDemo

- 单击【Finish】按钮

- 将

java目录改成scala目录

- 在

pom.xml文件里添加相关依赖和设置源程序目录

<dependencies>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>2.12.15</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.1.3</version>

</dependency>

</dependencies>

- 刷新项目依赖

- 添加日志属性文件

log4j.rootLogger=ERROR, stdout, logfile log4j.appender.stdout=org.apache.log4j.ConsoleAppender log4j.appender.stdout.layout=org.apache.log4j.PatternLayout log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n log4j.appender.logfile=org.apache.log4j.FileAppender log4j.appender.logfile.File=target/spark.log log4j.appender.logfile.layout=org.apache.log4j.PatternLayout log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

- 创建

hdfs-site.xml文件,允许客户端访问集群数据节点

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1434

1434

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?