今天继续分享 Dify 智能体搭建的相关内容。

最近在关注大模型长期记忆的问题,前天分享了阿里开源的 MemoryScope 项目:

如何赋予AI智能体长期记忆?阿里开源 MemoryScope 实战,全程免费

无奈本地配置环境略显繁琐,对小白不是特别友好。

有没有可能在 Dify 上搭建一个类似的智能体,实现大模型长期记忆?

琢磨之余,发现 Dify 的官方案例中就有一款类似的智能体。

今日分享,把搭建过程拆解后分享出来,希望对有类似需求的你,有所启发。

参考上篇教程,相信你已完成 Dify 本地安装,若资源有限,也可使用官方的在线体验地址。

1. 官方案例

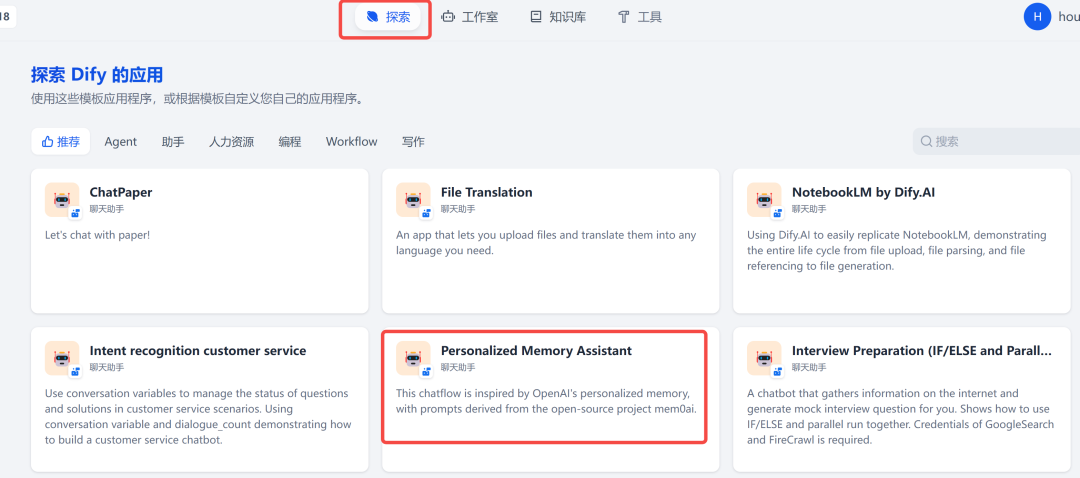

在 Dify 首页,第一个 Tab,官方内置了众多搭建好的智能体案例:

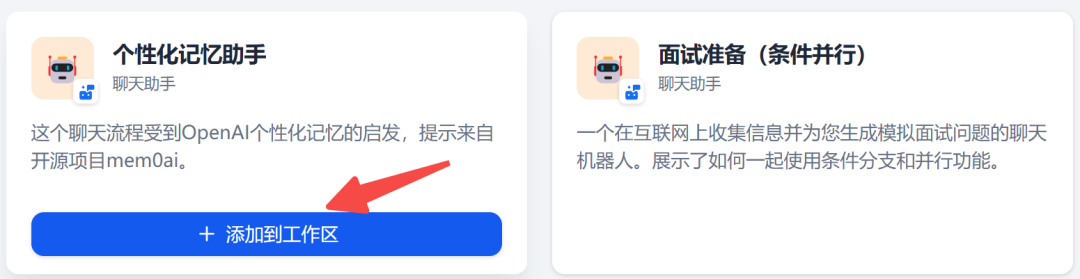

其中,有一个个性化记忆助手的智能体,点击添加到工作区:

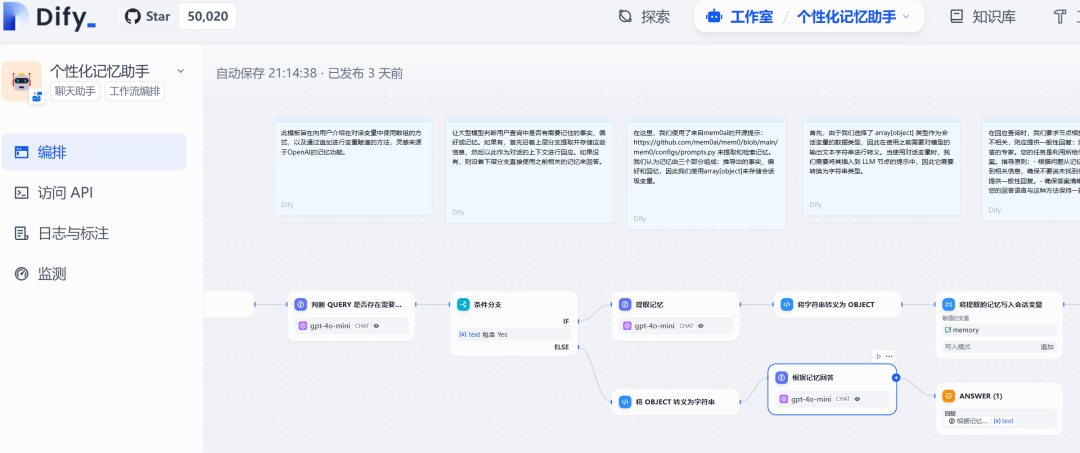

在自己的工作室,可以看到这个智能体已复制进来:

点进来,就可以看到所有的编排逻辑,然后可根据自己需求进行修改:

1. 了解会话变量

Dify 中内置了一个全局变量 – 会话变量,在右上角:

这个会话变量具体有什么用?

和多轮对话的内容一样,它也可以作为 LLM 的上下文,不过它的自定义程度更高。

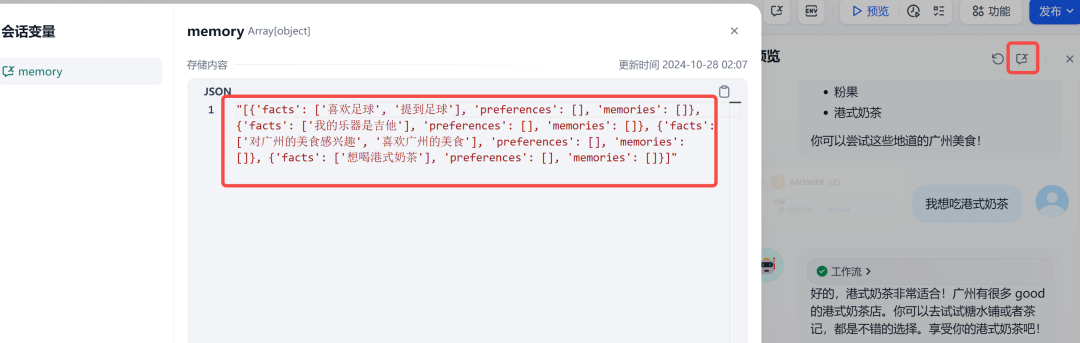

比如在本文的智能体中,就定义了memory这样的会话变量,用来存储需要大模型记忆的信息。

问题来了:memory是怎么发挥作用的?

下面我们一起去探一探。

2. 智能体拆解

step 1 信息过滤: 判断用户输入中是否需要记忆的信息:

从上面的提示词,可以看出,这个节点上大模型只需输出 Yes 或 No,所以下个节点应该是条件判断。

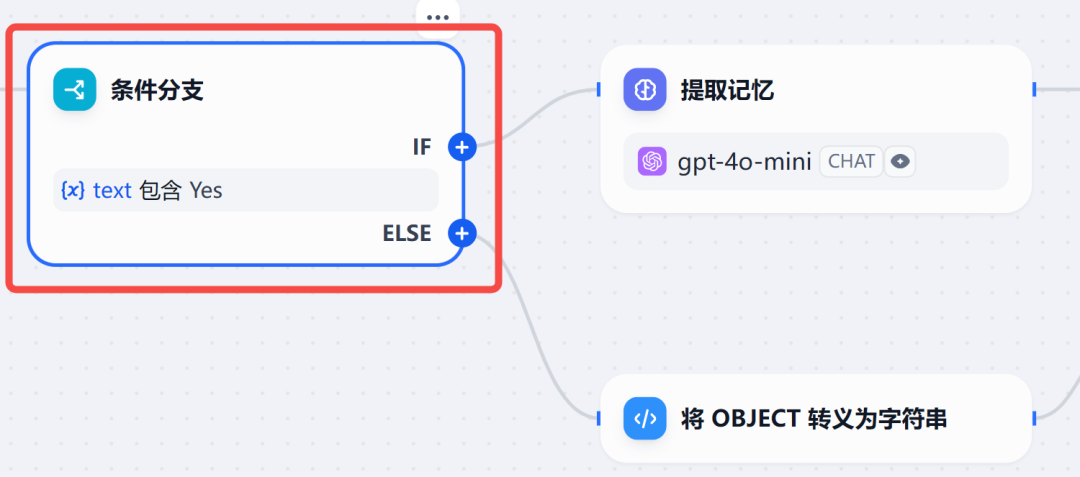

step 2 条件判断:根据上一步大模型输出的 Yes 或 No,分别路由到不同的分支,如果有需要记忆的信息,则执行上方提取记忆的分支,否则走下面的分支。

step 3 提取记忆:通过大模型的角色设定,从用户输入中提取出值得记忆的信息。

在提示词中,指定了提取的三种类型记忆:

"facts": [], "preferences": [], "memories": []

step 4 存储记忆:这一步是代码节点,通过编写简单的 Python 代码,将上一步的记忆信息,保存到一开始定义的会话变量 - memory中。

step 5 根据记忆回复:把会话变量 - memory转换成字符串,也就是下图中的{x}result,放到角色提示词中,让大模型根据记忆,进行答复。

至此,基于对话内容中有需要缓存的记忆,上方提取记忆的分支就搞定了。

如果step 2判断为 No,则直接基于已有记忆进行答复,也即下方分支,流程图如下:

3. 效果展示

我在和它进行了几轮对话之后,点开右上角的会话变量,可以发现memory中已经缓存了多条事实类的记忆:

完美!

真的完美么?

相比直接把多条聊天记录作为上下文,这种方式要优雅很多,且极大减少了 Token 消耗量。

不过,个人认为至少还有两点缺陷:

-

随着记忆内容的增多,每次对话,把所有记忆内容都作为上下文,会显得十分冗余,这里可以结合 RAG 来做;

-

每次都从单论对话中提取记忆,缺乏足够的上下文,容易导致记忆内容的断章取义,理想的方式应该从多轮对话中提取有价值的信息;

写在最后

本文通过一个简单案例,带大家拆解并实操了Dify 搭建个性化记忆助手,整体流程比较简单,相信看到这里的你,一定还有很多想法要去实现,快去试试吧~

如果对你有帮助,欢迎点赞收藏备用。

之前微信机器人小爱(AI)的多轮对话,是通过本地缓存上下文信息实现,其实完全可以用本文的智能体替代,后面抽空改造后,再和大家分享!

如何学习AI大模型 ?

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。【保证100%免费】🆓

优快云粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传优快云,朋友们如果需要可以扫描下方二维码&点击下方优快云官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉优快云大礼包:《最新AI大模型学习资源包》免费分享 👈👈

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

👉1.大模型入门学习思维导图👈

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

对于从来没有接触过AI大模型的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。(全套教程文末领取哈)

👉2.AGI大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。

👉3.大模型实际应用报告合集👈

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(全套教程文末领取哈)

👉4.大模型落地应用案例PPT👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(全套教程文末领取哈)

👉5.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(全套教程文末领取哈)

👉6.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(全套教程文末领取哈)

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习

优快云粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传优快云,朋友们如果需要可以扫描下方二维码&点击下方优快云官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉优快云大礼包:《最新AI大模型学习资源包》免费分享 👈👈

234

234

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?