超参数调整

模型 = 算法 + 实例化设置的外参(超参数)+训练得到的内参

所以如果不做交叉验证,就需要划分验证集和测试集,但是很多调参方法中都默认有交叉验证,所以实际中可以省去划分验证集和测试集的步骤。

而有些模型是自带交叉验证的。

每个模型都有自己的超参数,每个超参数都有一定的意义。对于机器学习模型的超参数

通常指模型训练前需要人工设定的参数(例如学习率、随机森林模型中树的深度、迭代次数等),需在模型初始化或训练阶段明确指定。

import pandas as pd

import pandas as pd #用于数据处理和分析,可处理表格数据。

import numpy as np #用于数值计算,提供了高效的数组操作。

import matplotlib.pyplot as plt #用于绘制各种类型的图表

import seaborn as sns #基于matplotlib的高级绘图库,能绘制更美观的统计图形。

# 设置中文字体(解决中文显示问题)

plt.rcParams['font.sans-serif'] = ['SimHei'] # Windows系统常用黑体字体

plt.rcParams['axes.unicode_minus'] = False # 正常显示负号

data = pd.read_csv('data.csv') #读取数据

# 先筛选字符串变量

discrete_features = data.select_dtypes(include=['object']).columns.tolist()

# Home Ownership 标签编码

home_ownership_mapping = {

'Own Home': 1,

'Rent': 2,

'Have Mortgage': 3,

'Home Mortgage': 4

}

data['Home Ownership'] = data['Home Ownership'].map(home_ownership_mapping)

# Years in current job 标签编码

years_in_job_mapping = {

'< 1 year': 1,

'1 year': 2,

'2 years': 3,

'3 years': 4,

'4 years': 5,

'5 years': 6,

'6 years': 7,

'7 years': 8,

'8 years': 9,

'9 years': 10,

'10+ years': 11

}

data['Years in current job'] = data['Years in current job'].map(years_in_job_mapping)导入

库以后筛选字符串,标签编码。

# 连续特征用中位数补全

for feature in continuous_features:

mode_value = data[feature].mode()[0] #获取该列的众数。

data[feature].fillna(mode_value, inplace=True) #用众数填充该列的缺失值,inplace=True表示直接在原数据上修改。

data[feature].mode()会返回一个 pandas.Series ,包含当前列的所有众数(可能有多个,例如某列中多个值出现次数相同且最多时)。

[0] 表示取第一个众数。

划分数据集

from sklearn.model_selection import train_test_split

X = data.drop(['Credit Default'], axis=1) # 特征,axis=1表示按列删除

y = data['Credit Default'] # 标签

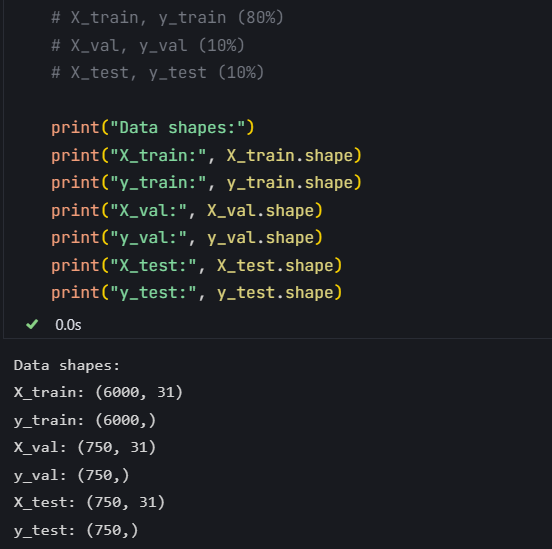

# 按照8:1:1划分训练集、验证集和测试集

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.2, random_state=42) # 80%训练集,20%临时集

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, random_state=42)划分训练集、验证集和测试集,相当于考两次试。

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.2, random_state=42)

这里划分80%的训练集和20%的临时集。

X_train: (6000, 31) 和 y_train: (6000,) 表示划分后的训练集数据形状,具体含义如下:

X_train: (6000, 31)

这是训练集的 特征数据 (输入数据)的形状。

第一个数字 6000 表示训练集中有 6000个样本 (即6000条数据记录)相当于6000行数据。

第二个数字 31 表示每个样本有 31个特征 (即每条数据包含31个用于模型训练的变量)。

y_train: (6000,)

这是训练集的 目标数据 (输出标签)的形状。

数字 6000 表示训练集中有 6000个样本的标签值 (每个样本对应一个目标值,例如分类问题中的类别或回归问题中的数值)。

调参方法

主要包括

1. 随机搜索 : 在参数空间中随机选择参数组合,然后使用交叉验证来评估每个组合的性能:

2. 网格搜索

3. 贝叶斯优化

# --- 1. 默认参数的随机森林 ---

# 评估基准模型,这里确实不需要验证集

print("--- 1. 默认参数随机森林 (训练集 -> 测试集) ---")

import time # 这里介绍一个新的库,time库,主要用于时间相关的操作,因为调参需要很长时间,记录下会帮助后人知道大概的时长

start_time = time.time() # 记录开始时间

rf_model = RandomForestClassifier(random_state=42)

rf_model.fit(X_train, y_train) # 在训练集上训练

rf_pred = rf_model.predict(X_test) # 在测试集上预测

end_time = time.time() # 记录结束时间

print(f"训练与预测耗时: {end_time - start_time:.4f} 秒")

print("\n默认随机森林 在测试集上的分类报告:")

print(classification_report(y_test, rf_pred))

print("默认随机森林 在测试集上的混淆矩阵:")

print(confusion_matrix(y_test, rf_pred))

787

787

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?