开源好,真是好,

DeepSeek现在在各个行业落地(做推理),

我们直奔重点,

推理(Inference)的时候,

下面的底座重要吗?

底座是一整套系统软件,是幕后英雄,

我们距离这个底座最近的那次是,

DeepSeek开源七天大放送。

开源出来一堆英文名,

好多人一看不知道具体干啥,

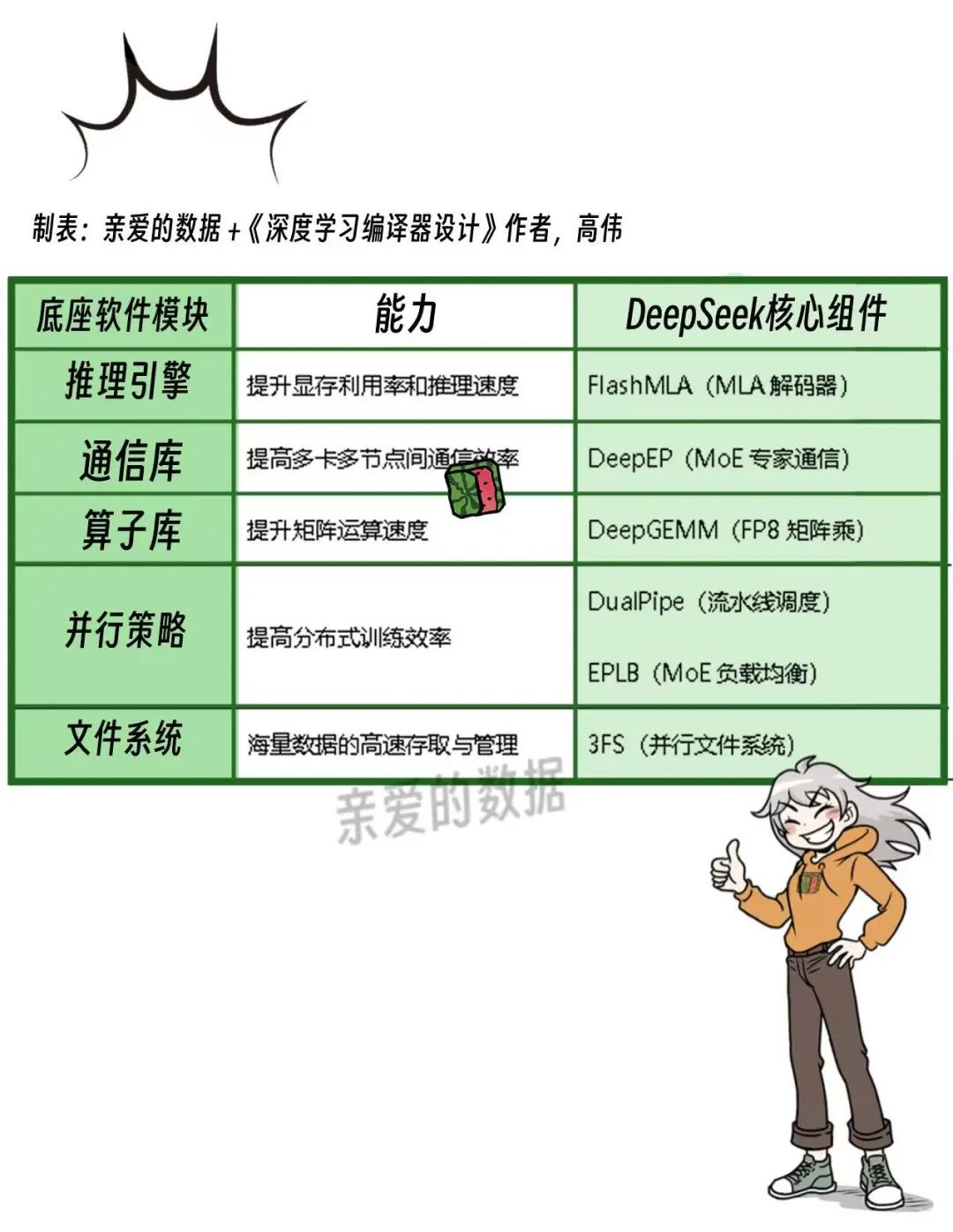

这些,都是“底座”的核心组件。

DeepEP、3FS、DualPipe……

这不是炫技,是一个现代AI云,

所需的基础设施能力栈。

大模型要跑得好,

光有算力(私有化部署,公有云)还不够,

要能“跑得快,还“吞吐量大”,

这就靠“底座”了。

这玩意有多重要呢?

如果不开源,

所有的云厂商都关起门,自己建设自己的。

为啥呀?核心竞争力。

反正云厂商就两条路:

套着自己马车(模型)赚钱,

套着别人马车(开源模型)赚钱,

无论哪条路,都要推理(inference)系统好。

说到DeepSeek开源,还有个“内部笑话”

一开始,没说会把底座里的哪几个重要组件开源,

于是,有实力的云厂商,

注意,还得是有实力,

立马埋头苦干。

那些没实力的厂商,只能干瞪眼。

结果,抓马了,那些有实力的团队一顿忙活,

白受累了,DeepSeek开源了。

这次轮到没实力的厂商笑弯腰了,

直接捡便宜了。

所有人全部回到起点。

其实勤奋的研发同学不白做,

在认知上肯定有提高,

说到这,无论谁想把DeepSeek玩好,

底座就非常重要了,

说俗一点,只要这种底层软件厉害,

云计算的服务就可以卖上价了。

因为这个软件可以和模型,

和算力一起卖,利润高,很赚钱。

这种软件是推理(Inference)的基础软件。

DeepSeek之后,

大厂把重点工作进一步向模型的推理能力倾斜,

如何支持推理那就太重要了。

这种系统软件主要有两个重点,

稳定和容错。

谈到赚钱,这部分服务成本有两部分构成:

第一基础软件人力成本,

没错,就是一帮技术扎实,头脑聪明的人,

没日没夜加班干出来的,

于是,阿里字节百度的办公大楼里,

凌晨的灯光,

少不了是基础软件团队在熬夜加班。

第二,英伟达芯片的使用成本,

也粗说就是机器成本。

这是成本是固定的,

没有什么让利和打折的空间。

当然,我们抛开政府部门补贴,

别人家老旧机型而省下来的钱。

如果你是国产芯片,那就另说。

有位大神举了个例子。

如果有个电厂烧钱免费让你用他家的电,

为了价格优惠,电厂必然亏本,客户来了不少。

过一段时间,你就对这家电厂有忠诚度了么?

不,因为电是标品。

AI基础软件也是标品,

A云厂商有,B云厂商有,C云厂商也有。

所以,第一步,先成为标品,

不要亏本的标品,

在标品的市场上,因为技术差,

成本就会高,利润就少了。

下一步,拉着模型赚钱。

闭源模型厉害,开源就是落后生产力,

开源模型厉害,闭源就是落后生产力,

落不落后,不看性格,不看基因,

只看生产力先进与否。

闭源的出发点就是想把底层算力,

中层模型绑在一起卖。

出发点没错,任何一个理性经济主体都这么思考,

难点在于竞争太激烈,俗称,太卷了。

开源项目(如Llama,DeepSeek),

不断挑战闭源商业模型。

一旦开源社区拿下了性能和成本的制高点,

闭源厂商压力巨大。

都这样了,就积极拥抱吧。

那如何赚钱呢?

这是云厂商要思考的问题,

我的观察是,

云厂商想通过通用模型本身筑就壁垒几乎不可能。

但是,当下,

可以筑就“模型+底座软件”的壁垒。

这也是DeepSeek的打法,

模型本身开源了,不是壁垒,

加上底座就有壁垒了。

因为底座是为模型设计的。

如果模型自己的,底座软件自己的,

连芯片也是自己的,

那真的就是太好了,

谭老师我已经在你办公室门口了,开门啊。

这类厂商想把DeepSeek推理的吞吐做大,好难。

模型即服务明显利润更高,

即便是这个模型不是你的。

这件事的早期,考验云厂商什么呢?

考验造出一套适配DeepSeek的底座软件的能力。

我都不说这套系统有多好,

你得先有。

后面,大家就都有了,而且谁也不会差。

还有一个问题,以前的底座不能继续用吗?

DeepSeek和之前以Llama系列,

通义千问72B为代表的模型架构不同,

怎么不同呢?打个并不贴切的比喻,

一个是直升飞机,一个是固定翼飞机。

你之前不是有停机坪能支持直升飞机起降吗?

能支持固定翼飞机起降吗?

轻轻柔柔一句话,

能支持,就是要再铺一条跑道。

只有真正干“底座”的人,

才知道这句话的份量有多重。

那些跑在英伟达GPU上的云厂商基础软件团队,

无奈背过脸轻轻擦去脸上的泪水,

那些非英伟达AI芯片吞吐量想做大就更累了。

因为DeepSeek是在英伟达上训练出来的模型,

如果你也把模型部署在英伟达GPU上,

大可以抄作业,

相反,就没有作业可抄。

不过,好消息是,非英伟达AI芯片才有壁垒。

大家都知道,

固定翼飞机要一定长度的跑道起降。

那些之前都是玩直升机的云厂商,

相当于只有停机坪,没有跑道,

需要提供DeepSeek的API接口给客户用,

就得从头开始铺跑道。

那么啥也憋说了,赶紧造吧。

在这个值得纪念的,2025年的蛇年春节,

所有的云厂商AI基础软件团队都在疯狂加班,

原因就是这个。

而且,这个破班到现在,

到4月第一周了,都没有加完。

一位在百度干这个活的小哥哥发的朋友圈说,

史上最夸张的加班。

为什么呢?因为难,因为还在猛干提高。

头部云厂商的AI基础设施团队,都是一流团队。

弄了这么久只有一个原因,就是难。

美国硅谷AI芯片创业团队的核心研发给我说,

他要做一个轻版本,尽快给客户用,

还要再做一套重版本,把每一个细节都设计好。

为什么要这样呢?

他告诉我的原话是:

“难度陡然提升的原因是,

DeepSeek模型的思路和其它开源模型不一样。

需要打破以前的惯例,

为他量身定制一套部署。

若还是Llama老路倒简单了。”

要知道,推理速度快和打满是两个技术路线,

勋章属于“能在吞吐量上打败所有人的英雄”。

云厂商的基础软件团队不是吃白饭的,

这个时期,要有一套基础软件,能够媲美,

甚至超过DeepSeek原装那套。

只有这样才能赚钱。

如果价格比DeepSeek低,

你的成本还比它高,那就惨了。

这个时候的性价比,就和技术大大的相关了,

这里是云厂商AI的正面战场,

请享受这无可回避的痛苦。

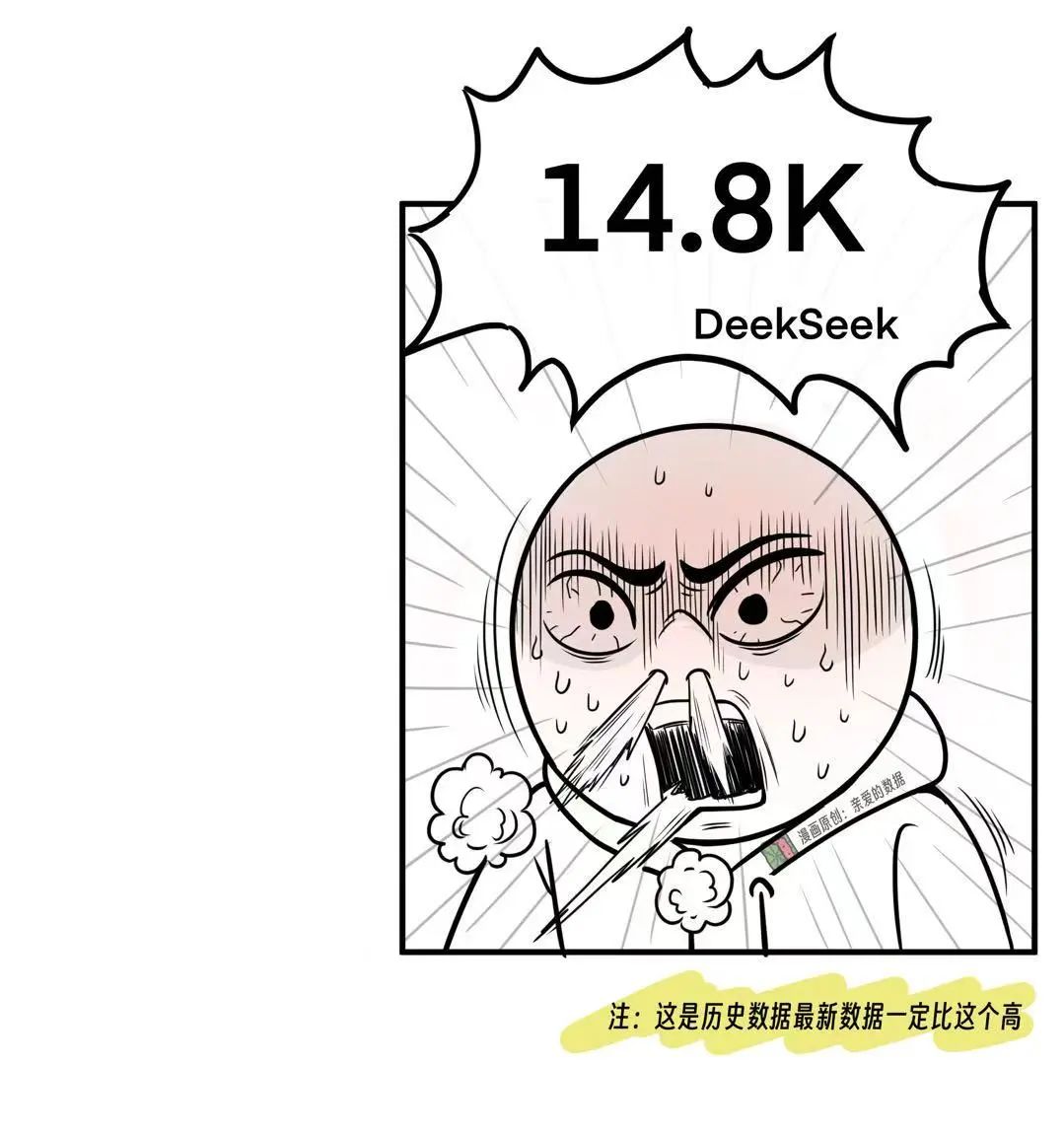

说个有意思的,

老读者都知道谭老师很喜欢和CTO对暗号。

如果你想显示你很懂DeepSeek,

那有一个数据必须脱口而出,

说实话,谭老师我见到大神CTO的时候,

报出的暗号就是14.8K。

只要能报出这个数字,那就是自己人了。

要不知道这个数字,

那咱们就不再是朋友了。

技术浓度最高的部分就要来了。

14.8K是什么呢?是一个标杆速度,

输出吞吐约14.8ktokens/s,

也就是大模型一秒钟吐出大约吐出15万个词元。

为什么DeepSeek做到了?

这就说明它在基础软件(PD分离调度、批量吞吐调优、算力利用率、KV Cache管理等)多个方面都非常顶,非常顶。

只追赶14.8K这一个指标就够了吗?当然不够。

因为不同客户,不同场景的要求不同,

要做定制化调整,

比如,对话客服机器人,

用户只说了几句话,

然后模型要连续生成很多回答的内容,

生成工作量大,速度不能慢;

而搜索增强生成(RAG)或如法律合同分析则不然,常常是输入量大。

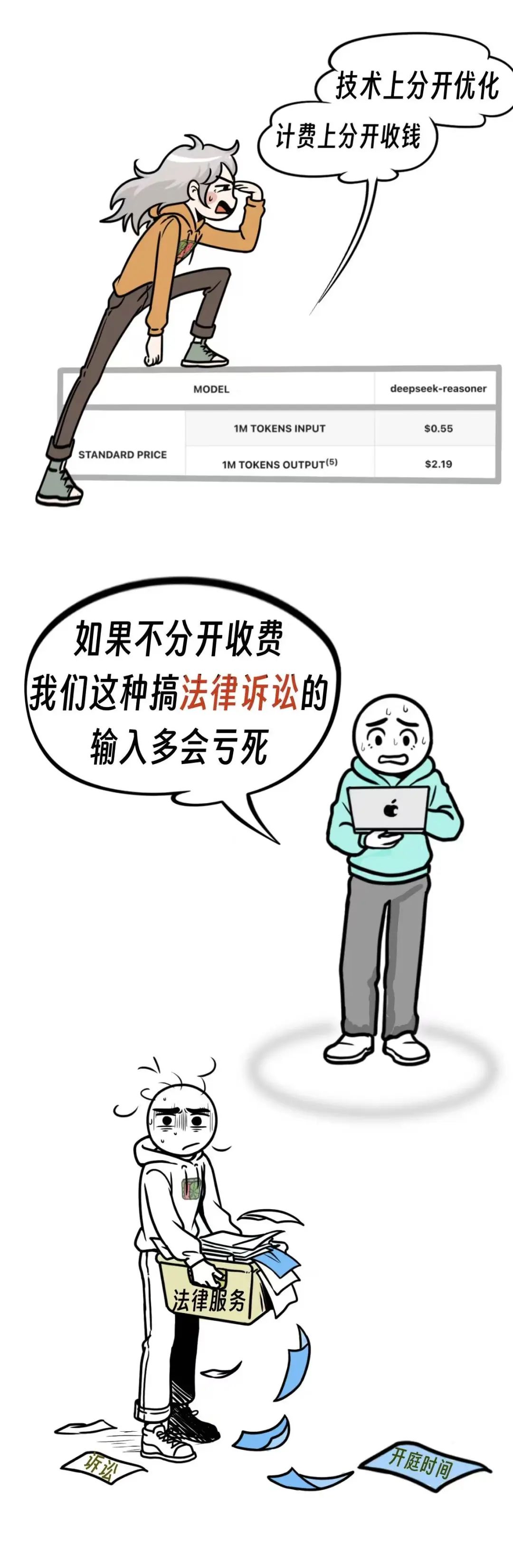

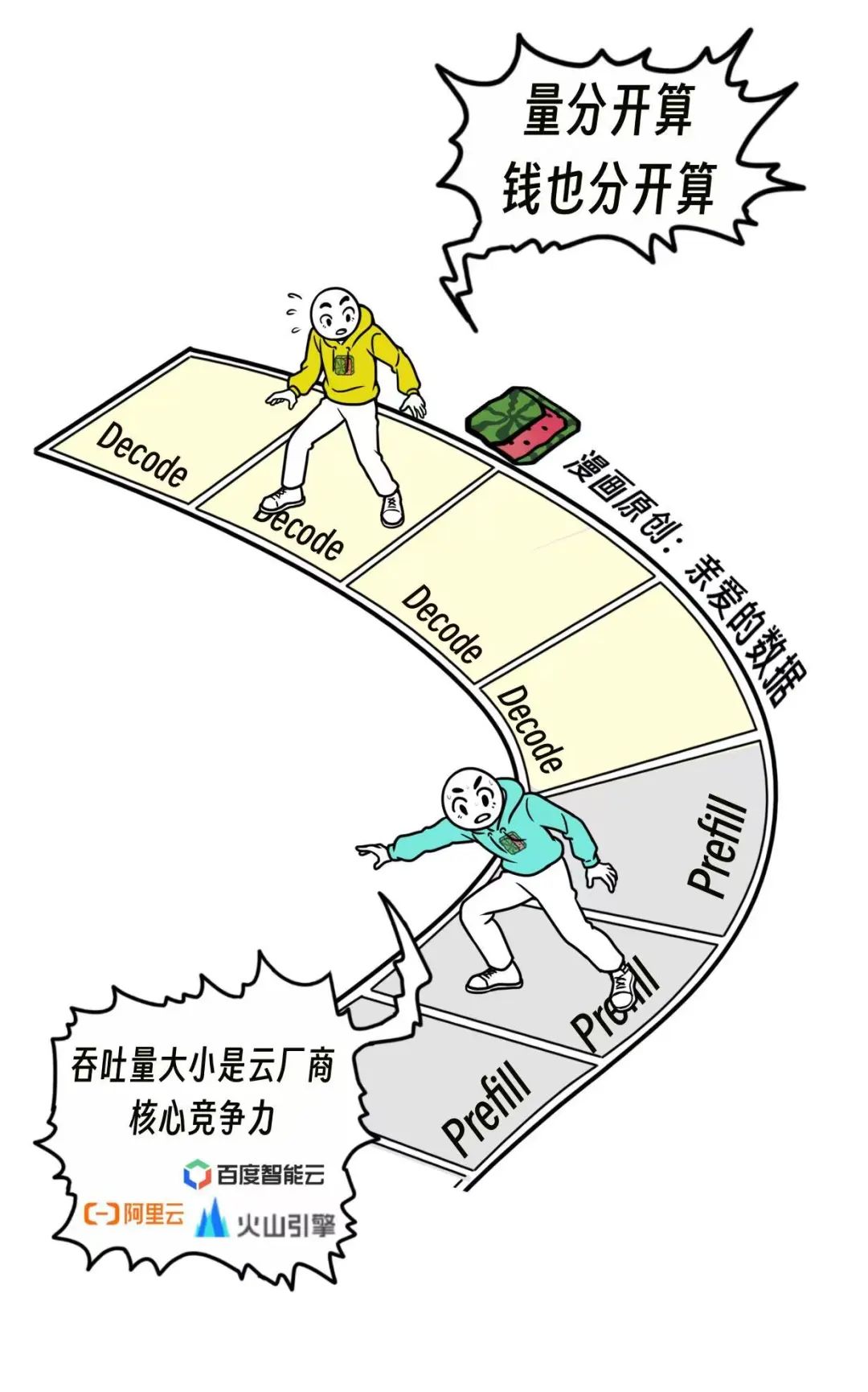

技术语是Prefill和Decode分离,俗称PD分离,

速度是分开优化的,

当然,钱也得分开算的。

Prefill的成本是多少,Decode的成本又是多少。

换句话说,只要做到这个数,

利润率基本接近DeepSeek原厂的了。

那天去海淀区上地奎科大厦喝奶茶,

百度智能云的技术小哥哥和我说,

他们已经很接近这个数了,

为了证明这件事的真实性,

我和他继续聊细节,我们讨论了赚钱的套路:

DeepSeek R1标价是每一百万个词元:

输入4块,输出16块;

他认为DeepSeek R1成本是输入三毛,

输出1块7毛。

很显然,DeepSeek R1很赚钱。

假设每个厂商都有数量和型号相同的芯片,

谁的系统的总吞吐量最高,谁就最赚钱。

前段时间,

美国硅谷那边的技术小哥哥和我聊了聊。

技术方面,对比DeepSeek和一众友商的吞吐,DeepSeek高了10倍。

怎么做到的?

第一,改动自注意力和FFN计算顺序,

内存瓶颈转为通信瓶颈,节省时间2倍。

第二,KVCache 占比30%,batchsize可以变大,提升2倍,

第三,TP转EP,提升2.5倍。“

这就是10倍的由来。

当使用DeepSeek的需求激增,

好的AI全链路软件是云厂商AI业务的生命线。

另外,吞吐量是各家都一直在努力提高的,

属于动态数据,

咱们谁也别刻舟求剑。

云厂商如果彻底跟不上DeepSeek,

自家的AI全链路软件就等着落后,

开源大模型默认不适配任何一家云厂商的底层软硬件或优化路径,苦干是唯一的选择。

这也是为什么你会看到,

阿里、腾讯、字节、百度,

都在投入专属系统,

做的其实和 DeepSeek 非常类似。

推理基础设施必须自建吗?或者能“白嫖”吗?

可以这样说:

如果你是云厂商,不搭一套推理基础设施,

就像搞电商不建物流系统。

模型可以不是自己原创的,

只要别人好就上别人的。

云厂商本质是水电煤气基础设施提供商,

只是模型如果是自己的,整套卖那就更赚钱,

而且模型是打磨底座的利器,

没有好模型,云厂商出去卖底座,

都会被人质疑“零经验”。

但要想用开源模型“量大,稳定且挣钱”,

这套底座,少得了吗?

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?