一、提出任务

分组求TopN是大数据领域常见的需求,主要是根据数据的某一列进行分组,然后将分组后的每一组数据按照指定的列进行排序,最后取每一组的前N行数据。

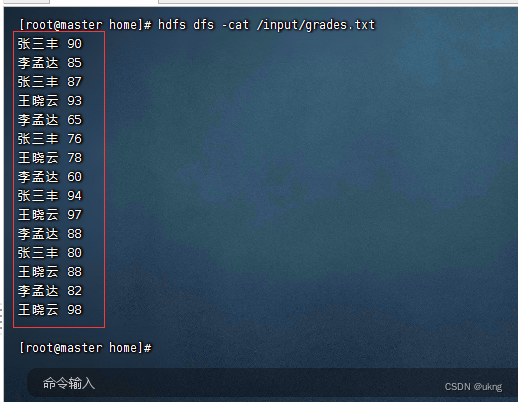

- 有一组学生成绩数据张三丰 90

- 李孟达 85

- 张三丰 87

- 王晓云 93

- 李孟达 65

- 张三丰 76

- 王晓云 78

- 李孟达 60

- 张三丰 94

- 王晓云 97

- 李孟达 88

- 张三丰 80

- 王晓云 88

- 李孟达 82

- 王晓云 98

- 同一个学生有多门成绩,现需要计算每个学生分数最高的前3个成绩,期望输出结果如下所示:

- 张三丰:94 90 87

- 李孟达:88 85 82

- 王晓云:98 97 93

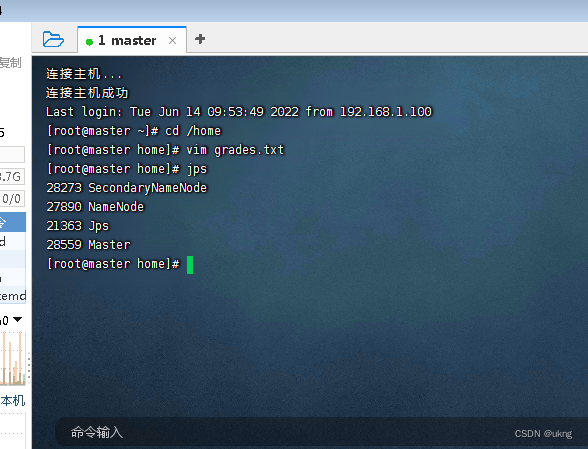

预备工作:启动集群的HDFS与Spark

将成绩文件 - grades.txt上传到HDFS上/input目录

- 实现思路:使用Spark RDD的

groupByKey()算子可以对(key, value)形式的RDD按照key进行分组,key相同的元素的value将聚合到一起,形成(key, value-list),将value-list中的元素降序排列取前N个即可。

二、完成任务

(一)新建Maven项目

设置项目信息(项目名、保存位置、组编号、项目编号)

将java目录改成scala目录

本文介绍如何使用Spark RDD处理大数据场景中分组求TopN的问题。通过一个学生成绩案例,展示了如何将成绩数据上传到HDFS,然后利用Spark RDD的分组和排序功能,计算每个学生分数最高的前3个成绩。具体步骤包括新建Maven项目、添加依赖、创建日志属性文件以及编写分组排行榜单例对象。

本文介绍如何使用Spark RDD处理大数据场景中分组求TopN的问题。通过一个学生成绩案例,展示了如何将成绩数据上传到HDFS,然后利用Spark RDD的分组和排序功能,计算每个学生分数最高的前3个成绩。具体步骤包括新建Maven项目、添加依赖、创建日志属性文件以及编写分组排行榜单例对象。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1058

1058

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?