节前,我们组织了一场算法岗技术&面试讨论会,邀请了一些互联网大厂朋友、今年参加社招和校招面试的同学。

针对大模型技术趋势、算法项目落地经验分享、新手如何入门算法岗、该如何准备面试攻略、面试常考点等热门话题进行了深入的讨论。

总结链接如下:

喜欢本文记得收藏、关注、点赞。更多实战和面试,欢迎文末加入与我们交流

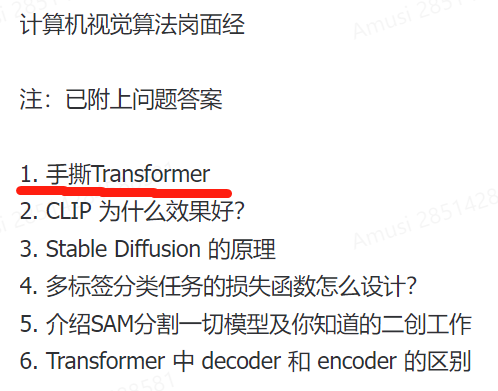

这两天求职群分享了很多大厂的计算机视觉算法的面试真题,其中就有“手撕Transformer”:

要知道近年来特别出现了很多Transformer面试题(毕竟当前AI顶流)。这里我特别分享18道Transformer高频面试题(求职群里有数百道Transformer题目,还有答案),希望对你有所帮助。

-

位置编码有哪些?

-

ViT为什么要分patch?

-

介绍Transformer和ViT

-

介绍Transformer的Q,K,V

-

介绍Layer Normalization

-

Transformer训练和部署技巧

-

介绍自注意力机制和数学公式

-

画图说明 Transformer 基本流程

-

介绍Transformer的Encoder模块

-

介绍Transformer的Decoder模块

-

Transformer和Mamba(SSM)的区别

-

Transformer中的残差结构以及意义

-

为什么Transformer适合多模态任务?

-

Transformer的并行化体现在哪个地方?

-

为什么Transformer一般使用LayerNorm?

-

Transformer为什么使用多头注意力机制?

-

Transformer训练的Dropout是如何设定的?

-

Transformer 模型中的自注意力机制是如何工作的?

1381

1381

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?