一、Mini-batch算法

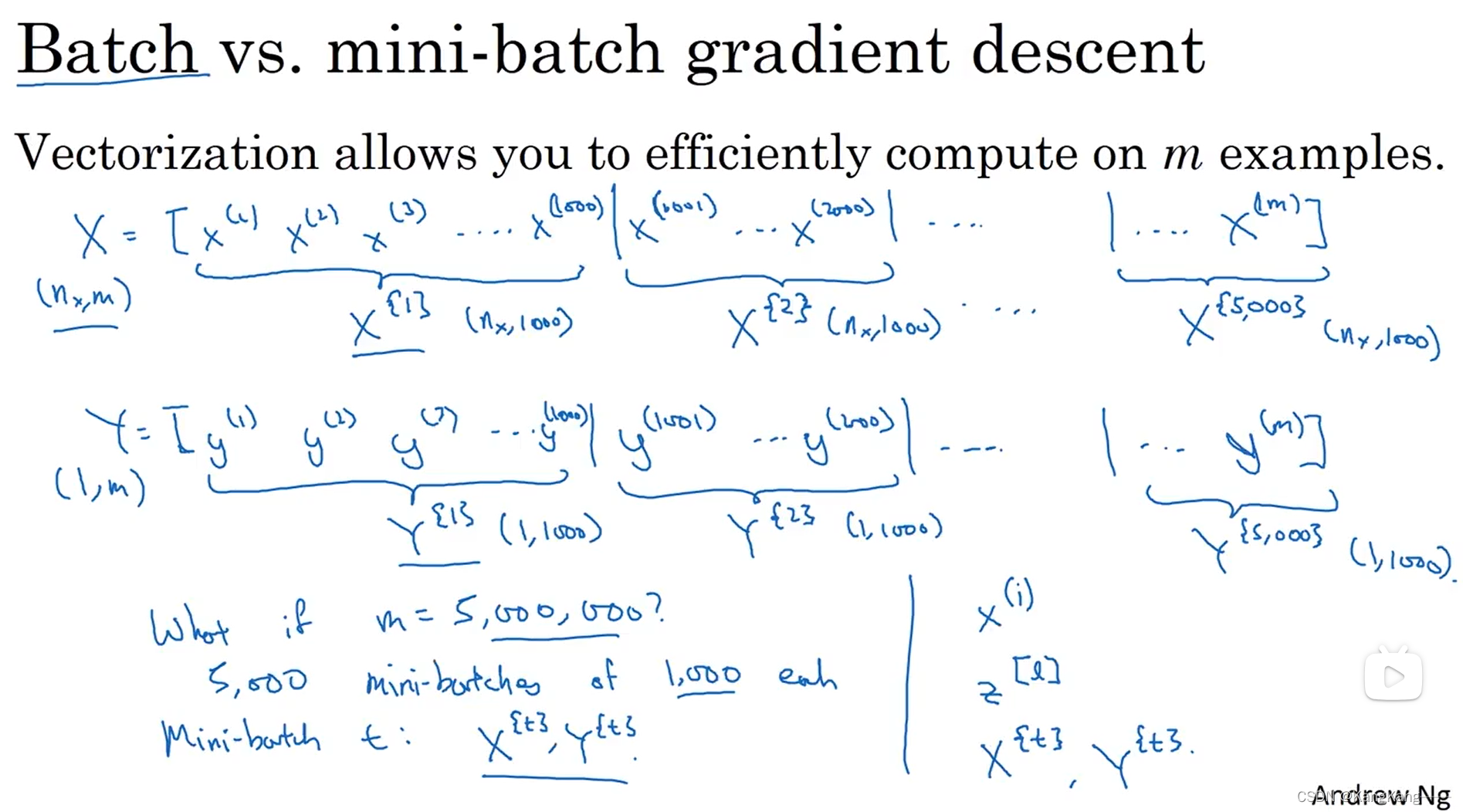

把训练集分割为小一点的子训练集,即Mini-batch.

1.Mini-batch方法

2.Batch成本函数 vs Mini-batch成本函数

Batch成本函数会逐渐递减。

Mini-batch成本函数会上下振动,但总体趋势还是递减。

3.Mini-batch大小的选择

1.两种极端情况:

(1)梯度下降法

若Mini-batch大小为batch, Mini-batch为整个训练集,,称为梯度下降法。

若使用梯度下降法,mini-batch=m,则每个迭代需要处理大量训练样本。

缺点:若数据量很大时,单次迭代耗时太长。

(2)随机梯度下降法

若Mini-batch大小为1, Mini-batch为单个样本 ,,称为随机梯度下降法

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9461

9461

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?