DEEP GRAPH INFOMAX (DGI) 论文解析

往期相关推送(持续更新中!):

[ICASSP 2024] CDNMF: 一个可信且高效的社区检测(社区发现,图聚类,Community Detection)方法-优快云博客

Motivations

- 图结构无监督学习的目标函数主要是基于随机游走的思想构造的。即让原本邻近的节点学习出“相似”的表达,尽管取得了不错的效果,但存在两大缺陷:(1)过分强调邻接信息,而忽略了整体图结构的信息。(2)这样设计的算法对超参数敏感。

- Deep InfoMax在图像数据集上表现良好

Contributions

该论文提出了一种基于互信息而不是随机游走的无监督图学习的目标函数,其将DIM的思想应用到图结构数据,使学习出的节点表示包含全局的信息,这样可以学习出远距离节点的相似性。

Proposed Method

- 问题描述:

- 算法步骤:

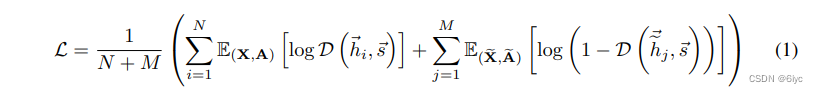

- 基于NCE的目标函数:最大化局部(节点)表示与全局(图)表示的互信息。

由于很多时候无法得知两个分布的解析形式,难以准确计算出他们的互信息。此处是基于局部变分技巧来进行快速地估算。(具体推导出自f-GAN: Training Generative Neural Samplers using Variational Divergence Minimization)

判别器D:

总体示意图:

Experiments

设置:

W是可学习的,激活函数\sigma将分数转化为(h_{i},s)是正样本的概率。(文中也理论证明了最小化分类误差的同时也一定程度最大化了局部与全局的互信息)

Conclusions && Tips

- 该论文通过对比节点嵌入与图嵌入的互信息来获得含有全局信息的节点表示,的确要比直接最小化他们的范数误差更自然。

- 在另一篇论文Graph Contrastive Learning with Augmentations 中,严格地表明GraphCL (NT-Xent)可以看作是两种增强图的潜在表示之间的互信息最大化。将对比学习的目标函数与互信息最大化联系起来,这也许是对比学习在图结构上表现较好的原因之一。

References

[0] Veličković P, Fedus W, Hamilton W L, et al. Deep Graph Infomax[C]//International Conference on Learning Representations. 2018.

[1] Li Y, Chen J, Chen C, et al. Contrastive Deep Nonnegative Matrix Factorization for Community Detection[J]. arXiv preprint arXiv:2311.02357, 2023.

[2] Li Y, Hu Y, Fu L, et al. Community-Aware Efficient Graph Contrastive Learning via Personalized Self-Training[J]. arXiv preprint arXiv:2311.11073, 2023.

1060

1060

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?