知识

广义策略迭代

即策略评估和策略优化不断交互,从而推进

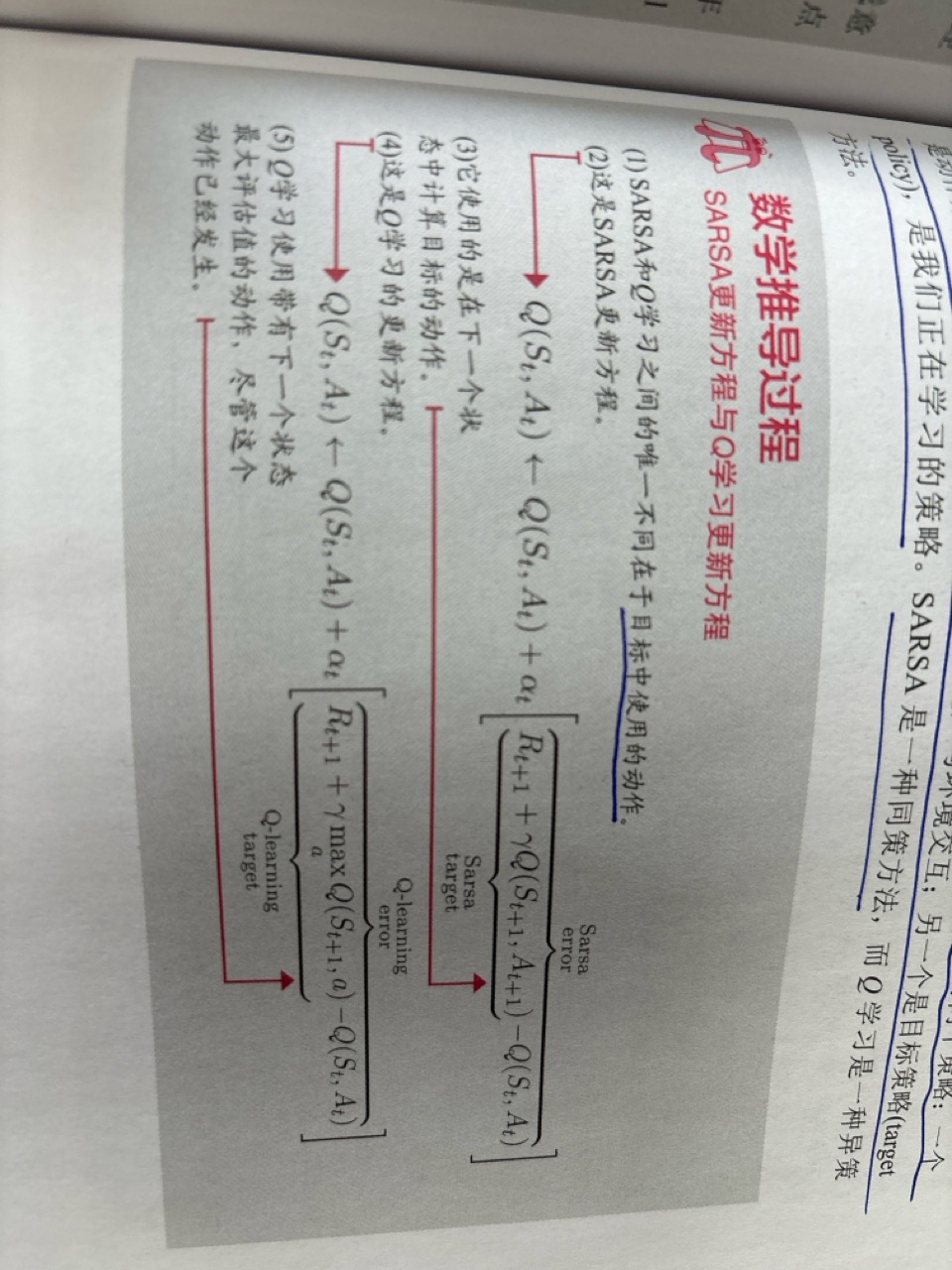

Q学习和SARSA的区别在于TD目标不同,Q学习是异策略,自己的动作选择是贪婪策略,目标选择是最大动作值策略。SARSA是同策略,自己的每一步动作选择是贪婪策略,目标选择的也是贪婪策略。

同策略和异策略之间的差异联系

同策略学习是用来学习用来做决定的策略,可以当作是“在工作中学习”。SARSA。

异策略学习的策略不是用来做决定的策略,可以当作是“从其他经验中学习”.Q-Learing

双Q学习

解决最大化偏差的一个途径是跟踪两个Q函数的估计值。这个双Q学习分为两个部分,一个部分是Q值更新的过程中,计算TD目标的时候用的Q值和得到这个Q值所采取的动作,在同一个时间步下,我们从两个Q函数中选择一个来决定动作,选择Q值最大的那个动作,然后用另外一个Q函数的这个动作的Q值作为这个动作的估计值去计算TD误差。一个是和环境交互的时候,我们选择哪一个动作,我们选择两个Q函数值的和最大的那个动作来和环境进行交互。

策略迭代和价值迭代的区别和联系

在策略迭代的过程中,策略评估使用的是状态价值函数,策略改进使用的是动作价值函数。

策略迭代比价值迭代多了一步,那为什么还要用策略迭代呢

子网掩码:

用来判断主机号和网络号的如一个IP地址是192.128.0.1同时他的子网掩码是255.255.255.0,则这个IP地址的前24位是网络号,后8位是主机号,这个网段下最多一共有2的八次方减2个主机。

默认网关:

局域网内的主机想要访问互联网上的主机必需要通过的设备,默认是路由器上面的LAN口的地址。

DNS:域名解析系统

网址和IP地址之间的映射

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?